Effizienter ja. Aber bei FPS/€ das bessere Niveau (4090 vs. 7900XT). Denk mal an AMPERE anno Dazumal.

Fps/€ mit RT ist die 4090 besser, ohne nicht. Also jetzt nicht wirklich ein echter Kritikpunkt.

Wenn Du im BIOS nicht selber Hand anlegst und den 13000´ern freien Lauf lässt, saufen die bis zum Nimmerland.

Wenn das Bios ab Werk, die CPU außerhalb der Specs betreibt ja klar... Das ist aber auch nicht der Fehler der CPU.

Der FX 9590 war gar nicht so schlecht, wie ihn ein mancher immer hinstellt (siehe Anhang).

Gesoffen hat er, ja, aber interessieren tut es just die INTEL Fraktion auch eher weniger.

Naja, das war nur in ausgewählten Benchs so, im Mittel dennoch eher schmächtig, statt mächtig.

Nö, hab kein Intel, macht keinen Sinn wenn man schon AM4 mit 5800X3D hat.

Aber ist auch völlig egal was ich besitze, ändert ja nichts am schlechten idle Verbrauch der AMD Karten.

Intel Karten sind da übrigens auch nicht besser.

Da habe ich zum Glück die Situation, das ich zwei Rechner nebeneinander stehen habe. Einmal ein hocheffizienten mini PC. Der kann gar nicht anders als nur bis zu 35W aufzunehmen. Daran hängen drei Bildschirme und dann mein Zock Rechner, der mit einer 7900XTX an nur einem Bildschirm hängt. 85Hz, kein Problem mit dem Idle- Verbrauch

Hab ich niemals behauptet. Wenn dann ist dies eine Unterstellung Deinerseits.

Von allen Firmen, von hier bis Kansas, hab ich Hardware am laufen und hab jene völlig OHNE Vorbehalt käuflich erworben.

Du auch ?

Die Häufigkeit, ändert nichts an den Vorbehalten.

Ich denke, das der absolute Großteil der Nutzer hier angeben würde, ohne Vorbehalte zu bauen / kaufen.

Auch die meisten Grabenkämpfe im Forum, basieren nicht auf Fanboytum, sondern nur darauf das jeder unterschiedliche Information, unterschiedlich gewichtet.

Ähm, ich möchte mir an der Stelle erlauben die Damen und Herren bei AMD daran zu erinnern das bereits die 6700 (non-XT) als 1440p-Karte beworben wird.

Wohlgemerkt mit 10 GiB VRAM.

Aber fällt ja sicher keinem auf

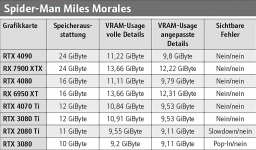

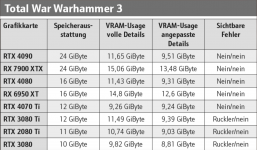

Da möchte ich darauf hinweisen, das diese 10GB Karte im PCGH Test, genauso sichtbare Speicherknappheitzeichen von sich gibt (Ruckler, oder Matsch, Fehler) wie eine RTX3070. Letztendlich verhält sich die auf den Speicher bezogen, genau wie eine RTX3000 mit 8GB.

Dem PCGH Test und allen anderen Tests im Netz dazu, würde ich auch nach wie vor zu dem Schluss kommen, das aktuell 8GB weiterhin ausreichend sind, für 1080p.

Wenn man die verbuggten Spielstarts raus nimmt, gibt es eigentlich nicht wirklich Probleme mit 8GB bei Nvidia. Bei AMD mit 10GB.

Gerade wenn Nvidia bei RTX4000 diese 8GB noch besser genutzt werden, als bei RTX3000, auch wenn RTX4000 nur 100-400MB im VRam sparen kann, sehe ich noch weniger Probleme.

Auch wenn ich mir 16 Spiele anschaue und nur eines dabei ist, bei dem dann wirklich der Speicher zu knapp ist und man mit nicht wirklich sichtbaren Veränderungen (Texturen auf eine niedrigere Stufe) das Problem lösen kann, ändert das nichts daran.

Ich hoffe das PCGH diesen VRam Test regelmäßig wiederholt, denn das Thema hat seine Daseinsberechtigung und ist wichtig.

Wann Ruckler beginnen, oder Matsch kommt, da konnte man schon einen Unterschied zwischen RTX4070ti mit 12GB und 3080ti mit 12Gb ausmachen.

Das alles wäre mit weniger Speichergeiz zwar kein Thema, aber auch 8GB in 1080p reichen noch, wenn man von verbuggten Spielreleases absieht.

Wer also bis zum ersten, oder zweiten Patch warten kann, hat keine echten Probleme.

Was man wem empfiehlt hängt von individuellen Wünschen ab. Wer ein begrenztes Budget hat und sich 1440p ohne RT wünscht ist mit einer 6700XT nicht schlecht beraten, wer Hauptsache RT an in 1080p will mit einer 3060ti(3070, oder 4060ti) und so weiter und so fort...

Keiner bestimmt für wen anders, was wichtig ist.

.gif)