Int und FP Einheiten, nur Nvidia macht ein auf Bulldozer und doppelt die FP Einheit und behauptet es sind jetzt doppelt soviele.

Aber man sieht ja wieviel Leistung davon nur auf die Straße kommt.

4352 2080TI

Vs

10496 3090

Nur 43% mehr Leistung

vergleicht man beide mit OC sind es bei der 3090 nur noch 33% mehr gegenüber der 2080TI.

Nvidia GeForce RTX 3090 im Test: Benchmarks in Ultra HD, mit Raytracing & DLSS / Testsystem und Testmethodik / Benchmarks in 3.840 × 2.160

www.computerbase.de

Aber hey 141% mehr Shader und effizient eine Kartoffelbatterie.

Sind es auch aber nur unter Floting Point und du siehst aktuell noch gar nicht was Ampere auf die Straße bringt!

Weil Spiele auf neue Architekturen Optimiert werden müssen, sobald man Fp in Spielen mehr einsetzt was passiert dann logischerweise.

Doom ist nicht mal das optimale aber es zeigt gut was zu erwarten ist in Zukunft.

Es kommt auch daran wo man es Vergleicht in 1440p hat Ampere nicht verloren, übrigens wurde genau das immer bei AMD begrüsst

der heilige "Fine Wine".

Nur das bei AMD ohne Optimierung die Leistung im Ars... war, Ampere bringt aber Leistung auch jetzt auf die Straße und kostet sogar weniger.

Ach 141% mehr Shader und nur so wenig mehr Leistung? willst mal Fermi gegen Kepler machen?

Fermi 2.0 512 Shader

GTX 780ti 2880 Shader

Beides Vollausbau!

Willst also solche dummen Vergleiche machen? Weist was Fermi hat sogar für die Shader Anzahl sogar recht starke Daten in Cuda.

Also rechne dir mal schön aus wieviel schneller Kepler hätte sein müssen. Shader sind nicht gleich Shader RTX 2080ti Shader

sind nicht vergleichbar mit 3090 Shadern. Die 2080ti hat zwar komplexere Shader die aber bei hoher last deutlich Einbrechen, gerade

bei RT merkt man das deutlich.

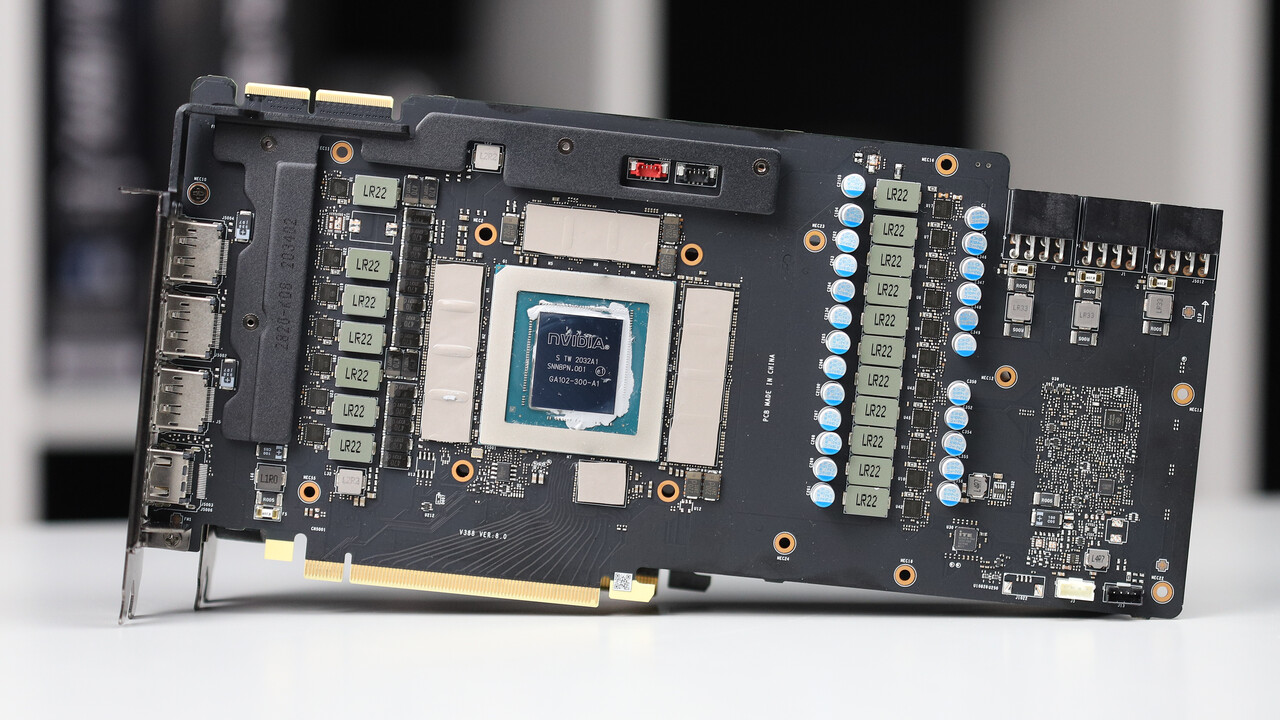

Was meint ihr den immer neue Architektur ist neu und nicht das gleiche in größer. Ampere ist deutlich weiter Entwickelt und eben nicht mehr

Vergleichbar. Pascal und Turing war nur ein sehr kleiner Schritt, doch Ampere ist wirklich mal was neues.

Das man jetzt kritisiert das Shader nicht genauso sind wie die alten ist eher ein Verständnis Problem. Man kann einfach nicht 10K Turing Shader nehmen weil die Leistung und Verbrauch dann überhaupt nicht mehr gehen würden. Außerdem liegt der schnitt zwischen 42% und 55% zu 2080ti Leistung. 33% hat alleine schon die 3080 wenn man 1440p ins Spiel bringt, macht aber nur 4K sind es 40%. Was genau die Steigerung ist die erwartet wurde und sogar als hoch angesehen wurde!

Genauso hätte man von Fermi auf Kepler schließen müssen das man ein paar 100% schneller ist.

Warum sollte das so sein? Weil es mehr Shader sind? Das sagt gar nichts aus dann wäre AMD schon ewig schneller und Ampere hat aktuell noch ein Problem die GPU überhaupt auszulasten.

Sobald Spiele auf Fp Leistung optimiert werden, wird Ampere deutlich zulegen. Dann kann sich AMD wieder beschweren das es zu viel Fließkomma ist und es sei ja Unfair. Amperes wirkliche Leistung werden wir erst später sehen, selbst Turing hat zugelegt.

.gif) Wie gesagt da hatte ich 74 Bilder. Mal sehen vielleicht kaufe ich mir dennoch mal einen neuen Rechner wenn der 5950x bei uns draußen ist und ja ich achte mal auch auf die CPU Auslastung im Manager. Wobei früher bei der alten Karte wenn ich ihn während des Spiels aufgerufen habe war die CPU alles andere als am Limit sondern was mit 60 % und die Grafikkarte war bei 96 %. Ach so und noch etwas. Die Meisten bei Alternate schreiben auch dass die Grafikkarte unter 65 Grad bleibt. Wie gesagt ich muss die Temp checken wenn das Spiel noch läuft und ich nicht draußen schon bin

Wie gesagt da hatte ich 74 Bilder. Mal sehen vielleicht kaufe ich mir dennoch mal einen neuen Rechner wenn der 5950x bei uns draußen ist und ja ich achte mal auch auf die CPU Auslastung im Manager. Wobei früher bei der alten Karte wenn ich ihn während des Spiels aufgerufen habe war die CPU alles andere als am Limit sondern was mit 60 % und die Grafikkarte war bei 96 %. Ach so und noch etwas. Die Meisten bei Alternate schreiben auch dass die Grafikkarte unter 65 Grad bleibt. Wie gesagt ich muss die Temp checken wenn das Spiel noch läuft und ich nicht draußen schon bin