meratheus

Software-Overclocker(in)

Das Update "GPUTool und Battlefield3" befindet sich am Ende des Guides!!!

Dieser Guide ist in Zusammenarbeit zwischen oxoViperoxo und Meratheus entstanden. Wir stehen bei Fragen gerne zur Verfügung und sind für jede konstruktive Kritik mit Vorschlägen/Lösungen offen.

Nachdem es immer wieder Interesse und Nachfragen bezüglich des GPUTools und dem Overclocking von GTX4xx/5xx Grafikkarten gab, möchten oxoViperoxo und ich meratheus euch gerne einen Guide zur Verfügung stellen mit dem wir bisher erfolgreich stabile Werte erreicht haben. Wir zeigen euch an einer EVGA GTX 570 Superclocked mit EKL Alpenföhn Peter und Thermalright G2 step by step wie ihr zu einer stabilen GPU Frequenz gelangt. Wer mehr Information über die VGA möchte kann sich unter folgender Signatur http://www.sysprofile.de/id149673 unter Mod & Misc darüber informieren.

Es sei an dieser Stelle deutlich darauf hingewiesen dass durch Übertakten die Hardware physikalisch zerstört werden kann. Dafür übernehmen oxoViperoxo und ich, Meratheus selbstverständlich keinerlei Haftung. Die Nutzung erfolgt ausschließlich auf eigene Gefahr!

Warum gerade das GPUTool?

Nun seit der GTX4xx Serie verwenden wir hauptsächlich den Stability Test von dem GPUTool. Es war bisher stets ein zuverlässiger RenderTest und ein 99,9%´iger Garant für stabilen Betrieb. Bisher konnten wir ebenso das Auslösen der Schutzschaltung zum Schutz vor Überlastung der VGA, im Vergleich zu GAU-Programmen wie Furmark nicht feststellen. Im Vergleich zu anderen Tool´s, wie z.B. OCCT konnten wir feststellen, daß das GPUTool minimal empfindlicher reagiert. Wir möchten an dieser Stelle noch einmal darauf hinweisen, daß Furmark für Stabilitätsteste absolut ungeeignet ist!

Was benötige ich zum Overclocken?

Zum Auslesen der Frequenzen und Spannungen kommt das Tool GPU-Z von www.techpowerup.com zum Einsatz. Download-Link:

GPU-Z Video card GPU Information Utility

Zum Einstellen der GPU-/Shader- und Speicherfrequenz, sowie der VGA-Spannung verwende ich den NvidiaInspector von www.orbmu2k.de. Download-Link:

OrbLog » Blog Archive » NVIDIA Inspector 1.95 – Tool

(Gleichgültig wie alt die Download Version unter diesem Link ist, im unteren Bereich des Fensters des NvidiaInspectors wird sofort angezeigt wenn eine aktuelle Version verfügbar ist. Vorraussetzung dafür ist eine Internetverbindung)

Hinweis: Der NvidiaInspector ist nicht zwingend dafür notwendig. Ebenso kann ein anderes Programm, z.B. MSI Afterburner verwendet werden. Da ich mit dem Afterburner nicht arbeite, stelle ich hier nur den Download-Link zur Verfügung:

MSI Afterburner

Zum Testen der GPU-Stabilität kommt wie in der Überschrift angekündigt das GPUTool, ebenso von www.techpowerup.com zum Einsatz. Download-Link:

Download GPUTool Community Technology Preview 1 | techPowerUp

GPU-Z

Dieses Tool verwende ich, um mich immer über aktuelle Frequenzen, Spannungen und Temperaturen zu informieren. Bei dem Übertakten der GPU Frequenz sind markierte Felder wichtig. Auf Bild1 habe ich Bus Interface für die Leute rot markiert, die gerne herausfinden möchten mit wieviel Lanes (elektrisch) ihre VGA angebunden ist. Auf Bild2 sind GPU Clock/Temperature/Load und VDDC markiert. Shader Clock habe ich nicht markiert, da dieser mit dem GPU Clock immer 1:2 verbunden ist. Ein Beispiel: Beträgt der GPU Clock 800MHz so ist der Shader Clock automatisch 1600MHz hoch.

Nvidia Inspector

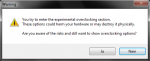

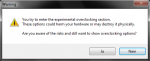

Nach dem Starten des NvidiaInspectors öffnet sich das Basic Fenster. Damit können wir aber noch nicht auf die Werte zugreifen. Erst nach Anklicken "Show Overclocking" und dem anschließenden Bestätigen der Warnung kommen wir in das erweiterte Fenster, mit dem wir arbeiten wollen.

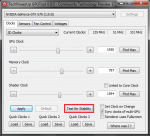

Mit dem Button "Apply Defaults" werden die im VGA BIOS vorgegebenen Werte (Standardwerte) wieder aktiviert.

Mit dem Button "Apply Clocks and Voltage" werden die von dem Anwender veränderten Frequenzen und Spannung übernommen/aktiviert.

Mit dem Button "Create Clocks Shortcut" wird ein Shortcut mit den veränderten Frequenzen und Spannung auf dem Desktop angelegt. Durch Anklicken dieses Shortcutes werden die darunter abgelegten Werte sofort aktiviert.

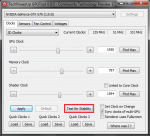

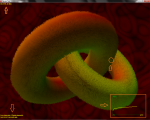

GPUTool

Nach dem Starten des GPUTools kommt die Kontrolloberfläche zum Vorschein. Die Einstellungen können so bleiben wie sie schon vorgegeben sind. Bei dem GPUTool ist folgender wichtiger Hinweis zu beachten: Nur den "Test for Stability" verwenden!!! Alles andere was an diesem Tool geboten wird funktioniert leider nicht zuverlässig, dafür aber der Stability Test!!! Achtet darauf das kein Häckchen unter "Renderer uses Fullscreen" gesetzt ist. Dadurch kann ich während des Testens unter Einzel-Monitorbetrieb immer wieder auf GPU-Z und NvidiaInspector wechseln, um Frequenzen oder Spannungen zu ändern oder zu kontrollieren. Während des RenderTests können folgende Informationen dargestellt werden:

Oben Links werden momentane und durchschnittliche Fps dargestellt.

Unten Links werden Pixelfehler und ein Counter angezeigt, der die Zeit des zuletzt aufgetretenen Fehlers zählt.

Unten rechts befindet sich das Temperaturdiagramm.

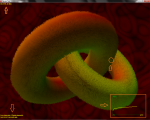

Auf Bild3 ist schön zu erkennen, wie extrem instabil die Settings sind. Es treten kontinuierlich Fehler auf. Hier lag eine GPU/Shader Frequenz von 900/1800 bei einer VDDC von 1.025V an.

Vorbereitung

Bevor wir mit dem Testen beginnen müssen wir noch die Einstellungen unter der Nvidia Systemsteuerung kontrollieren, ggf. einstellen. Nach dem Öffnen der Nvidia Systemsteuerung gehen wir auf "3D Einstellungen verwalten". Dort klicken wir auf das Fenster "Programmeinstellungen" und anschließend auf "Hinzufügen". Sucht nun die GPUTool.exe Datei und fügt diese hinzu. Nachdem die GPUTool.exe Datei zugefügt wurde sollte bis auf den Energieverwaltungsmodus alle Einstellungen auf "Globale Einstellungen" stehen. Der Energieverwaltungsmodus muß hier von "Adaptiv" auf "Maximale Leistung bevorzugen" geändert werden. Dadurch stellen wir sicher daß eine Senkung der VDDC während des Testens nicht möglich ist und unsere Ergebnisse nicht verfälscht. Danach unten rechts auf "Übernehemen" klicken um die Änderung wirksam werden zu lassen.

GPU Temperatur

Bis zu 90 Grad Celcius ist die GPU-Temperatur unbedenklich. Ab 100 Grad beginnt die VGA die GPU automatisch runterzutakten. Mit dem NvidiaInspector kann ich ebenso in die Lüftersteurung dahin gehend eingreifen, in dem ich manuell die Drehzahl der VGA-Lüfter vorgebe. Wer dies vorhaben sollte, muß gerade hier immer die Temperatur der GPU im Auge behalten. Das Häckchen unter "Auto" entfernen und die gewünsche Drehzahl über den Prozentschieber vorgeben. Anschließend unter "SetFan" übernehmen.

Hinweis: Je kühler die GPU ist desto höhere Frequenzwerte können erreicht werden, da die Leckströme abnehmen. Des weiteren begünstigt eine hohe Temperatur der GPU und Spannungsversorgung der Grafikkarte die Elektromigration, was die Lebenserwartung verkürzt. Unter folgenden Link kann jeder noch einmal die technischen Daten seiner VGA erfahren (z.B. maximale Temperatur der GPU) GeForce-Grafikprozessoren

Overclocking ohne Erhöhung der VDDC (Die ungefährliche Art des Übertaktens)

Da wir hier nur die maximale stabile GPU und Shader Frequenz bei der Standardspannung ausloten, braucht keiner Sorgen über eine Beschädigung der Grafikkarte haben. Auch der Temperaturanstieg der GPU ist bei Übertaktung ohne Spannungsanhebung gering. In wie weit sich die GPU übertakten läßt hängt nicht nur von der GPU Temperatur ab, ebenso von der Güte oder Qualität jeder einzelnen GPU.

Öffent nun GPU-Z "Sensors" und den NvidiaInspector im "erweiterten Kontrollfenster". Startet den "Test for Stability" von dem GPUTool und vergrößert den RenderTest durch anklicken des Buttons "Fenster maximieren". Da ich z.Zt. mit einem 4:3 LCD mit der max. Auflösung 1280x1024 arbeite solltet ihr euch nicht wundern. Wichtig ist, daß der RenderTest unter maximaler Fenstergröße läuft, jedoch nicht als FullScreen.

Laßt die VGA jetzt erst einmal warm werden, normalerweise sollten dafür ca. 10 Minuten reichen. Erst wenn sich die Temperaturkennlinie unter dem RenderTest stabilisiert hat beginnen wir mit dem Übertakten. Während des RenderTests schwankt die GPU Load unter dem GPU-Z zw. 90-99%. Kein Grund zur Sorge, ist vollkommen normal.

Mit dem NvidiaInspector ändere ich nun den Shader Clock erst einmal so weit nach oben, daß meine GTX 570 SC einen runden GPU-Clock von 800MHz erreicht. Also stelle ich den Shader Clock auf 1600MHz, denn ich habe ja vorher erklärt, daß der GPU Clock mit dem Shader Clock 1:2 verbunden ist. Nach dem ich den Shader Clock auf 1600MHz erhöht habe muß ich noch auf auf "Apply Clocks and Voltage" klicken, sonst werden die Werte nicht übernommen. Nach dem Bestätigen kann man erkennen, daß sich die Clocks von Shader und GPU jetzt auf den gewünschten Wert verstellt haben.

Nachdem ich den GPU/Shader Clock auf 800/1600MHz aufgerundet habe, beginne ich jetzt immer um 10MHz den GPU Clock zu erhöhen. Nach einer Anhebung um jeweils 10MHz GPU Clock warte ich 5-10 Minuten. Treten innerhalb der 5-10 Minuten keine Pixelfehler unter dem Stability Test unten links im Render Test auf, erhöhe wieder den GPU Clock um jeweils 10MHz. Dieses Verfahren wende ich so lange an, bis unter dem RenderTest im Fenster unten links Pixelfehler auftreten. Der erste Fehler trat bei einer GPU/Shader Frequenz von 860/1720MHz auf.

Nachdem wir herausgefunden haben bei welcher GPU Frequenz der Test nach maximal 10 Minuten instabil ist, gilt es jetzt herauszufinden, welche Frequenz unter mindestens 60 Minuten ohne Fehler den Stability Test durchläuft. Auch hier gilt, je länger der Stability Test von dem GPUTool läuft desto sicherer sind die ermittelten Frequenzen.

Anmerkung: Für die Overclocker die gerne auf den MHz genau ihr Maximum ausloten möchten reduzieren jetzt den GPU Clock immer um jeweils 1MHz. Für die Overclocker für die es schneller gehen soll, reduzieren jetzt den GPU Clock immer um jeweils 5MHz.

Jetzt muß der GPU Clock um jeweil 5MHz reduziert werden. Um den Fehler-Zeit Counter unter dem RenderTest zu löschen, muß einmal das Bild vom RenderTest minimiert und anschließend wieder maximiert werden.

Hinweis: Der Fehler-Zeit Counter verschwindet automatisch nach ca. 30-40 Minuten, wenn innerhalb dieser Zeit kein neuer Fehler auftrat.

Anschließend die Zeit notieren und den Stability Test einfach laufen lassen. Tritt/Treten innerhalb der nächsten 60 Minuten ein oder mehrere Fehler auf, muß der GPU Clock wieder um 5MHz reduziert, der Fehler-Zeit Counter gelöscht und die Zeit neu notiert werden. Diese Procedure solange wiederholen bis kein Pixelfehler mehr innnerhalb von mindestens 60 Minuten unter dem RenderTest angezeigt wird. Bei meiner VGA ist dies der Fall bei 830/1660 MHz GPU/Shader Clock. Natürlich habe ich meine VGA auch im 1MHz Schritt getestet und erreichte stabile 833/1666 MHz GPU/Shader Clock. Nicht selten trat nach ca. 40 Minuten stabilen Test ein Pixelfehler auf. Auch hier habe ich dann den GPU Clock um 1MHz reduziert, Fehler-Zeit Counter gelöscht und die Zeit neu notiert. Je näher man dem stabilen Clock sich nähert, desto länger kann es dauern, bis ein Pixelfehler erscheint.

Frequenz-Sicherheitspuffer

Nachdem ich nun meine stabile GPU Frequenz mit dem Stability Test von dem GPUTool ausgelotet habe, reduziere ich nochmals den GPU Clock um mindestens 10MHz als Sicherheitspuffer. Bisher sind es bei mir 13MHz, da ein runder GPU Frequenzwert besser aussieht (833-13=820MHz @1.025V/913-13=900MHz @1.100V). Dieser Puffer reichte bisher aus und berücksichtigte auch den Temperaturanstieg der GPU in der Sommerzeit, sowie sogenannte Clock Holes. Das Temperaturverhalten ist natürlich immer abhängig von dem Gehäuse und seiner Belüftung, sowie von der Raumtemperatur.

VDDC-Sicherheitspuffer

Wie bei der Frequenz kann ebenso ein Sicherheitspuffer für die VDDC eingerichtet werden. Nachdem ich meine stabile GPU Frequenz mit dem Stability Test von dem GPUTool ausgelotet habe, erhöhe ich die VDDC um einen Schritt. Beispiel: Habe ich die GPU-Frequenz bei 1.050V fehlerfrei ermittelt, erhöhe ich die VDDC auf 1.063V.

Abschließende Tests

Natürlich müssen diese ermittelten Frequenzen auch mit Benchmarks, vor allem mit Spielen auf Stabilität geprüft werden. Besonders Performance hungrige Spiele wie z.B. Metro2033, Crysis Warhead, Crysis2 DX11 und besonders Battlefield 3 eignen sich gut dafür. Benchmarks wie z.B. die 3DMark Palette oder Unigine Heaven2.5 sind gut geeignet, jedoch weniger ein zuverlässiger Garant als stundenlang Spiele zu bestreiten. Der sicherste Garant war, ist und bleibt ein stabiler sicherer 24/7 Betrieb ohne Vorkommnisse. Bisher kann ich aber mit dieser Procedure nur von positiven Erfahrungen berichten.

Nachtrag: Nach den ersten Berichten in diesem sowie anderen Foren und nach stundenlangem Belesen stellt Battlefield 3 einen neu Maßstab in der Stabilitätsanalyse. Wer in Besitz dieses Games ist sollte dies unbedingt für den abschließenden Test verwenden. Besonders der Multiplayer-Modus wird hier empfohlen.

Overclocking mit Erhöhung der VDDC

Nach dieser Procedure kann man natürlich ebenso mit Spannungserhöhung testen. Das Ergebnis in Stabilität blieb bisher das selbe. Jedoch sollte sich jeder vorher über folgendes im klaren sein:

Es sollten immer die Temperaturen der Spannungsversorgung (MOFSET) an der eigenen VGA ermittelt werden. Sich auf die Werte anderer User die die selbe VGA besitzen zu verlassen ist schlicht weg gefährlich. Diese fallen immer unterschiedlich aus, abhängig von dem Gehäuse und der verwendeten Belüftung bzw. Kühlung, sowie von der bestehenden Umgebungstemperatur. Da leider keine Temperatursensoren bei den GTX4xx/GTX5xx Modellen in den Spannungsversorgung verbaut sind, muß mit Hilfe verschiedener Meßgeräte die Temperatur ermittelt werden. Die Temperatur der Spannungsversorgung kann man z.B. an der PCB-Rückseite grob ermitteln. Die reale Temperatur der Spannungswandler ist ca.10 Grad Celcius höher im Vergleich zu der gemessen Temperatur an der PCB-Rückseite. Hier gilt es wie eh und je mit gesunden Menschenverstand 24/7 Settings zu verwenden. Wer mit VDDC-Erhöhung übertaktet sollte sich ebenso darüber bewußt sein, daß es zu Beschädigung oder Zertörung der VGA und ihrer Bauteile kommen kann. Der Anspruch auf Garantie/Gewährleistung geht verloren. Durch die Spannungserhöhung und höhere Temperaturbelastung wird die Elektromigration begünstigt, was demzufolge die Lebenserwartung der VGA natürlich verkürzt. Ebenso solltet ihr stets beachten, daß es 3 Bauteile auf dem PCB gibt dessen Temperaturen zu überwachen sind. GPU-Temperatur die ausgelesen werden kann, die VRAM- und Spannungsversorgungs-Temperatur die leider nicht ausgelesen und nur mit entsprechenden Meßhilsfmittel ermittelt werden kann.

oxoViperoxo und ich werden keine Empfehlungen bezüglich der VDDC zu den einzelnen VGA´s aussprechen/geben.

Overclocking des Speichers

Zum Ermitteln der maximalen stabilen Speicherfrequenz ist aus eigener Erfahrung das GPUTool ungeeignet. Hierfür sollten Benchmarks und Spiele verwendet werden. Besonders das Metro2033 ist bei mir ein sehr guter Indicator für instabilen Speicher, da es sehr Speicherlastig ist. Wer es mit der Speicherfrequenz zu sehr übertrieben hat, wird mit einen Abschalten des VGA-Treibers oder gar einem BlueScreen bestraft. Fehler die noch schwerwiegend sind, jedoch keinen Absturz von Treiber oder System verursachen treten in Form von Artefakten auf. Pixelfehler, so wie wir sie bei dem Stability Test vom GPUTool nun kennen, sind bei 3D Applikationen mit bewegenden/dynam. Bildern schon sehr schwer auszumachen. Bei dem Speicher sollte man die Temperatur von ca.60 Grad Celcius einhalten. Ebenso kann diese mit einem IF-Thermometer gemessen werden.

Verhältnis Zwischen Speicher-und GPU-Clock

Um ein gutes Verhältnis zwischen Speicher- und GPU-Clock zu erreichen müssen an Hand von 3D Applikationen (Beispiel Spiele) die Min-FPS ermittelt werden. Dafür benötigt man ein Tool welches die Bilder pro Sekunde ermittelt, wie zum Beispiel Fraps. Hier der Link: www.fraps.com

Hier einfach unterchiedliche Frequenzkombinationen von GPU und Speicher testen und die FPS auswerten.

Wir wünschen euch nun viel Erfolg und Spaß beim Overclocking!!!

14.12.2011 Update: GPUTool und Battlefield3

Nachdem in einigen Foren Berichte auftauchten, daß das Spiel Battlefield3 neue Maßstäbe in Form der Stabilität für übertaktete GPU´s darstelle testete ich jetzt erst einmal in 3 kompletten Durchläufen die Kampange.

Diesmal entschied ich mich für eine GPU/Shader Frequenz von 850/1700MHz und getestet wurde mit der Nvidia Treiber Version 285.62 WHQL. Die Grafikkartenspeicherfrequenz bleib auch hier in der Werkeinstellung von 1950MHz, da ich nur die GPU übertakten und auf Stabilität testen möchte. Über den NvidiaInspector stellte ich die 850/1700MHz ein und beließ die VDDC erst einmal bei der Werkseinstellung 1.025V. Nach dem Start des Stabilitytest von dem GPUTool mußte ich die Spannung bis auf 1.050V anheben, um 140 Minuten Rendertest bei einer GPU-Temperatur von 59 Grad Celcius ohne einen einzigen Pixelfehler zu bestehen. Um zu sehen wie effektiv/zuverläßig das GPUTool wirklich analysiert, habe ich die Werte 850/1700MHz GPU/Shader Clock ohne einen Frequenz- oder VDDC-Sicherheitspuffer für das Spiel Battlefield3 verwendet. Die grafischen Einstellungen unter dem Spiele-Menü wurden auf das maximal Mögliche eingestellt, Vsync deaktiviert. Unter der Nvidia Systemsteuerung wurden die globalen Einstellungen beibehalten, bis auf folgende Optionen: "Energieverwaltungsmodus = Max. Leistung bevorzugen, Texturfilterung - Negativer LOD-Bias = Clamp und Texturfilterung - Qualität = Hohe Qualität".

Ich spielte die Kampange dreimal durch. Die erste Runde mit dem Schwierigkeitsgard "einfach" und die darauf folgenden zwei Runden in "normal". Um Information über die Bildrate zubekommen, aktivierte ich das Tool Fraps mit.

Ergebnis Battlefield3 Kampange

Alle drei Durchläufe liefen bei mir stabil durch. Grafikfehler oder gar ein Abschalten des Spieles oder des Grafiktreibers konnte ich nicht feststellen. Die FPS blieben hauptsächlich zwischen 40-60 FPS unter einer Auflösung von 1920x1080. Selten viel die Bildrate auch unter die 40 FPS, jedoch wurde nie die 30 FPS Rate erreicht. Demnächst werde ich mit den selben Settings der VGA natürlich den Multiplayer testen und berichten.

Battlefield3 Multiplayer (20.12.2011)

Nach ca. 2 Stunden Multiplayer kam es zum Spielabsturz und die VGA resetet in ihre Werkseinstellung automatisch zurück. Hier wollten die 850/1700MHz GPU/Shader-Clock bei 1.050V nicht stabil werkeln. Nun denn eine Spannungsstufe weiter rauf (von 1.050V auf 1.063V), was dem emfpohlenen VDDC-Sicherheitspuffer entspricht und das ca. 12-stündige Battlefield3-Wochenende lief stabil mit meiner VGA. Gespielt wurde 64iger Server (voll) und alle Maps.

Allgemeine Empfehlung für Battlefield3

Wer seine gewünschte GPU/Shader-Frequenz nach mindestens 60 Minuten GPUTool "Test of Stability" fehlerfrei bestanden hat, kann auf den Frequenz-Sicherheitspuffer verzichten sollte aber einen VDDC-Sicherheitspuffer von 1 bis 2 Spannungstufen einplanen (Beispiel 2 Stufen: von 1.050V auf 1.075V). Sicherlich sollte man hier erst einmal mit einer Spannungsstufe beginnen (Beispiel von 1.050V auf 1.063V) und ausgiebig testen. Möglicherweise kann/muß je nach Kühlleistung der VGA und dem gesamten System eine Anhebung von einer weiteren Stufe notwendig sein.

Bleibt nur noch abzuwarten ob sich Battlefield3 mit neuen Treibern weiter so empfindlich verhält. Wer Erfahrungen mit den BETA-Treibern 290.36/290.53 hat kann diese gerne hier weitergeben.

Dieser Guide ist in Zusammenarbeit zwischen oxoViperoxo und Meratheus entstanden. Wir stehen bei Fragen gerne zur Verfügung und sind für jede konstruktive Kritik mit Vorschlägen/Lösungen offen.

Dieser Guide ist in Zusammenarbeit zwischen oxoViperoxo und Meratheus entstanden. Wir stehen bei Fragen gerne zur Verfügung und sind für jede konstruktive Kritik mit Vorschlägen/Lösungen offen.

Nachdem es immer wieder Interesse und Nachfragen bezüglich des GPUTools und dem Overclocking von GTX4xx/5xx Grafikkarten gab, möchten oxoViperoxo und ich meratheus euch gerne einen Guide zur Verfügung stellen mit dem wir bisher erfolgreich stabile Werte erreicht haben. Wir zeigen euch an einer EVGA GTX 570 Superclocked mit EKL Alpenföhn Peter und Thermalright G2 step by step wie ihr zu einer stabilen GPU Frequenz gelangt. Wer mehr Information über die VGA möchte kann sich unter folgender Signatur http://www.sysprofile.de/id149673 unter Mod & Misc darüber informieren.

Es sei an dieser Stelle deutlich darauf hingewiesen dass durch Übertakten die Hardware physikalisch zerstört werden kann. Dafür übernehmen oxoViperoxo und ich, Meratheus selbstverständlich keinerlei Haftung. Die Nutzung erfolgt ausschließlich auf eigene Gefahr!

Warum gerade das GPUTool?

Nun seit der GTX4xx Serie verwenden wir hauptsächlich den Stability Test von dem GPUTool. Es war bisher stets ein zuverlässiger RenderTest und ein 99,9%´iger Garant für stabilen Betrieb. Bisher konnten wir ebenso das Auslösen der Schutzschaltung zum Schutz vor Überlastung der VGA, im Vergleich zu GAU-Programmen wie Furmark nicht feststellen. Im Vergleich zu anderen Tool´s, wie z.B. OCCT konnten wir feststellen, daß das GPUTool minimal empfindlicher reagiert. Wir möchten an dieser Stelle noch einmal darauf hinweisen, daß Furmark für Stabilitätsteste absolut ungeeignet ist!

Was benötige ich zum Overclocken?

Zum Auslesen der Frequenzen und Spannungen kommt das Tool GPU-Z von www.techpowerup.com zum Einsatz. Download-Link:

GPU-Z Video card GPU Information Utility

Zum Einstellen der GPU-/Shader- und Speicherfrequenz, sowie der VGA-Spannung verwende ich den NvidiaInspector von www.orbmu2k.de. Download-Link:

OrbLog » Blog Archive » NVIDIA Inspector 1.95 – Tool

(Gleichgültig wie alt die Download Version unter diesem Link ist, im unteren Bereich des Fensters des NvidiaInspectors wird sofort angezeigt wenn eine aktuelle Version verfügbar ist. Vorraussetzung dafür ist eine Internetverbindung)

Hinweis: Der NvidiaInspector ist nicht zwingend dafür notwendig. Ebenso kann ein anderes Programm, z.B. MSI Afterburner verwendet werden. Da ich mit dem Afterburner nicht arbeite, stelle ich hier nur den Download-Link zur Verfügung:

MSI Afterburner

Zum Testen der GPU-Stabilität kommt wie in der Überschrift angekündigt das GPUTool, ebenso von www.techpowerup.com zum Einsatz. Download-Link:

Download GPUTool Community Technology Preview 1 | techPowerUp

GPU-Z

Dieses Tool verwende ich, um mich immer über aktuelle Frequenzen, Spannungen und Temperaturen zu informieren. Bei dem Übertakten der GPU Frequenz sind markierte Felder wichtig. Auf Bild1 habe ich Bus Interface für die Leute rot markiert, die gerne herausfinden möchten mit wieviel Lanes (elektrisch) ihre VGA angebunden ist. Auf Bild2 sind GPU Clock/Temperature/Load und VDDC markiert. Shader Clock habe ich nicht markiert, da dieser mit dem GPU Clock immer 1:2 verbunden ist. Ein Beispiel: Beträgt der GPU Clock 800MHz so ist der Shader Clock automatisch 1600MHz hoch.

Nvidia Inspector

Nach dem Starten des NvidiaInspectors öffnet sich das Basic Fenster. Damit können wir aber noch nicht auf die Werte zugreifen. Erst nach Anklicken "Show Overclocking" und dem anschließenden Bestätigen der Warnung kommen wir in das erweiterte Fenster, mit dem wir arbeiten wollen.

Mit dem Button "Apply Defaults" werden die im VGA BIOS vorgegebenen Werte (Standardwerte) wieder aktiviert.

Mit dem Button "Apply Clocks and Voltage" werden die von dem Anwender veränderten Frequenzen und Spannung übernommen/aktiviert.

Mit dem Button "Create Clocks Shortcut" wird ein Shortcut mit den veränderten Frequenzen und Spannung auf dem Desktop angelegt. Durch Anklicken dieses Shortcutes werden die darunter abgelegten Werte sofort aktiviert.

GPUTool

Nach dem Starten des GPUTools kommt die Kontrolloberfläche zum Vorschein. Die Einstellungen können so bleiben wie sie schon vorgegeben sind. Bei dem GPUTool ist folgender wichtiger Hinweis zu beachten: Nur den "Test for Stability" verwenden!!! Alles andere was an diesem Tool geboten wird funktioniert leider nicht zuverlässig, dafür aber der Stability Test!!! Achtet darauf das kein Häckchen unter "Renderer uses Fullscreen" gesetzt ist. Dadurch kann ich während des Testens unter Einzel-Monitorbetrieb immer wieder auf GPU-Z und NvidiaInspector wechseln, um Frequenzen oder Spannungen zu ändern oder zu kontrollieren. Während des RenderTests können folgende Informationen dargestellt werden:

Oben Links werden momentane und durchschnittliche Fps dargestellt.

Unten Links werden Pixelfehler und ein Counter angezeigt, der die Zeit des zuletzt aufgetretenen Fehlers zählt.

Unten rechts befindet sich das Temperaturdiagramm.

Auf Bild3 ist schön zu erkennen, wie extrem instabil die Settings sind. Es treten kontinuierlich Fehler auf. Hier lag eine GPU/Shader Frequenz von 900/1800 bei einer VDDC von 1.025V an.

Vorbereitung

Bevor wir mit dem Testen beginnen müssen wir noch die Einstellungen unter der Nvidia Systemsteuerung kontrollieren, ggf. einstellen. Nach dem Öffnen der Nvidia Systemsteuerung gehen wir auf "3D Einstellungen verwalten". Dort klicken wir auf das Fenster "Programmeinstellungen" und anschließend auf "Hinzufügen". Sucht nun die GPUTool.exe Datei und fügt diese hinzu. Nachdem die GPUTool.exe Datei zugefügt wurde sollte bis auf den Energieverwaltungsmodus alle Einstellungen auf "Globale Einstellungen" stehen. Der Energieverwaltungsmodus muß hier von "Adaptiv" auf "Maximale Leistung bevorzugen" geändert werden. Dadurch stellen wir sicher daß eine Senkung der VDDC während des Testens nicht möglich ist und unsere Ergebnisse nicht verfälscht. Danach unten rechts auf "Übernehemen" klicken um die Änderung wirksam werden zu lassen.

GPU Temperatur

Bis zu 90 Grad Celcius ist die GPU-Temperatur unbedenklich. Ab 100 Grad beginnt die VGA die GPU automatisch runterzutakten. Mit dem NvidiaInspector kann ich ebenso in die Lüftersteurung dahin gehend eingreifen, in dem ich manuell die Drehzahl der VGA-Lüfter vorgebe. Wer dies vorhaben sollte, muß gerade hier immer die Temperatur der GPU im Auge behalten. Das Häckchen unter "Auto" entfernen und die gewünsche Drehzahl über den Prozentschieber vorgeben. Anschließend unter "SetFan" übernehmen.

Hinweis: Je kühler die GPU ist desto höhere Frequenzwerte können erreicht werden, da die Leckströme abnehmen. Des weiteren begünstigt eine hohe Temperatur der GPU und Spannungsversorgung der Grafikkarte die Elektromigration, was die Lebenserwartung verkürzt. Unter folgenden Link kann jeder noch einmal die technischen Daten seiner VGA erfahren (z.B. maximale Temperatur der GPU) GeForce-Grafikprozessoren

Overclocking ohne Erhöhung der VDDC (Die ungefährliche Art des Übertaktens)

Da wir hier nur die maximale stabile GPU und Shader Frequenz bei der Standardspannung ausloten, braucht keiner Sorgen über eine Beschädigung der Grafikkarte haben. Auch der Temperaturanstieg der GPU ist bei Übertaktung ohne Spannungsanhebung gering. In wie weit sich die GPU übertakten läßt hängt nicht nur von der GPU Temperatur ab, ebenso von der Güte oder Qualität jeder einzelnen GPU.

Öffent nun GPU-Z "Sensors" und den NvidiaInspector im "erweiterten Kontrollfenster". Startet den "Test for Stability" von dem GPUTool und vergrößert den RenderTest durch anklicken des Buttons "Fenster maximieren". Da ich z.Zt. mit einem 4:3 LCD mit der max. Auflösung 1280x1024 arbeite solltet ihr euch nicht wundern. Wichtig ist, daß der RenderTest unter maximaler Fenstergröße läuft, jedoch nicht als FullScreen.

Laßt die VGA jetzt erst einmal warm werden, normalerweise sollten dafür ca. 10 Minuten reichen. Erst wenn sich die Temperaturkennlinie unter dem RenderTest stabilisiert hat beginnen wir mit dem Übertakten. Während des RenderTests schwankt die GPU Load unter dem GPU-Z zw. 90-99%. Kein Grund zur Sorge, ist vollkommen normal.

Mit dem NvidiaInspector ändere ich nun den Shader Clock erst einmal so weit nach oben, daß meine GTX 570 SC einen runden GPU-Clock von 800MHz erreicht. Also stelle ich den Shader Clock auf 1600MHz, denn ich habe ja vorher erklärt, daß der GPU Clock mit dem Shader Clock 1:2 verbunden ist. Nach dem ich den Shader Clock auf 1600MHz erhöht habe muß ich noch auf auf "Apply Clocks and Voltage" klicken, sonst werden die Werte nicht übernommen. Nach dem Bestätigen kann man erkennen, daß sich die Clocks von Shader und GPU jetzt auf den gewünschten Wert verstellt haben.

Nachdem ich den GPU/Shader Clock auf 800/1600MHz aufgerundet habe, beginne ich jetzt immer um 10MHz den GPU Clock zu erhöhen. Nach einer Anhebung um jeweils 10MHz GPU Clock warte ich 5-10 Minuten. Treten innerhalb der 5-10 Minuten keine Pixelfehler unter dem Stability Test unten links im Render Test auf, erhöhe wieder den GPU Clock um jeweils 10MHz. Dieses Verfahren wende ich so lange an, bis unter dem RenderTest im Fenster unten links Pixelfehler auftreten. Der erste Fehler trat bei einer GPU/Shader Frequenz von 860/1720MHz auf.

Nachdem wir herausgefunden haben bei welcher GPU Frequenz der Test nach maximal 10 Minuten instabil ist, gilt es jetzt herauszufinden, welche Frequenz unter mindestens 60 Minuten ohne Fehler den Stability Test durchläuft. Auch hier gilt, je länger der Stability Test von dem GPUTool läuft desto sicherer sind die ermittelten Frequenzen.

Anmerkung: Für die Overclocker die gerne auf den MHz genau ihr Maximum ausloten möchten reduzieren jetzt den GPU Clock immer um jeweils 1MHz. Für die Overclocker für die es schneller gehen soll, reduzieren jetzt den GPU Clock immer um jeweils 5MHz.

Jetzt muß der GPU Clock um jeweil 5MHz reduziert werden. Um den Fehler-Zeit Counter unter dem RenderTest zu löschen, muß einmal das Bild vom RenderTest minimiert und anschließend wieder maximiert werden.

Hinweis: Der Fehler-Zeit Counter verschwindet automatisch nach ca. 30-40 Minuten, wenn innerhalb dieser Zeit kein neuer Fehler auftrat.

Anschließend die Zeit notieren und den Stability Test einfach laufen lassen. Tritt/Treten innerhalb der nächsten 60 Minuten ein oder mehrere Fehler auf, muß der GPU Clock wieder um 5MHz reduziert, der Fehler-Zeit Counter gelöscht und die Zeit neu notiert werden. Diese Procedure solange wiederholen bis kein Pixelfehler mehr innnerhalb von mindestens 60 Minuten unter dem RenderTest angezeigt wird. Bei meiner VGA ist dies der Fall bei 830/1660 MHz GPU/Shader Clock. Natürlich habe ich meine VGA auch im 1MHz Schritt getestet und erreichte stabile 833/1666 MHz GPU/Shader Clock. Nicht selten trat nach ca. 40 Minuten stabilen Test ein Pixelfehler auf. Auch hier habe ich dann den GPU Clock um 1MHz reduziert, Fehler-Zeit Counter gelöscht und die Zeit neu notiert. Je näher man dem stabilen Clock sich nähert, desto länger kann es dauern, bis ein Pixelfehler erscheint.

Frequenz-Sicherheitspuffer

Nachdem ich nun meine stabile GPU Frequenz mit dem Stability Test von dem GPUTool ausgelotet habe, reduziere ich nochmals den GPU Clock um mindestens 10MHz als Sicherheitspuffer. Bisher sind es bei mir 13MHz, da ein runder GPU Frequenzwert besser aussieht (833-13=820MHz @1.025V/913-13=900MHz @1.100V). Dieser Puffer reichte bisher aus und berücksichtigte auch den Temperaturanstieg der GPU in der Sommerzeit, sowie sogenannte Clock Holes. Das Temperaturverhalten ist natürlich immer abhängig von dem Gehäuse und seiner Belüftung, sowie von der Raumtemperatur.

VDDC-Sicherheitspuffer

Wie bei der Frequenz kann ebenso ein Sicherheitspuffer für die VDDC eingerichtet werden. Nachdem ich meine stabile GPU Frequenz mit dem Stability Test von dem GPUTool ausgelotet habe, erhöhe ich die VDDC um einen Schritt. Beispiel: Habe ich die GPU-Frequenz bei 1.050V fehlerfrei ermittelt, erhöhe ich die VDDC auf 1.063V.

Abschließende Tests

Natürlich müssen diese ermittelten Frequenzen auch mit Benchmarks, vor allem mit Spielen auf Stabilität geprüft werden. Besonders Performance hungrige Spiele wie z.B. Metro2033, Crysis Warhead, Crysis2 DX11 und besonders Battlefield 3 eignen sich gut dafür. Benchmarks wie z.B. die 3DMark Palette oder Unigine Heaven2.5 sind gut geeignet, jedoch weniger ein zuverlässiger Garant als stundenlang Spiele zu bestreiten. Der sicherste Garant war, ist und bleibt ein stabiler sicherer 24/7 Betrieb ohne Vorkommnisse. Bisher kann ich aber mit dieser Procedure nur von positiven Erfahrungen berichten.

Nachtrag: Nach den ersten Berichten in diesem sowie anderen Foren und nach stundenlangem Belesen stellt Battlefield 3 einen neu Maßstab in der Stabilitätsanalyse. Wer in Besitz dieses Games ist sollte dies unbedingt für den abschließenden Test verwenden. Besonders der Multiplayer-Modus wird hier empfohlen.

Overclocking mit Erhöhung der VDDC

Nach dieser Procedure kann man natürlich ebenso mit Spannungserhöhung testen. Das Ergebnis in Stabilität blieb bisher das selbe. Jedoch sollte sich jeder vorher über folgendes im klaren sein:

Es sollten immer die Temperaturen der Spannungsversorgung (MOFSET) an der eigenen VGA ermittelt werden. Sich auf die Werte anderer User die die selbe VGA besitzen zu verlassen ist schlicht weg gefährlich. Diese fallen immer unterschiedlich aus, abhängig von dem Gehäuse und der verwendeten Belüftung bzw. Kühlung, sowie von der bestehenden Umgebungstemperatur. Da leider keine Temperatursensoren bei den GTX4xx/GTX5xx Modellen in den Spannungsversorgung verbaut sind, muß mit Hilfe verschiedener Meßgeräte die Temperatur ermittelt werden. Die Temperatur der Spannungsversorgung kann man z.B. an der PCB-Rückseite grob ermitteln. Die reale Temperatur der Spannungswandler ist ca.10 Grad Celcius höher im Vergleich zu der gemessen Temperatur an der PCB-Rückseite. Hier gilt es wie eh und je mit gesunden Menschenverstand 24/7 Settings zu verwenden. Wer mit VDDC-Erhöhung übertaktet sollte sich ebenso darüber bewußt sein, daß es zu Beschädigung oder Zertörung der VGA und ihrer Bauteile kommen kann. Der Anspruch auf Garantie/Gewährleistung geht verloren. Durch die Spannungserhöhung und höhere Temperaturbelastung wird die Elektromigration begünstigt, was demzufolge die Lebenserwartung der VGA natürlich verkürzt. Ebenso solltet ihr stets beachten, daß es 3 Bauteile auf dem PCB gibt dessen Temperaturen zu überwachen sind. GPU-Temperatur die ausgelesen werden kann, die VRAM- und Spannungsversorgungs-Temperatur die leider nicht ausgelesen und nur mit entsprechenden Meßhilsfmittel ermittelt werden kann.

oxoViperoxo und ich werden keine Empfehlungen bezüglich der VDDC zu den einzelnen VGA´s aussprechen/geben.

Overclocking des Speichers

Zum Ermitteln der maximalen stabilen Speicherfrequenz ist aus eigener Erfahrung das GPUTool ungeeignet. Hierfür sollten Benchmarks und Spiele verwendet werden. Besonders das Metro2033 ist bei mir ein sehr guter Indicator für instabilen Speicher, da es sehr Speicherlastig ist. Wer es mit der Speicherfrequenz zu sehr übertrieben hat, wird mit einen Abschalten des VGA-Treibers oder gar einem BlueScreen bestraft. Fehler die noch schwerwiegend sind, jedoch keinen Absturz von Treiber oder System verursachen treten in Form von Artefakten auf. Pixelfehler, so wie wir sie bei dem Stability Test vom GPUTool nun kennen, sind bei 3D Applikationen mit bewegenden/dynam. Bildern schon sehr schwer auszumachen. Bei dem Speicher sollte man die Temperatur von ca.60 Grad Celcius einhalten. Ebenso kann diese mit einem IF-Thermometer gemessen werden.

Verhältnis Zwischen Speicher-und GPU-Clock

Um ein gutes Verhältnis zwischen Speicher- und GPU-Clock zu erreichen müssen an Hand von 3D Applikationen (Beispiel Spiele) die Min-FPS ermittelt werden. Dafür benötigt man ein Tool welches die Bilder pro Sekunde ermittelt, wie zum Beispiel Fraps. Hier der Link: www.fraps.com

Hier einfach unterchiedliche Frequenzkombinationen von GPU und Speicher testen und die FPS auswerten.

Wir wünschen euch nun viel Erfolg und Spaß beim Overclocking!!!

14.12.2011 Update: GPUTool und Battlefield3

Nachdem in einigen Foren Berichte auftauchten, daß das Spiel Battlefield3 neue Maßstäbe in Form der Stabilität für übertaktete GPU´s darstelle testete ich jetzt erst einmal in 3 kompletten Durchläufen die Kampange.

Diesmal entschied ich mich für eine GPU/Shader Frequenz von 850/1700MHz und getestet wurde mit der Nvidia Treiber Version 285.62 WHQL. Die Grafikkartenspeicherfrequenz bleib auch hier in der Werkeinstellung von 1950MHz, da ich nur die GPU übertakten und auf Stabilität testen möchte. Über den NvidiaInspector stellte ich die 850/1700MHz ein und beließ die VDDC erst einmal bei der Werkseinstellung 1.025V. Nach dem Start des Stabilitytest von dem GPUTool mußte ich die Spannung bis auf 1.050V anheben, um 140 Minuten Rendertest bei einer GPU-Temperatur von 59 Grad Celcius ohne einen einzigen Pixelfehler zu bestehen. Um zu sehen wie effektiv/zuverläßig das GPUTool wirklich analysiert, habe ich die Werte 850/1700MHz GPU/Shader Clock ohne einen Frequenz- oder VDDC-Sicherheitspuffer für das Spiel Battlefield3 verwendet. Die grafischen Einstellungen unter dem Spiele-Menü wurden auf das maximal Mögliche eingestellt, Vsync deaktiviert. Unter der Nvidia Systemsteuerung wurden die globalen Einstellungen beibehalten, bis auf folgende Optionen: "Energieverwaltungsmodus = Max. Leistung bevorzugen, Texturfilterung - Negativer LOD-Bias = Clamp und Texturfilterung - Qualität = Hohe Qualität".

Ich spielte die Kampange dreimal durch. Die erste Runde mit dem Schwierigkeitsgard "einfach" und die darauf folgenden zwei Runden in "normal". Um Information über die Bildrate zubekommen, aktivierte ich das Tool Fraps mit.

Ergebnis Battlefield3 Kampange

Alle drei Durchläufe liefen bei mir stabil durch. Grafikfehler oder gar ein Abschalten des Spieles oder des Grafiktreibers konnte ich nicht feststellen. Die FPS blieben hauptsächlich zwischen 40-60 FPS unter einer Auflösung von 1920x1080. Selten viel die Bildrate auch unter die 40 FPS, jedoch wurde nie die 30 FPS Rate erreicht. Demnächst werde ich mit den selben Settings der VGA natürlich den Multiplayer testen und berichten.

Battlefield3 Multiplayer (20.12.2011)

Nach ca. 2 Stunden Multiplayer kam es zum Spielabsturz und die VGA resetet in ihre Werkseinstellung automatisch zurück. Hier wollten die 850/1700MHz GPU/Shader-Clock bei 1.050V nicht stabil werkeln. Nun denn eine Spannungsstufe weiter rauf (von 1.050V auf 1.063V), was dem emfpohlenen VDDC-Sicherheitspuffer entspricht und das ca. 12-stündige Battlefield3-Wochenende lief stabil mit meiner VGA. Gespielt wurde 64iger Server (voll) und alle Maps.

Allgemeine Empfehlung für Battlefield3

Wer seine gewünschte GPU/Shader-Frequenz nach mindestens 60 Minuten GPUTool "Test of Stability" fehlerfrei bestanden hat, kann auf den Frequenz-Sicherheitspuffer verzichten sollte aber einen VDDC-Sicherheitspuffer von 1 bis 2 Spannungstufen einplanen (Beispiel 2 Stufen: von 1.050V auf 1.075V). Sicherlich sollte man hier erst einmal mit einer Spannungsstufe beginnen (Beispiel von 1.050V auf 1.063V) und ausgiebig testen. Möglicherweise kann/muß je nach Kühlleistung der VGA und dem gesamten System eine Anhebung von einer weiteren Stufe notwendig sein.

Bleibt nur noch abzuwarten ob sich Battlefield3 mit neuen Treibern weiter so empfindlich verhält. Wer Erfahrungen mit den BETA-Treibern 290.36/290.53 hat kann diese gerne hier weitergeben.

Dieser Guide ist in Zusammenarbeit zwischen oxoViperoxo und Meratheus entstanden. Wir stehen bei Fragen gerne zur Verfügung und sind für jede konstruktive Kritik mit Vorschlägen/Lösungen offen.

Zuletzt bearbeitet:

.gif)

was nun besser

was nun besser  erzählt mir doch kein quatsch....man man...klar zb furmark finde ich auch blödsinn..weil das der letzte schrott...ich habe ja auch nie was gegen das gputool gesagt....sind beide gut...ich benutze immer beide !!aber bevor man flasht sollte man noch erst viele verschiedene spiele zocken...erst dann ist man auf der richtigen seite.

erzählt mir doch kein quatsch....man man...klar zb furmark finde ich auch blödsinn..weil das der letzte schrott...ich habe ja auch nie was gegen das gputool gesagt....sind beide gut...ich benutze immer beide !!aber bevor man flasht sollte man noch erst viele verschiedene spiele zocken...erst dann ist man auf der richtigen seite.