Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Grafikspeicher 2024: Wie gut sind PCGH-Leser auf die Unreal Engine 5 vorbereitet?

- Ersteller PCGH-Redaktion

- Erstellt am

Rhadon

Komplett-PC-Aufrüster(in)

Dann hast du hoffentlich draus gelernt und gibst Nvidia das nächste Mal ein paar Hunderter mehr oder kaufst eine Radeon die mit Vram protzen. Nein Spaß beiseite, solange du nicht in UHD zockst wirst du vermutlich lange Spaß haben.Ich bin ein 12GiB-Pleb und leide ganz fürchterlich unter meiner hundsmiserablen Existenz

Das heißt aber nicht, dass wir diesen Vram Geiz gutheißen sollten gerade bei diesen absurden Gpu preisen.

derneuemann

Lötkolbengott/-göttin

Dann hast du hoffentlich draus gelernt und gibst Nvidia das nächste Mal ein paar Hunderter mehr oder kaufst eine Radeon die mit Vram protzen. Nein Spaß beiseite, solange du nicht in UHD zockst wirst du vermutlich lange Spaß haben.

Das heißt aber nicht, dass wir diesen Vram Geiz gutheißen sollten gerade bei diesen absurden Gpu preisen.

Tja, je nach Prio hat er dennoch die richtige Karte gekauft, ganz egal welche Auflösung

Rhadon

Komplett-PC-Aufrüster(in)

Verstehe denn Sinn von diesem Post nicht.Tja, je nach Prio hat er dennoch die richtige Karte gekauft, ganz egal welche Auflösung

Zik7

Freizeitschrauber(in)

Ich habe noch nichtmal die 2080 Super, die ich vor ca. 5 Monaten gekauft habe, im Rechner!Der Rooobert sacht: ausm Weg, Geringverdiener

Gruß

Ich armer Mann zocke immer noch mit der RX 6400 oder GTX 1070! Und ich lebe immer noch!

HenneHuhn

Lötkolbengott/-göttin

Tja, je nach Prio hat er dennoch die richtige Karte gekauft, ganz egal welche Auflösung

Dass ich das ganze, fernab irgendwelcher Grabenkämpfe zwischen Team Rot und Team Grün, eher (selbst-)ironisch sehe, dürfte aus meinem Post ja ansatzweise hervorgegangen sein

Ich spiele eh nicht die topaktuellen Grafikkracher (bin bei "AAA(A

)"-Titeln immer mindestens zwei bis drei Jahre hinterher), sondern eher ältere oder Nischen-Games, Tendenz dahingehend steigend.

)"-Titeln immer mindestens zwei bis drei Jahre hinterher), sondern eher ältere oder Nischen-Games, Tendenz dahingehend steigend.Aber was mir persönlich wichtig ist: hohe Energieeffizienz. Ohne da irgendeine persönliche Mission draus machen zu wollen, finde ich es einfach klasse, wenn Hardware gute Performance leistet und dabei so wenig Strom wie möglich frisst. Das hat mich an der 4070 fasziniert, das hat mich damals auch an der 1060 fasziniert (weswegen ich sogar ein entsprechendes "Sidegrade" oder gar Downgrade gemacht habe von meiner damaligen R9 390 aus).

derneuemann

Lötkolbengott/-göttin

Ist nur leichte Kritik an den ganzen Stimmen, die immer vom vram Geiz sprechen, oder ähnliches.Verstehe denn Sinn von diesem Post nicht.

Eine Grafikkarte ist mehr als nur der vram und je nach prio des Käufers, kann auch eine Nvidia GPU mit 12 GB der bessere Kauf, gegenüber der jeweiligen AMD Alternative sein ( egal ob 16, oder 20GB ).

Dass ich das ganze, fernab irgendwelcher Grabenkämpfe zwischen Team Rot und Team Grün, eher (selbst-)ironisch sehe, dürfte aus meinem Post ja ansatzweise hervorgegangen sein

Ich spiele eh nicht die topaktuellen Grafikkracher (bin bei "AAA(A)"-Titeln immer mindestens zwei bis drei Jahre hinterher), sondern eher ältere oder Nischen-Games, Tendenz dahingehend steigend.

Aber was mir persönlich wichtig ist: hohe Energieeffizienz. Ohne da irgendeine persönliche Mission draus machen zu wollen, finde ich es einfach klasse, wenn Hardware gute Performance leistet und dabei so wenig Strom wie möglich frisst. Das hat mich an der 4070 fasziniert, das hat mich damals auch an der 1060 fasziniert (weswegen ich sogar ein entsprechendes "Sidegrade" oder gar Downgrade gemacht habe von meiner damaligen R9 390 aus).

Bei mir war es damals, der hohe idle Verbrauch, die sehr schwache Vorstellung in VR und die Niedrige RT Leistung, weswegen für mich AMD nicht in Frage kam.

Wenn es nur eines, dieser Probleme gewesen wäre hätte ich gut möglich auch zur AMD gegriffen.

Auf der anderen Seite ist DLSS auch eher noch ein Argument.

Es gibt gute Gründe, für fast jeden Kauf, aus Sicht von jedem einzelnen von uns.

Für meine prio, wäre ich sogar weiterhin mit der 4070ti 12 GB in 4k besser bedient gewesen, als mit der 7900xt. Zumindest bis jetzt. Wäre ja möglich das jetzt einige neue Titel kommen, die besser als alles zuvor aussehen und kaum RT beinhalten, dafür aber mega Texturen.

Dann wäre ich mit der xt besser dran, im Vergleich.

Ich denke aber RT nimmt schneller zu.

Ich hatte damals die R9 390x von MSI , erinnere mich noch an die gut 400W

Zuletzt bearbeitet:

Rhadon

Komplett-PC-Aufrüster(in)

Finde ich aber angebracht. Die GTX 1070 hatte 8GB, die RTX 2070 hatte 8GB, die RTX 3070 hatte 8GB. Da finde ich 12GB schon mau für die 4070 denn die Leistung wäre durchaus da für mehr, der Karte wird es genauso ergehen wie der 3070.Ist nur leichte Kritik an den ganzen Stimmen, die immer vom vram Geiz sprechen

Die 3070 wäre mit 16GB eine Klasse Karte geworden. Die 4070 umso mehr und ich denke nach 3 Generationen an 8GB muss man sich nicht mit 50% mehr abspeisen lassen überhaupt, wenn wir von den teuersten Karten aller Zeiten sprechen.

Von der 900€ 12Gb Karte fangen wir gar nicht erst an, was Dreisteres habe ich bislang noch nicht gesehen, die auch noch als 80er gedacht war. Dann auch nur mit einem Bit Bus einer 60er-Karte.

Würde die 4070 399€ kosten lasse ich die 12Gb noch durchgehen aber nicht bei ihren 659€ releasepreis.

Die Kritik ist absolut angebracht und nötig.

derneuemann

Lötkolbengott/-göttin

Finde ich aber angebracht. Die GTX 1070 hatte 8GB, die RTX 2070 hatte 8GB, die RTX 3070 hatte 8GB. Da finde ich 12GB schon mau für die 4070 denn die Leistung wäre durchaus da für mehr, der Karte wird es genauso ergehen wie der 3070.

Die 3070 wäre mit 16GB eine Klasse Karte geworden. Die 4070 umso mehr und ich denke nach 3 Generationen an 8GB muss man sich nicht mit 50% mehr abspeisen lassen überhaupt, wenn wir von den teuersten Karten aller Zeiten sprechen.

Von der 900€ 12Gb Karte fangen wir gar nicht erst an, was Dreisteres habe ich bislang noch nicht gesehen, die auch noch als 80er gedacht war. Dann auch nur mit einem Bit Bus einer 60er-Karte.

Würde die 4070 399€ kosten lasse ich die 12Gb noch durchgehen aber nicht bei ihren 659€ releasepreis.

Die Kritik ist absolut angebracht und nötig.

Genau deswegen weise ich gerne darauf hin, das je nach persönlicher prio, die besagte 900€ Karte das eindeutig bessere Paket bietet, als die AMD Alternative mit 20 GB. Von daher ist die Form der Kritik definitiv hinterfragbar.

Andernfalls könnte man sich ja auch hinstellen und es dreist finden, das AMD für den Preis so wenig RT Leistung bietet, im Vergleich... Das wäre aber Quatsch, weil es bei Grafikkarten um das Gesamtpaket geht und da dann das beste für seine Ansprüche und Geld.

Rhadon

Komplett-PC-Aufrüster(in)

Ich habe in jedem Spiel genug RT Leistung nur nicht in den Nvidia Sponsored Titel. Finde ich jetzt nicht tragisch wegen 2 spielen. Aber wie du sagtest, muss jeder für sich selber abwägen.

Cyberpunk mit RT war mir unmöglich, zumindest nur mit 60 FPS und Upscaling.

Habe es stattdessen in 4k Nativ gezockt mit 70-80 FPS was exakt die Leistung der OG 4080 entspricht, ja die 7900XT (non XTX) ist da auf dem level der 4080 in Cyberpunk ohne RT und knapp 20% vor der 4070TI Super also fast 30% vor der teureren OG 4070TI. RT fand ich jetzt nicht berauschend besser, im Pathtracing Mode aber auf jeden Fall eines der schönsten Games, die ich kenne neben Avatar(was auch auf der Radeon gut läuft).

Aber PT ist unspielbar in meiner Zielauflösung, egal welche Karte und Framegeneration, kann damit nichts anfangen, klar flüssiger aber träger und das merke ich in jedem Spiel auch in Avatar einmal probiert und sofort ausgemacht. Das ist träger als auf einer Konsole mit 30 fps vom Gefühl her. Kann ich Persönlich einfach nicht ab. Dann lieber Upscaling, was ich aber bis auf 2-3 Titel nie brauche da meine Karte in 4k auch nativ genug Fps liefert.

Aber dem muss ich widersprechen eine 4070TI in 4k kannst du schmeißen, Rift apart ist damit nicht spielbar in 4k. Was ich schon als extrem bitter empfinden würde bei einer 900€ Karte und bei einem Konsolenspiel. Dead Island 2 ebenfalls nicht und noch ein paar andere und das jetzt schon.

Aber Nvidia will ja einem weis machen, dass das nur eine 1440p Karte ist, alles klar für 900€. Stimmt aber auch der Bit Bus limitiert in 4k extrem da wird eine reguläre 4070 oft von einer Rx6800 non XT eingeholt oder ganz knapp zumindest. Oder die 4070 ist gleich 20% hinter der 3080 gibt auch genug Beispiele, weil 192 bit bus vs 320 bit bus und ja das merkt man gewaltig, muss man aber probiert haben.

So jetzt gute nacht, bin saumüde @derneuemann

@derneuemann

Cyberpunk mit RT war mir unmöglich, zumindest nur mit 60 FPS und Upscaling.

Habe es stattdessen in 4k Nativ gezockt mit 70-80 FPS was exakt die Leistung der OG 4080 entspricht, ja die 7900XT (non XTX) ist da auf dem level der 4080 in Cyberpunk ohne RT und knapp 20% vor der 4070TI Super also fast 30% vor der teureren OG 4070TI. RT fand ich jetzt nicht berauschend besser, im Pathtracing Mode aber auf jeden Fall eines der schönsten Games, die ich kenne neben Avatar(was auch auf der Radeon gut läuft).

Aber PT ist unspielbar in meiner Zielauflösung, egal welche Karte und Framegeneration, kann damit nichts anfangen, klar flüssiger aber träger und das merke ich in jedem Spiel auch in Avatar einmal probiert und sofort ausgemacht. Das ist träger als auf einer Konsole mit 30 fps vom Gefühl her. Kann ich Persönlich einfach nicht ab. Dann lieber Upscaling, was ich aber bis auf 2-3 Titel nie brauche da meine Karte in 4k auch nativ genug Fps liefert.

Aber dem muss ich widersprechen eine 4070TI in 4k kannst du schmeißen, Rift apart ist damit nicht spielbar in 4k. Was ich schon als extrem bitter empfinden würde bei einer 900€ Karte und bei einem Konsolenspiel. Dead Island 2 ebenfalls nicht und noch ein paar andere und das jetzt schon.

Aber Nvidia will ja einem weis machen, dass das nur eine 1440p Karte ist, alles klar für 900€. Stimmt aber auch der Bit Bus limitiert in 4k extrem da wird eine reguläre 4070 oft von einer Rx6800 non XT eingeholt oder ganz knapp zumindest. Oder die 4070 ist gleich 20% hinter der 3080 gibt auch genug Beispiele, weil 192 bit bus vs 320 bit bus und ja das merkt man gewaltig, muss man aber probiert haben.

So jetzt gute nacht, bin saumüde

@derneuemann

@derneuemannderneuemann

Lötkolbengott/-göttin

Ich habe in jedem Spiel genug RT Leistung nur nicht in den Nvidia Sponsored Titel. Finde ich jetzt nicht tragisch wegen 2 spielen. Aber wie du sagtest, muss jeder für sich selber abwägen.

Naja, da gibt es doch schon mehr Spiele wo die xt nicht mehr reicht, mit der RT Leistung.

Aber gut

Und RT gibt mir eine Tiefenwirkung für Objekte, die ich nicht mehr missen will.

Natürlich nur wo es auch so umgesetzt ist.

Oder RTgi... Traumhaft...

Kannst mich gerne mal besuchen, dann machen wir einen Blindtest mit und ohne FG in alan wake.Cyberpunk mit RT war mir unmöglich, zumindest nur mit 60 FPS und Upscaling.

Habe es stattdessen in 4k Nativ gezockt mit 70-80 FPS was exakt die Leistung der OG 4080 entspricht, ja die 7900XT (non XTX) ist da auf dem level der 4080 in Cyberpunk ohne RT und knapp 20% vor der 4070TI Super also fast 30% vor der teureren OG 4070TI. RT fand ich jetzt nicht berauschend besser, im Pathtracing Mode aber auf jeden Fall eines der schönsten Games, die ich kenne neben Avatar(was auch auf der Radeon gut läuft).

Aber PT ist unspielbar in meiner Zielauflösung, egal welche Karte und Framegeneration, kann damit nichts anfangen, klar flüssiger aber träger und das merke ich in jedem Spiel auch in Avatar einmal probiert und sofort ausgemacht. Das ist träger als auf einer Konsole mit 30 fps vom Gefühl her. Kann ich Persönlich einfach nicht ab.

Achso, ohne maximale Details... Ne, DLSS bietet mir die ein gutes Ergebnis, das ich quasi fast immer mit upscaling spiele.Dann lieber Upscaling, was ich aber bis auf 2-3 Titel nie brauche da meine Karte in 4k auch nativ genug Fps liefert.

Dann sind aber auch einige mehr Titel mit der xt knickbar... Wenn bei der einen nur mit max Details zählt, dann bei der anderen auch.Aber dem muss ich widersprechen eine 4070TI in 4k kannst du schmeißen, Rift apart ist damit nicht spielbar in 4k.

Wie gesagt, die xt macht keinen besseren Schnitt, außer man spricht generell von RT Off, stark reduziert. Und das wäre schon extrem bitter, bei einer 900€ Karte.Was ich schon als extrem bitter empfinden würde bei einer 900€ Karte und bei einem Konsolenspiel. Dead Island 2 ebenfalls nicht und noch ein paar andere und das jetzt schon.

Naja, zumeist landet die ti noch vor der 3090, auch in 4k.Aber Nvidia will ja einem weis machen, dass das nur eine 1440p Karte ist, alles klar für 900€. Stimmt aber auch der Bit Bus limitiert in 4k extrem da wird eine reguläre 4070 oft von einer Rx6800 non XT eingeholt oder ganz knapp zumindest. Oder die 4070 ist gleich 20% hinter der 3080 gibt auch genug Beispiele, weil 192 bit bus vs 320 bit bus und ja das merkt man gewaltig, muss man aber probiert haben.

Ich auch, aber meine Dame quält mich gerade noch durch das NachtlebenSo jetzt gute nacht, bin saumüde@derneuemann

Schori

Volt-Modder(in)

Was hat das CPU Limit mit Anspruch zu tun?Dann machst du was falsch oder hast zu hohe fps Ansprüche für die Hardware, die momentan verfügbar ist.

Dlss eine Stufe knackiger fertig ist das CPU-Limit. Selbs gemachtes Problem wie immer.

Die CPU liefert in bestimmten Szenen einfach weniger FPS als die GPU imstande wäre zu berechnen.

Zik7

Freizeitschrauber(in)

Absolut! Aber leider sind scheinbar nicht viele dieser Meinung! Es wird gekauft, als gäbe es kein morgen!Finde ich aber angebracht. Die GTX 1070 hatte 8GB, die RTX 2070 hatte 8GB, die RTX 3070 hatte 8GB. Da finde ich 12GB schon mau für die 4070 denn die Leistung wäre durchaus da für mehr, der Karte wird es genauso ergehen wie der 3070.

Die 3070 wäre mit 16GB eine Klasse Karte geworden. Die 4070 umso mehr und ich denke nach 3 Generationen an 8GB muss man sich nicht mit 50% mehr abspeisen lassen überhaupt, wenn wir von den teuersten Karten aller Zeiten sprechen.

Von der 900€ 12Gb Karte fangen wir gar nicht erst an, was Dreisteres habe ich bislang noch nicht gesehen, die auch noch als 80er gedacht war. Dann auch nur mit einem Bit Bus einer 60er-Karte.

Würde die 4070 399€ kosten lasse ich die 12Gb noch durchgehen aber nicht bei ihren 659€ releasepreis.

Die Kritik ist absolut angebracht und nötig.

AMD und NVIDIA verlangen zu viel für das gebotene! Da gibt sich keiner was....Genau deswegen weise ich gerne darauf hin, das je nach persönlicher prio, die besagte 900€ Karte das eindeutig bessere Paket bietet, als die AMD Alternative mit 20 GB. Von daher ist die Form der Kritik definitiv hinterfragbar.

Andernfalls könnte man sich ja auch hinstellen und es dreist finden, das AMD für den Preis so wenig RT Leistung bietet, im Vergleich... Das wäre aber Quatsch, weil es bei Grafikkarten um das Gesamtpaket geht und da dann das beste für seine Ansprüche und Geld.

Rhadon

Komplett-PC-Aufrüster(in)

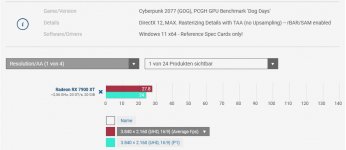

Auch hier niemand hat etwas von max gesagt, alleine die Reflexionen von Ultra auf Mittel zu stellen brachte mir fast 40% mehr Leistung und Wolken auf Medium sonst max 70-80 Fps Average in 4k nativ ohne upscaling.Bin ich mir auch ganz sicher. Ob 4K nativ oder 4K/RT/FSR Q....mit deiner RX 7900XT steppt der Bär.

Anhang anzeigen 1452953Anhang anzeigen 1452954

Seit wann nimmt man PCGH Benchmarks als Wert für die Spielbarkeit her? Da wird nur die Hardware getestet, um einen relativen Vergleich zu schaffen, dafür wird auch gespielt, bis man die Worst Case stelle im Spiel findet, lest ihr eigentlich was die Redakteure schreiben oder schaut ihr nur auf die Balken.

Teste es selbst hier.

Die stelle dürfte bekannt sein hier ist es sogar besonders anspruchsvoll

geh da mit der Karte die du hast dahin mit diesen Settings in nativem 4k.

geh da mit der Karte die du hast dahin mit diesen Settings in nativem 4k.4070 ist hier über 45% langsamer, 4070 TI ist hier über 25% langsamer, 4070 TI Super ist hier 18% langsamer, 4080 ist hier genauso schnell.

derneuemann

Lötkolbengott/-göttin

Da können wir uns drauf einigen!Absolut! Aber leider sind scheinbar nicht viele dieser Meinung! Es wird gekauft, als gäbe es kein morgen!

AMD und NVIDIA verlangen zu viel für das gebotene! Da gibt sich keiner was....

Wie viel zu viel, ist eine andere Sache...

Also AMD maxAuch hier niemand hat etwas von max gesagt,

Aber hier muss es dann max sein?Aber dem muss ich widersprechen eine 4070TI in 4k kannst du schmeißen, Rift apart ist damit nicht spielbar in 4k

Dletzten optischen Schmankerl die meine Frau zuletzt mit ihrer RTX 4070TI gespielt hat

Ich wüsste nicht warum mir da eine RX 7900XT einen Vorteil gebracht hätte.

Raster/Konsolengrafik war gestern.

Cyberpunk ist durch und nicht mehr auf der Platte. Einen Bench habe ich noch gefunden.

Du kannst mir ja zeigen, dass deine RX 7900XT hier 25% schneller ist.

Zuletzt bearbeitet:

Rhadon

Komplett-PC-Aufrüster(in)

Was ist das? Oben siehst du, mit welcher Einstellung ich gespielt habe.Also AMD max

Wer hat das gesagt? Warum willst du mir Worte in den Mund legen?Aber hier muss es dann max sein?

Auch wenn du Sachen reduzierst, wird er platzen in 4k. Klar alles auf Low ginge, aber das wäre auch zu viel des guten bei so einer teuren Karte aber gibt auch sicher Leute, die das Machen, weil mehr fps für manche über alles geht, was natürlich auch in Ordnung ist.

Toxisch hier ohne Grund.

Ähnliche Themen

- Antworten

- 9

- Aufrufe

- 688

- Antworten

- 106

- Aufrufe

- 7K

- Antworten

- 10

- Aufrufe

- 911

- Antworten

- 12

- Aufrufe

- 1K

- Antworten

- 2

- Aufrufe

- 483