Blackfirehawk

Software-Overclocker(in)

Das war jetzt kein Angriff auf Dich. Bitte nicht falsch verstehen.-> Andere Settings, andere Szene

Testet's gerne nach - wir haben soeben verifiziert, dass die Saves übertragbar sind. Anbei der Kombi-Download mit unserem CPU- und GPU-Save. Die Videos verraten, wie getestet wird.

Sobald das jemand gecheckt hat, packen wir's in den Artikel.

MfG

Raff

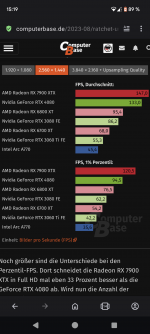

Mir ging es darum das allein die zenenauswahl den Unterschied macht ob AMD oder Nvidia haushoch überlegen ist

.gif)