PC-Bastler_2011

Volt-Modder(in)

AW: Nvidia Geforce RTX 2060: Spezifikationen in Benchmark-Datenbank, Gigabyte-Custom-Design & GPU-Z

psst, scully, Seite 20: Overclocking...

psst, scully, Seite 20: Overclocking...

Ich glaube eher das da eher gemeint ist das nur die Grafikkarte belastet wird. Eine 2070 verbraucht nie im Leben über 300 Watt

Gesendet von iPhone mit Tapatalk

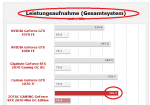

Das ist ein Fehler, das ist Gesamtsystem sieht man auch im Vergleich zur Seite 5.

Liegt meine V56 gar net übel im rennen

Anhang anzeigen 1023110

War das nicht eigentlich ein RTX 2060 thread? Die neue Karte wird ja nicht grad oft mehr erwähnt, seit man sich am Anfang noch über die Vram Menge beschwert hat. Ich gedenke mir demnächst einen Mini Gaming PC zu bauen. Da könnte ich mir gut vorstellen eine RTX 2060 einzubauen. Ev sogar ne Founders Edition, weil sie so schön klein ist falls es sie dann gibt.

Was meint ihr dazu?

Korrekt. Wäre auch jedem klar, der a) über etwas mehr Sachverstand als der gemeine ComputerBild-Leser verfügt und b) nicht Trollen will.Ich glaube eher das da eher gemeint ist das nur die Grafikkarte belastet wird. Eine 2070 verbraucht nie im Leben über 300 Watt

Also - Gesamtsystem 285W, mit Graka-OC 303W. Natürlich braucht die RTX2070 die 300W nicht alleine.HWL Test Seite 5 schrieb:Unser Gesamtsystem genehmigt sich im Leerlauf 73,4 W und liegt damit exakt auf dem Niveau vergleichbarer Modelle. Im Spielebetrieb steigt der Energiehunger auf knapp unter 285 W an, was teilweise 10 bis 30 W unter den höher getakteten Konkurrenz-Modellen mit Triple-Slot-Kühler liegt. Im Vergleich zur GeForce GTX 1080 Ti oder GeForce GTX 1080 ist sie sparsamer.

Die Werte sind wahrscheinlich sogar richtig. Du hast sie nur entweder nicht gelesen, nicht verstanden oder hier schlicht falsch wiedergegeben.Die Werte von HWL sind also nicht gänzlich falsch.

Klein aber fein: Die ZOTAC GAMING GeForce RTX 2070 Mini OC Edition im Test - Hardwareluxx

Ja du liest richtig 303W OC, nur die Karte. Da man eine V64 gut mit der 1070ti/1080 vergleichen konnte usw. ...

Die Aussage "nur Grafikkarte" bezieht sich nicht auf die Leistungsaufnahme, sondern auf das OCing.Hat eine Sekunde gedauert. Er hat dir sogar geschrieben wo.

So testet Hardwareluxx die Grafikkarten - HardwareluxxDie Messungen der Leistungsaufnahme erfolgen mit einem ELV Energie Master Basic. Wir messen die Leistungsaufnahme des Gesamtsystems.

Die Aussage "nur Grafikkarte" bezieht sich nicht auf die Leistungsaufnahme, sondern auf das OCing.

Können wir den lächerlich Trollversuch von olletsag jetzt einfach mal abhaken? Er hatte keine Ahnung, hat nicht nachgedacht und Mist erzählt. Und nun erzählt er noch mehr Mist, um den ersten Mist zu überdecken. Kennen wir so von kleinen Kindern. Damit muss man aber keinen ganzen Threads schreddern.

Gurdi, olletsag und johnjoggo sind doch das AMD Pendant zu scully, was erwartest du?

Ich warte nur auf die ersten Effizienzwundermeldungen der Vega vs. RTX 2070.

Vega bringst doch locker auf das Effizienz Niveau.

Wir haben doch schon alle geschrieben das es sich dabei ums Gesamtsystem handelt du Troll. Du rennst einem Phantom hinterher.

Ihr solltet vielleicht mal eurem Markenkollegen einfangen, bevor er sich weiter mit solchen Aussagen blamiertJa du liest richtig 303W OC, nur die Karte.

Warum auch immer man falsche Fakten wiederholt, statt sofort zu sagen, dass olletsag schlicht nicht verstanden hat, was er da verlinkt hat. Wäre der Forenhygenie sehr zuträglich.Darum gings nicht. Er hat gefragt wo er das hernimmt. Da.

Warum willst du dein Geld mit einer Vega verplempern?Bei einem Budget von ca. 500€ wäre es im Moment ne 2070. Bei 450 halt ne Vega.

Warum auch immer man falsche Fakten wiederholt, statt sofort zu sagen, dass olletsag schlicht nicht verstanden hat, was er da verlinkt hat. Wäre der Forenhygenie sehr zuträglich.

Warum willst du dein Geld mit einer Vega verplempern?

Die Karte ist deutlich langsamer, als eine 2070, nimmt deutlich mehr Leistung auf, unterstützt kein DXR - dafür will man im fast Jahr 2019 noch fast 500€ hinlegen? Nur mit der dicken Markenbrille.

Man sollte falschen Aussagen widersprechen und nicht noch "belegen".Bin ich ein Papagei? Les die vorherigen Posts, ich hab ihm nur gezeigt wo die Annahme herkommt.

Eigentlich male ich äußerst selten etwas weiß anSo zu Vega. Wenn jemand 450€ Budget hat, Vega dür 440 im Mindstar ist und du ihm ne 489€ 2070 empfiehlst beweißt das nur eins.

Du kannst kein Mathe.

Man sollte falschen Aussagen widersprechen und nicht noch "belegen".

Eigentlich male ich äußerst selten etwas weiß an ;D

Bewiesen wäre aber, dass du kein Deutsch kannst. Und deine Empfehlung auf ziemlich merkwürdigen Anforderungen beruhen. Wenn jemand nur 450€ hat, sollte man ihm empfehlen noch die 39€ für die 2070 zu sparen. Einfach weil er die bessere und zukunftsfähigere Karte erhält. Das wäre in diesem Falle die beste Empfehlung. Vega geht nur mit einem massiven AMD-Bias.

Und das kritisiere ich. Weil es der falsche Umgang ist.Ich belege die Aussage nicht. Ich sag ihm wo sie herkommt. Wie gesagt. Ich bin kein Papagei.

Dann sollte man diesen Leuten empfehlen, zu warten, bis eine RTX2070 für 450 zu bekommen ist.Weißt du. Es gibt Leute die WOLLEN x ausgeben. Denen muss ich nicht sagen das Budget zu erhöhen weil sie es offensichtlich nicht wollen.

NöAber naja, du denkst ja auch ein 4K Monitor wäre ein Fehlkauf nur weil er Freesync hat.

Aber du bist offensichtlich nicht in der Lage Deutsch zu verstehen. Aber das hattest du ja schon "bewießen"

Aber du bist offensichtlich nicht in der Lage Deutsch zu verstehen. Aber das hattest du ja schon "bewießen"

Niemand neutrales würde eine Option perse ablehnen.

Aber dass du Grundsätzlich nicht neutral bist wissen wir schon länger. Was das NT angeht, ich weiß ja nicht was du für Netzteile kaufst, aber die meißten leute die ich kenne verbauen Netzteile die ne Vega stemmen können und die Vega-Arch ist auch für moderne Titel nicht schlecht.

Aber das Konzept von festem Budget ist dir kein Begriff.