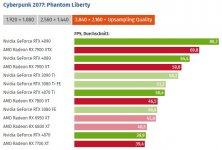

Ähm... maximale Optik schloss schon immer auch maximale Auflösung mit ein. Hier mal der aktuelle Leistungsindex UHD.

Anhang anzeigen 1441976

Da ist die 4070 langsamer als die Jahre alte Radeon RX6800XT, oder die 3080.

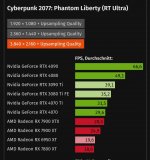

Erst maximale Details und dann Auflösung

.

Das ist meine Ansicht. Aber klar einige scheinen neue GPU s für das Gestern zu kaufen, für mich ok.

Spaß bei Seite.

Jeder hat seine eigenen Prioritäten usw.

Der eingeht lieber auf 4k, ein anderer auf RT, wieder andere auf 1080p 240hz usw.

Das ist alles individuell!

Jeder kauft für sich die beste Option.

Aber letztendlich ist es so, das AMD nur der bessere Kauf ist, wenn man auf RT verzichten will.

Das ist alles.

Was aber absolut legitim ist. Ich meine, ich selbst überlege auch immer mal wieder stattdessen auf non RT, aber dafür 4k zu gehen mit einer 7900xtx.

Zu AMDs frame Generation habe ich mich schon positiv geäußert, bevor mir wieder irgendwer etwas Ansichten möchte.

Beste Optik setzt ja erstmal höchste Auflösung voraus.

Davon ab kann man auch darüber streiten ob Raytracing oder ein guter HDR-Monitor wichtiger für beste Bildqualität ist...

Ne, anders herum , ?

HDR und AMD ? Ich dachte das geht nur eingeschränkt.

Individuell.

Beste Optik in 1080p, in 1440p und 4k inkludiert immer RT, stand heute.

Achso, alles natürlich inkl. HDR für beste Optik.