Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Geforce GTX 1080 Ti versehentlich von Zotac geleakt?

- Ersteller PCGH-Redaktion

- Erstellt am

Ich denke sogar ganz stark daran das die GTX 1080 Ti noch gar nicht mit HBM 2.0 startet. Nvidia ist mit GDDR5X angefangen und wird das auch erstmal durch ziehen. Luft nach oben ist allemal und in der nächsten Generation kann man dann alle *80, *70 mit HBM 2.0 ausstatten und die *60, *50 mit GDDR5X. Klingt für mich sehr plausibel. Mit GDDR5X ist bestimmt noch einiges anzufangen ^^

Versuch mal aktuelle Spiele in 4K mit konstanten 60fps zu spielen. Das schaffen nicht mal zwei GTX1080 immer.

Könnte man doch zu einem Gsync-Monitor greifen, oder?

FaySmash

PC-Selbstbauer(in)

Habe ich doch.

Nur 4k ist mit der 980... sagen wir mal schwierig

dann ist es mit meiner 970 wohl...schwieriger. Hab den monitor gekauft und kann jetzt seit 3 monaten nichts spielen weil ich nur so 20fps raus bekomm. muss jetzt aber noch länger auf die evga 1080 hybrid warten ;-;

Oberst Klink

Lötkolbengott/-göttin

Das Speichermanagement von HBM ist in der Tat besser, aber ich bezweifle einfach mal, dass auch 4GB HBM Speicher auf Dauer im High-End Bereich ausreichen wird. Und dabei meine ich natürlich 4k und Multi-Monitor-Settings und High-End-VR im Zeitraum der nächsten zwei bis drei Jahre. Für FHD und WQHD ist 4GB HBM Speicher aktuell natürlich völlig ausreichend. Der Vergleich mit 16GB DDR3 und 4GB GDDR5x macht überhaupt keinen Sinn. Es geht hier ja schon explizit um den Vergleich zwischen GDDR5x und HBM.

Der Vergleich ergibt schon Sinn, weil du behauptet hast die Geschwindigkeit wäre irrelevant.

Ganz ehrlich, es gibt imo kein größeres Pseudo-Argument in dem ganzen Bereich als der Energieverbrauch. Ob eine Spiele-GPU wegen dem Speicher jetzt 20, 30 oder 50 Watt mehr oder weniger Energie verbraucht, interessiert in der Realität doch nun wirklich keine Sau. Zumal ich da jetzt bei nvidia keine gravierenden Nachteile durch die Verwendung von GDDR5x sehe...

Weniger Verbrauch bedeutet auch dass man die Karte entweder bei gleicher Temperatur leiser machen kann oder sie bei gleicher Lautstärke kühler bleibt.

Scholdarr

Volt-Modder(in)

In dem Rahmen, den wir hier diskutieren, stimmt das ja auch.Der Vergleich ergibt schon Sinn, weil du behauptet hast die Geschwindigkeit wäre irrelevant.

Eine kühle Karte ist aber kein Selbstzweck. Wenn man sie besser übertakten kann, dann ist das relevant. Wäre mir jetzt aber neu, dass die Fury X z.B. extremes Übertaktungspotenzial hätte. Ich will ja auch gar nicht sagen, dass HBM schlecht ist. Ich bin nur der Meinung, dass die Geschwindigkeit des Speichers in diesen Regionen eher von untergeordneter Bedeutung im Gesamtbild ist.Weniger Verbrauch bedeutet auch dass man die Karte entweder bei gleicher Temperatur leiser machen kann oder sie bei gleicher Lautstärke kühler bleibt.

Könnte man doch zu einem Gsync-Monitor greifen, oder?

Synchrone fps sind zwar schön, ersetzen aber nicht viele fps.

Zu dem Zeitpunkt als ich meinen 4K-TFT gekauft habe gabs auch schlichtweg kein G-Sync.

I3uschi

Software-Overclocker(in)

Der Neid ist stark in mir...

Ach ne, so der Knaller ist er auch nicht. Gibt besseres, aber für den Preis und dem Gebotenen bin ich zufrieden.

Acer Predator XB1 71 cm Monitor schwarz/rot: Amazon.de: Computer & Zubehor

dann ist es mit meiner 970 wohl...schwieriger. Hab den monitor gekauft und kann jetzt seit 3 monaten nichts spielen weil ich nur so 20fps raus bekomm. muss jetzt aber noch länger auf die evga 1080 hybrid warten ;-;

Ja, die 980 mit den paar FPS mehr ist auch zu wenig. Jacke wie Hose.

Ich nenne die 1080 einfach mal 4k @30 FPS Karte (bei anspruchsvollen Spielen), aber wenn die 1080 Ti so in den 50er Bereichen pendeln würde, dann wäre das schon ziemlich FETT!

Und ein paar Einsparungen kann man zur Not ja auch noch machen, Kantenglättung ist ja dann nicht mehr ganz so wichtig. Hier und da ggf. noch einen Regler von -Ultra- auf -Hoch- und dann könnte es ja vielleicht klappen mit den 60 FPS!?

Und für so ein Doom reicht auch schon die 1080 für den visuellen Overkill.

Zuletzt bearbeitet von einem Moderator:

EMkaEL

Schraubenverwechsler(in)

hier ist das bild mit dem Ti kürzel.. direkt von der Zotac website:

https://www.zotac.com/download/files/overview/amp_extreme_lp-overview_r1.jpg

https://www.zotac.com/download/files/overview/amp_extreme_lp-overview_r1.jpg

I3uschi

Software-Overclocker(in)

hier ist das bild mit dem Ti kürzel.. direkt von der Zotac website:

https://www.zotac.com/download/files/overview/amp_extreme_lp-overview_r1.jpg

Der Link funzt nicht, zeigt irgend ein Error an.

GS85

Kabelverknoter(in)

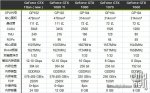

Ich hab mir vor einiger Zeit schon eine Tabelle erstellt um die Zahlen vergleichen zu können.

Habe die Taktraten mal durch die Formeln für die 1080 gejagt.

Die 1080 erreicht bei 1773Mhz 110,9GPixel

Die 1080 Ti würde mit 1344 Mhz 107,5 GPixel erreichen. (bei angenommen 3200 Shadereinheiten. genau zwischen 1080 und Vollausbau des GP100)

Eindeutig zu wenig, aber nimmt man Wert als Standardtakt und zählt wie bei 1080 126Mhz Boost dazu sieht das so aus:

Die 1080 Ti würde so auf 1470Mhz boosten und 117,5GPixel erreichen.

Die 1080Ti könnte dann bei 1773Mhz 138,6GPixel erreichen.

980 77,8GPixel

980 Ti 94,6GPixel

Titan X 103,2 GPixel

Keine Garantie, dass die Zahlen 100%ig stimmen. Die Zahlen für die 1080Ti sind frei erfunden und stellen nur eine mögliche Weiterentwicklung dar.

256Bit sollten 8 oder 16GB bringen. Hängt mit dem Controller zusammen.

384Bit bringen 6 oder 12GB.

224Bit von der 970 hätten nur 3,5GB haben dürfen.

Habe die Taktraten mal durch die Formeln für die 1080 gejagt.

Die 1080 erreicht bei 1773Mhz 110,9GPixel

Die 1080 Ti würde mit 1344 Mhz 107,5 GPixel erreichen. (bei angenommen 3200 Shadereinheiten. genau zwischen 1080 und Vollausbau des GP100)

Eindeutig zu wenig, aber nimmt man Wert als Standardtakt und zählt wie bei 1080 126Mhz Boost dazu sieht das so aus:

Die 1080 Ti würde so auf 1470Mhz boosten und 117,5GPixel erreichen.

Die 1080Ti könnte dann bei 1773Mhz 138,6GPixel erreichen.

980 77,8GPixel

980 Ti 94,6GPixel

Titan X 103,2 GPixel

Keine Garantie, dass die Zahlen 100%ig stimmen. Die Zahlen für die 1080Ti sind frei erfunden und stellen nur eine mögliche Weiterentwicklung dar.

256Bit sollten 8 oder 16GB bringen. Hängt mit dem Controller zusammen.

384Bit bringen 6 oder 12GB.

224Bit von der 970 hätten nur 3,5GB haben dürfen.

Zuletzt bearbeitet:

EMkaEL

Schraubenverwechsler(in)

borni

Software-Overclocker(in)

Ich hab mir vor einiger Zeit schon eine Tabelle erstellt um die Zahlen vergleichen zu können.

Habe die Taktraten mal durch die Formeln für die 1080 gejagt.

Die 1080 erreicht bei 1773Mhz 110,9GPixel

Die 1080 Ti würde mit 1344 Mhz 107,5 GPixel erreichen. (bei angenommen 3200 Shadereinheiten. genau zwischen 1080 und Vollausbau des GP100)

Eindeutig zu wenig, aber nimmt man Wert als Standardtakt und zählt wie bei 1080 126Mhz Boost dazu sieht das so aus:

Die 1080 Ti würde so auf 1470Mhz boosten und 117,5GPixel erreichen.

Die 1080Ti könnte dann bei 1773Mhz 138,6GPixel erreichen.

980 77,8GPixel

980 Ti 94,6GPixel

Titan X 103,2 GPixel

Keine Garantie, dass die Zahlen 100%ig stimmen. Die Zahlen für die 1080Ti sind frei erfunden und stellen nur eine mögliche Weiterentwicklung dar.

256Bit sollten 8 oder 16GB bringen. Hängt mit dem Controller zusammen.

384Bit bringen 6 oder 12GB.

224Bit von der 970 hätten nur 3,5GB haben dürfen.

Man munkelt 3456 Shadereinheiten bei der Ti.

GS85

Kabelverknoter(in)

GP100 beim Tesla mit 3456 Einheiten, wurde vermutlich gemacht um die DP und die Stückzahl zu erhöhen.

Die 1080Ti mit 3456 Einheiten könnte dann bei 1344Mhz 116,1GPixel erreichen. Sie wäre also schon minimal schneller als die 1080.

1080Ti mit 1470Mhz würde 127,0GPixel erreichen.

1080Ti mit 1621Mhz würde 140,1GPixel erreichen.

1080Ti mit 1773Mhz würde 149,7GPixel erreichen.

Die 1080Ti mit 3456 Einheiten könnte dann bei 1344Mhz 116,1GPixel erreichen. Sie wäre also schon minimal schneller als die 1080.

1080Ti mit 1470Mhz würde 127,0GPixel erreichen.

1080Ti mit 1621Mhz würde 140,1GPixel erreichen.

1080Ti mit 1773Mhz würde 149,7GPixel erreichen.

Ähnliche Themen

- Antworten

- 36

- Aufrufe

- 2K

- Antworten

- 17

- Aufrufe

- 877

- Antworten

- 85

- Aufrufe

- 4K

- Antworten

- 21

- Aufrufe

- 1K

- Antworten

- 7

- Aufrufe

- 736