Hat irgendjemand von Euch meinen Beitrag bzw. den ART-Mark Test von PCGH richtig gelesen? Das ist ein reiner RT-Test und AMD holt mit steigender RT-Last auf in Richtung Ampere und setzt sich von Turing ab [...]

Mir scheint eher du hast dich "verguckt" oder dort etwas missverstanden.

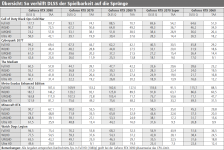

RTX 3090 zu RX 6900 XT

RT High: +128 %

RT Abs.Overkill: +105 %

Da gibt es keinen nennenswerten Leistungszugewinn und Ampere bleibt hier mehr als doppelt so schnell. Und wenn man den Vergleich noch etwas schräger haben will:

RTX 3060 Ti zu RX 6900 XT

RT High: +23 %

RT Abs.Overkill: +22 %

Hier bleibt AMDs Topmodell im gleichen Maße langsamer als das Mittelklassemodell der Konkurrenz.

Was du hier zu erklären versuchtest entbehrt jedweder Substanz. Der "Benchmark" zeigt eher sehr drastisch (aufgrund der extrem überzogenen RT-Last) wie schlecht RDNA2 hier abschneidet.

Unabhängig davon ist aber auch die Frage ob der ART-Mark ein guter/sinnvoller Vergleich bzgl. der Raytracing-Funktionalität ist. Der Autor erklärt leider keine Details, sodass nur zu vermuten bleibt, dass hier grundlegend die Funktionalität der UE4 genutzt wird und die ist selbstredend implementationstechnisch nicht auf eine derart extreme Nutzung ausgelegt und daher bzgl. zukünftigen Raytracingtiteln wohl eher nicht repräsentativ, denn bei einem derart hohen RT-Anteil müsste man die Engine sinnvollerweise umstrukturieren.

Bereits das "

No RT Extreme"-Setting im ART-Mark zeigt eine deutlich Schieflage, denn hier konkurriert eine RX 6900 XT gerade mal mit Mühe mit einer kleinen RTX 3060 Ti, was eigentlich nicht sein sollte.

Die UE4 ist grundlegend eine Rasterizer-Engine die (relativ spät) um zusätzliche RT-Funktionalität erweitert wurde, wobei das RT hier optional und im überschaubarem Rahmen zur grafischen Aufwertung dienen soll. Bei einer derartigen Extremnutzung wird man voraussichtlich mit vielerlei Ineffizienzen in der Engine kämpfen müssen. Der "Benchmark" ist sicherlich nett und schafft es mit einem synthetischen Workload die Hardware an ihre Grenzen zu bringen, wird aber keinesfalls repräsentativ für die allgemeine Leistungsfähigkeit oder aber etwa zukünftige, echte Titel sein.

Der mit Abstand beste Kandidat dürfte derzeit die

Metro Exodus Enhanced Edition sein, deren Engine explizit auf RT ausgelegt und die in diesem Zuge um unnötigen Rasterizer-Balast im Beleuchtungssystem befreit wurde. Hier zeigt sich auch ein weitaus stimmigeres Bild bzgl. der Leistung von RDNA2.

Ultra Quality + Ultra Raytracing (PCGH), RTX 3090 zu RX 6900 XT

FullHD: +33 %

QHD: +40 %

4K: +51 %

Der Unterschied zwischen Ampere und RDNA2 ist nun nicht mehr ganz so groß.

Der Abfall in (Richtung) 4K ist schlicht auf den beschränkten Infinity Cache zurückzuführen, der mit zunehmender Auflösung eine geringere Hit Rate aufweist, sodass die Speicherbandbreite leidet, da immer mehr Speicherzugriffe bis auf das langsame GDDR6 durchgereicht werden müssen.

Die RTX 3060 Ti rangiert hier deutlich unterhalb der RX 6900 XT. Beides sind erwartbare und plausible Beobachtungen und sicherlich plausibler, als dass Ampere hier mehr als doppelt so schnell sein soll und dass selbst eine Mittelklassekarte AMDs Topmodell in den Boden rendert.

Da ME EE auch für die NextGen-Konsolen mit den erweiterten Features erschienen ist, kann man hier nicht einmal nennenswert annehmen, dass hier RDNA2 optimierungstechnisch vernachlässigt wurde. Auch auf den Konsolen wird die stark überarbeitete RT-Engine genutzt und ebenso mitsamt einer deutlich erhöhten Bounce-Zahl. Lediglich advanced raytraced reflections fehlen hier, verschmerzbarerweise, da in der Natur nicht allzu viel spiegelt und die überwiegend für Wasserflächen angewendet werden und letzten Endes sind die Leistungsreserven der Konsolen deutlich beschränkter.

Unterm Strich könnte man wohl bestenfalls einwerfen, dass das ein erster derart hochgradig spezialisierter und angepasster Wurf für die NextGen-Konsolen und damit RDNA2 ist, darüber hinaus erscheint es jedoch eher abwegig hier mehr anzunehmen, d. h. ich würde mit Blick auf diese Engine-Modifikation annehmen, dass die derzeit am ehesten einen halbwegs verwertbaren Blick auf die RT-Zukunft geben dürfte.

OUT NOW! We’re happy to let you know that the Metro Exodus PC Enhanced Edition is now released, bringing on board incredible improvements for Ray Tracing-capable GPUs, including Field of View options, DLSS 2.0, and much more. It is also a free entitlement to current owners – as it is so extensive

www.4a-games.com.mt

.gif)