Ich habe auch nie behauptet, dass sie es erfunden haben. Nvidia hat es aber Spieletauglich gemacht und zwar vor AMD, daher kannst du dir sowas klemmen:

Spieletauglich?

Hmm.. ist Ansichtssache.

Immerhin ist es keine Kunst, sich einen Aspekt von RT rauszugreifen, anstelle gleich alles zu wollen...

Oder doch.. die Kunst des Minimalismus.

RT ist so spieletauglich, dass selbst in den Tech Demos nicht alles 100% gespiegelt wird (In der berühmten Roboter Demo von Nvidia werden z.B. die Funken des rotierenden Bots nicht gespiegelt, obwohl er im Spiegel voll im Blick ist).

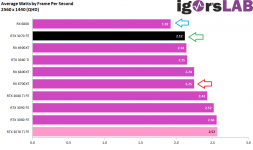

In den Spielen wird dann gern einiges ausgeklammert und nie gibt es GI, Schatten und Reflexionen gemeinsam bei halbwegs performantem Gameplay. Dann muss halt direkt der Upscaler ran, um die FPS in spielbare Bereiche zu schubsen - und das bei ner 3090.

Es gab schon immer Upscaler, aber FSR/RSR kam erst nach DLSS. Nvidia war also auch hier mal wieder Vorreiter und genau darum ging es.

Geschummelt ist da auch nichts.

Natürlich ist da viel geschummel bei - das ist das Grundprinzip eines Upscalers.

Billig hochrechnen und da Details sparen, wo sie nicht auffallen.

Alles läuft auch ohne. Du brauchst auch keine Graka, weil die CPU die Berechnungen ebenfalls übernehmen könnte, aber das zeigt im Grunde nur, dass du nicht checkst um was es geht.

DLSS läuft auch ohne Tensorkerne, ist aber mit diesen viel effizienter/schneller.

Nach Tests langweilen sich die Tensor Kerne die meiste Zeit.

Was hat das mit meiner Aussage zutun? Dein Bashing interessiert niemanden.

Das fiel mir einfach im Kontext Marketing vs. Realität ein.

Das ist auch kein Bashing, sondern schlicht Fakt.

Wenn man rein mit CUDA arbeitet, sind es auch 10.496 Kerne.

Aber halt so gut wie nur da.

Es gibt genug, die sich von der Kernzahl blenden lassen

P.S. es ist durchaus möglich, dass eine Antwort auf einen Kommentar auch Teile enthält, die sich nicht auf den beantworteten Beitrag beziehen.