RawMangoJuli

Lötkolbengott/-göttin

klingt ja erstmal ganz gut

videocardz.com

videocardz.com

wird aber sicherlich recht schnell nen workaround geben

und btw Kimi hatte mal wieder Recht

NVIDIA announces Crypto Mining Processor series, GeForce RTX 3060 driver will limit mining performance - VideoCardz.com

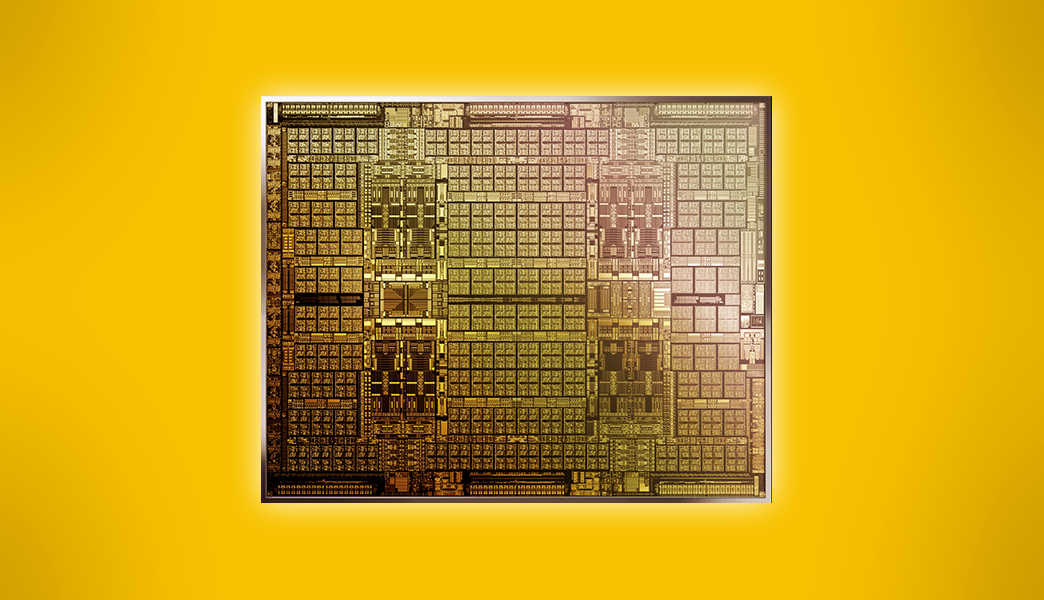

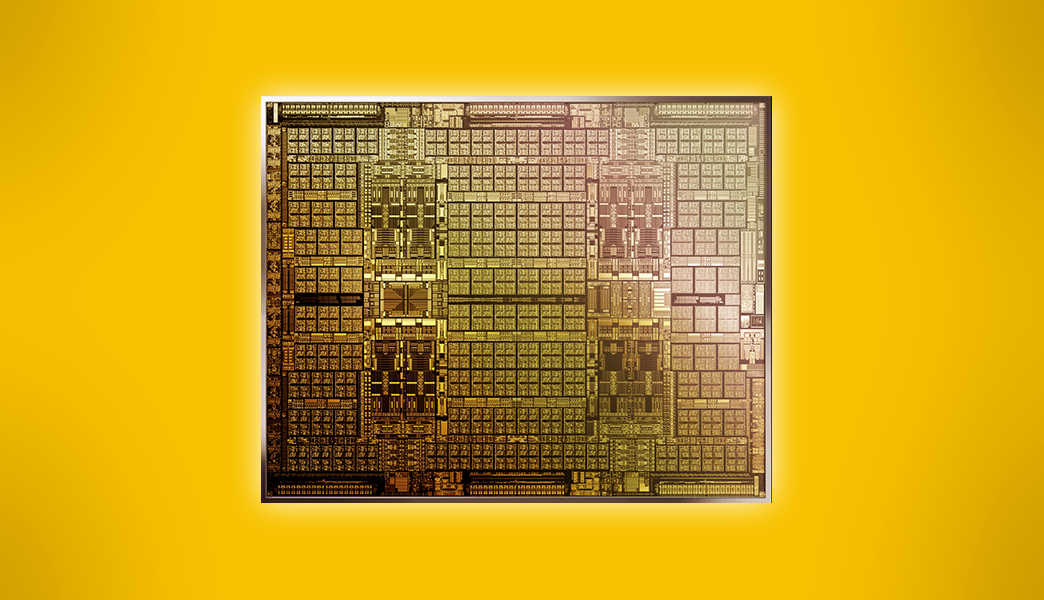

NVIDIA announces Crypto Mining Processor (CMP) HX series NVIDIA announces its GPUs designed for crypto mining. NVIDIA Crypto Mining Processor, Source: NVIDIA NVIDIA has just announced a new series of products designed specifically for cryptocurrency mining. The new series is in response to the...

wird aber sicherlich recht schnell nen workaround geben

und btw Kimi hatte mal wieder Recht

Zuletzt bearbeitet: