Jetzt ist Ihre Meinung gefragt zu Neuer Standard: Erster Monitor mit DisplayPort 2.1 UHBR20

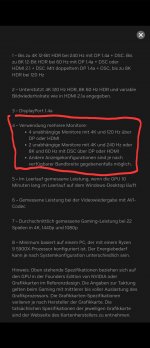

Wenn es eine Sache auf der CES 2024 gegeben hat, dann waren dies neue OLED-Monitore. Auch Gigabyte kündigte neue Bildschirme an. Darunter eine echte Neuheit.

Bitte beachten Sie: Der Kommentarbereich wird gemäß der Forenregeln moderiert. Allgemeine Fragen und Kritik zu Online-Artikeln von PC Games Hardware sind im Feedback-Unterforum zu veröffentlichen und nicht im Kommentarthread zu einer News. Dort werden sie ohne Nachfragen entfernt.

Zurück zum Artikel: Neuer Standard: Erster Monitor mit DisplayPort 2.1 UHBR20

Wenn es eine Sache auf der CES 2024 gegeben hat, dann waren dies neue OLED-Monitore. Auch Gigabyte kündigte neue Bildschirme an. Darunter eine echte Neuheit.

Bitte beachten Sie: Der Kommentarbereich wird gemäß der Forenregeln moderiert. Allgemeine Fragen und Kritik zu Online-Artikeln von PC Games Hardware sind im Feedback-Unterforum zu veröffentlichen und nicht im Kommentarthread zu einer News. Dort werden sie ohne Nachfragen entfernt.

Zurück zum Artikel: Neuer Standard: Erster Monitor mit DisplayPort 2.1 UHBR20