Nein, der Sicherheitsfaktor beträgt 1,1 bis 1,5 je Nachdem wie die Kabel ausgelegt sind.

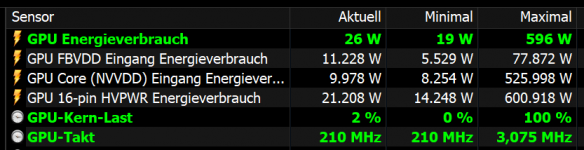

Der Sicherheitsfaktor zur maximalen Leistungsaufnahme innerhalb der Spezifikation. Dort sind weitere Sicherheitsfaktoren eingeplant, die über die Spezifikation hinausgehen, oder denkst du das Teil explodiert, wenn kurz mehr wie 600 Watt über den Stecker laufen?...

Beim 8pin sind es 1,9 bis 2,5.

Das ist schon ein gewaltiger Unterschied.

Die Rechnung ist schlicht und ergreifend so blödsinnig.

Natürlich habe ich innerhalb der Spezifikation der Kabel einen größeren Sicherheitsfaktor, wenn ich satte 4 Stecker verbaue. Aber das ist doch kein sinnvoller Vergleich.

Es geht doch gerade darum nur noch einen Stecker zu verwenden, wo vorher 3x 8 Pin nötig waren bzw. nimmt man es genau 4x 8 Pin.

Ich kann auch 6x 8 Pin verbauen und dann über einen Sicherheitsfaktor reden.

Nur brauche ich das einfach nicht.

Wie schon gesagt wurde: Billiger muss es werden. Kunde kauft für 2000€ eine GPU und am Kabel wird 1€ gespart.

Das ist einfach absolut inakzeptabel und dreist.

Es ist einfach falsch was du schreibst.Da wird nicht nur 1 Euro gespart.

Und wo soll das Problem liegen, alles bis 600 Watt liegt in der Spezifikation und bietet genügend Sicherheitsfaktor, der immer außerhalb der Spezifikation draufgerechnet wird. Wozu soll ich einen Arsch voll Kabel verbauen, wenn das gar nicht nötig ist.

Ich kann auch auf einer 3050 6GB nen 8 Pin Connector verbauen, weil mir der Sicherheitsfaktor der übers Mainboard laufenden Stromversorgung unsympathisch ist. Bringen tut's trotzdem nichts und machen tut's auch keiner.

Sinnwidrig.

Tut mir leid, aber ich kann beim besten Willen nicht verstehen wie man diesen Stecker verteidigen kann.

Wie konnte man dann 15 Jahre lang auf 300 Watt Karten nur 2x 8 Pin verbauen.

Hatte doch kaum Sicherheitsfaktor...

Er hat gerade mal einen Sicherheitsfaktor von 1,1.

Nein, das hängt davon ab, welche Karte du damit betreibst. Wenn wir schon bei dieser Grundschulrechnung bleiben. Hängst du eine 4070 Super dran, liegt der Sicherheitsfaktor zur max Spezifikation bei knapp Faktor 3.

Hängst du eine stark übertaktete 4090 ran und reizt die Spezifikation aus, hast du immer noch genügend Spielraum, da der Stecker im Notfall auch 1500 Watt aushalten kann. Siehe Gamers Nexus. Da ist nichts auf Kante genäht.

Auch der 8 Pin verträgt elektrisch deutlich mehr als spezifiziert ist und dennoch würde jeder abraten das dauerhaft so zu betreiben.

Und es geht hier um einen verdammten Stecker für ein paar € an dem gespart wurde. Da gibts nicht zu verteidigen.

Doch, wenn die Kritik inhaltlicher Bullshit ist, muss man das verteidigen.

Wo blieb denn die Kritik bei den 200 Watt 4070 Karten mit nur einem 8 Pin?

Da ist nach den alten Standards noch weniger Sicherheitsfaktor drauf. Interessiert aber niemanden. Und daran merkt man es. Es geht nur um Clickbaiting.

Und dass der Sicherheitsfaktor gerade mal 1,1 beträgt, wie du selbst geschrieben hast, ist nunmal ein Fakt.

Das hängt davon ab was ich an den Anschluss hänge.

Es ist überhaupt kein Problem die Spezifikation mit OC auszureizen.

Man könnte auf einer RTX Titan auch 2 von den Steckern verbauen, dann kann man sich mit Sicherheitsfaktoren gegenseitig erschlagen.

Oder dann 5 oder 6 8 Pin. Nur wozu?

.gif)