ALso ich habe keine Probleme damit auf 720p runter zu stellen.Und auch das glück in Zukunft auf RTX und so verzichten zu können.Ich schalte sogar andere Effekte die nix mit RTX zu tuen haben auch automatisch aus.Man kann sagen das ich in letzter Zeit noch nie auf maximale Details gezockt hatte.Somit bin ich was das angeht total unempfindlich.Wenn es geht versuche ich schon auf das Native 1080p zu zocken aber wenn es nicht geht auch nicht schlimm.

Es kommt ja bald ein Game raus wo dann auf minium 2060 sein wird,wobei das nun auf rtx 2080 gestiegen ist in den letzten Tagen ,siehe hier:

Direct Contact is about Authentic Warfare, First-person Tactical realism experiences. Most weapons are in the same specs for each classification today, making most modern combat asymmetrical.

store.steampowered.com

Und ja das wird nicht mal auf alles auf niedrigste und dann auf 720p zum laufen gehen.Das heißt ich kann das game nicht mit einer gtx 1650 starten.ALso verloren.

Wenn es noch mehr solcher Games kommen,dann besiegelt es sogar noch viel schneller das Ende von GTX,ganz sicher.

Äh es ist schon draußen heißt Alan Wake 2.

Kannst auf einer 1080ti schon starten aber das wird auf Low und RT eine 10 Fps show.

Es werden auf jedenfall immer mehr Spiele die nicht mehr auf GTX laufen.

Die Fallbacks werden rausgenommen, aber irgendwann ist es halt vorbei.

Meine GTX1080 hat lange Zeit gehalten. aber inzwischen gibt es Spiele da reicht in 1080p kein FSR Quali mehr.

Da musst abspecken in Settings, irgendwann sollte man einfach upgraden.

Hab eine RTX4070 und kann dir sagen, das ist schon krass der Unterschied.

Auf 1080p kannst da mit Pathtracing, alles auf Anschlag zocken Frame Gen machts möglich.

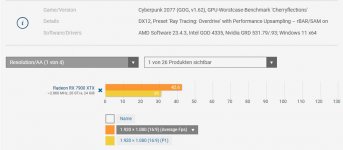

Denn Cyberpunk ist sogar in 1080p mit allen Settings gerade mal 52 Fps drin.

Mit Frame Gen hast dann 90 Fps im Schnitt, also gut puffer nach oben.

Selbst eine 4060 dürfte mit der Ki Technik echt nicht schlecht abschneiden.

Ich hätte schon noch gerne Treiber für meine GTX 1080 ti im Zweitrechner. Immerhin kann ich bis heute alle Spiele außer Alan Wake 2 damit zocken und dass auch oft ohne Probleme in 1440p. Also 3-4 Jahre aktiven Treibersupport hätte ich daher schon noch gerne. Aber da würde mir auch jedes Quartal ein neuer Treiber reichen. Man denke auch an die Käufer von neuen Nvidia GTX und GT Billigkarten für E-Sport Titel oder Barebone PC`s. Immerhin stellt Nvidia bisher bei kritischen Sicherheitslücken immer noch neue Treiber zur Verfügung. Auch bei sehr alten Karten. Daher habe ich auch noch eine GTX 660 im Bürorechner.

Remant 2, Lord of the Fallen also Unreal kannst eben nicht mehr zocken.

Meine GTX1080 hat da aufgeben und die 30% mehr reicht da bei weitem nicht mehr aus.

Wenn Unreal eine Engine wo praktisch wieder jeder verwendet solche Probleme macht, dann kann man

das nicht mehr schön reden.

Vieles läuft ja noch gut auf den Karten, aber High-End Games halt echt nicht mehr.

Neue Treiber bringen ja da auch nicht mehr viel, weil der Focus komplett fällt.

Pascal könnte mehr, aber man hat da paar Leute abgestellt und das war es.

Aber ist ja noch Glück mit einer 5700er würde man sich jetzt echt verarscht vorkommen.

)

) )

)