Jetzt ist Ihre Meinung gefragt zu Radeon RX 7900 XT(X): Neues Treiber-Update reduziert teilweise hohen Stromverbrauch

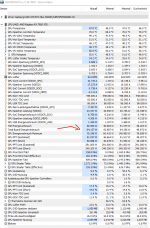

Mit dem zweiten Radeon-Treiber für die RX 7900 XT(X) behebt AMD zumindest einen Teil der Probleme mit zu hoher Leistungsaufnahme.

Bitte beachten Sie: Der Kommentarbereich wird gemäß der Forenregeln moderiert. Allgemeine Fragen und Kritik zu Online-Artikeln von PC Games Hardware sind im Feedback-Unterforum zu veröffentlichen und nicht im Kommentarthread zu einer News. Dort werden sie ohne Nachfragen entfernt.

Zurück zum Artikel: Radeon RX 7900 XT(X): Neues Treiber-Update reduziert teilweise hohen Stromverbrauch

Mit dem zweiten Radeon-Treiber für die RX 7900 XT(X) behebt AMD zumindest einen Teil der Probleme mit zu hoher Leistungsaufnahme.

Bitte beachten Sie: Der Kommentarbereich wird gemäß der Forenregeln moderiert. Allgemeine Fragen und Kritik zu Online-Artikeln von PC Games Hardware sind im Feedback-Unterforum zu veröffentlichen und nicht im Kommentarthread zu einer News. Dort werden sie ohne Nachfragen entfernt.

Zurück zum Artikel: Radeon RX 7900 XT(X): Neues Treiber-Update reduziert teilweise hohen Stromverbrauch