Jetzt ist Ihre Meinung gefragt zu Radeon RX 7000: Block-Diagramme zu Navi 31, 32 und 33 veröffentlicht

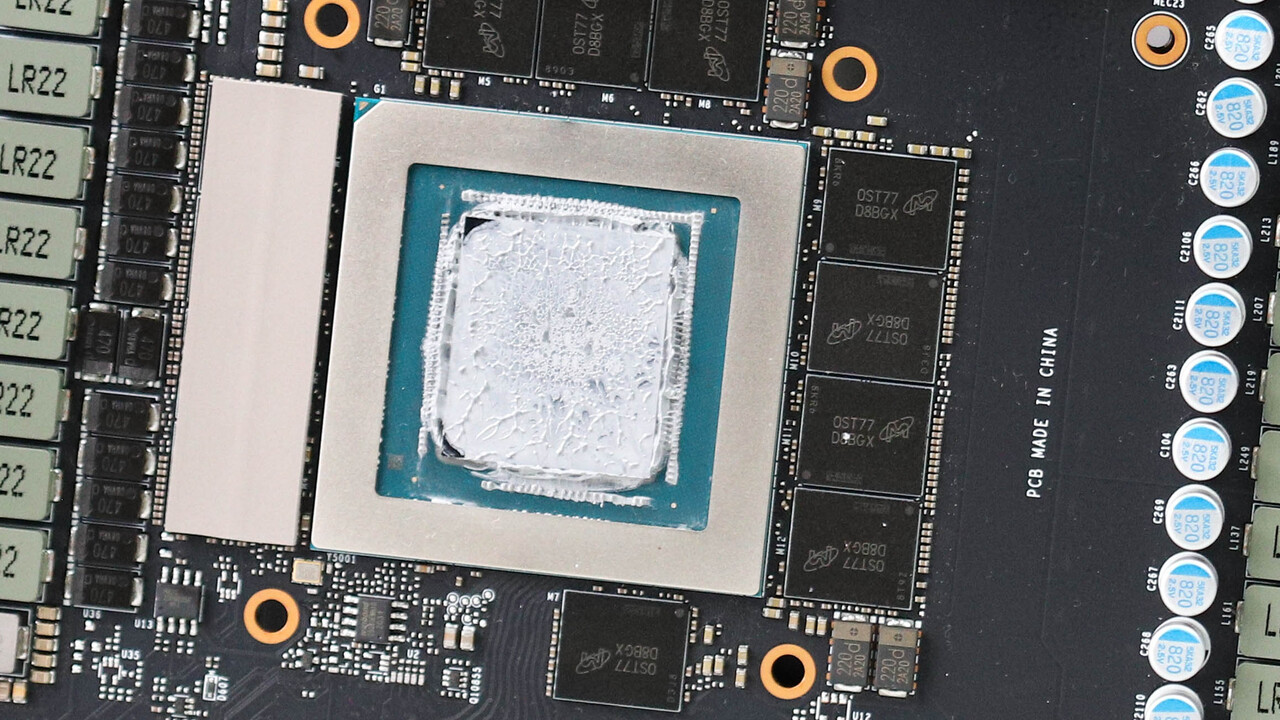

Ein Twitter-Nutzer hat Block-Diagramme für die kommenden Radeon-GPUs Navi 31, Navi 32 und Navi 33 veröffentlicht. Als Grundlage dienten ihm die schon länger durchs Netz schwirrenden (mutmaßlichen) Spezifikationen der Radeon-RX-7000-Serie, die sich teilweise aus Multi-Die-GPUs zusammensetzen soll.

Bitte beachten Sie: Der Kommentarbereich wird gemäß der Forenregeln moderiert. Allgemeine Fragen und Kritik zu Online-Artikeln von PC Games Hardware sind im Feedback-Unterforum zu veröffentlichen und nicht im Kommentarthread zu einer News. Dort werden sie ohne Nachfragen entfernt.

Zurück zum Artikel: Radeon RX 7000: Block-Diagramme zu Navi 31, 32 und 33 veröffentlicht

Zurück zum Artikel: Radeon RX 7000: Block-Diagramme zu Navi 31, 32 und 33 veröffentlicht

Ein Twitter-Nutzer hat Block-Diagramme für die kommenden Radeon-GPUs Navi 31, Navi 32 und Navi 33 veröffentlicht. Als Grundlage dienten ihm die schon länger durchs Netz schwirrenden (mutmaßlichen) Spezifikationen der Radeon-RX-7000-Serie, die sich teilweise aus Multi-Die-GPUs zusammensetzen soll.

Bitte beachten Sie: Der Kommentarbereich wird gemäß der Forenregeln moderiert. Allgemeine Fragen und Kritik zu Online-Artikeln von PC Games Hardware sind im Feedback-Unterforum zu veröffentlichen und nicht im Kommentarthread zu einer News. Dort werden sie ohne Nachfragen entfernt.