Periswoop

Komplett-PC-Käufer(in)

Ich arbeite aktuell an einem Spiel in der Unity-Engine und nach jedem Code-Change muss ich ca. ~15-20s warten bis es zum Testen ready ist. Diese Wartezeit würde ich gerne verkürzen.

Da meine CPU recht alt ist (Ryzen 5 1600X) wollte ich auf die Ryzen 9 7950X wechseln.

Mit der Ankündigung der Ryzen 9 7950X3D mit mehr Cache bin ich aber aktuell am überlegen noch ein wenig zu warten.

Kennt sich vielleicht jemand mit dieser Thematik aus, oder hat in die Richtung schon Erfahrungen machen können?

Da meine CPU recht alt ist (Ryzen 5 1600X) wollte ich auf die Ryzen 9 7950X wechseln.

Mit der Ankündigung der Ryzen 9 7950X3D mit mehr Cache bin ich aber aktuell am überlegen noch ein wenig zu warten.

Kennt sich vielleicht jemand mit dieser Thematik aus, oder hat in die Richtung schon Erfahrungen machen können?

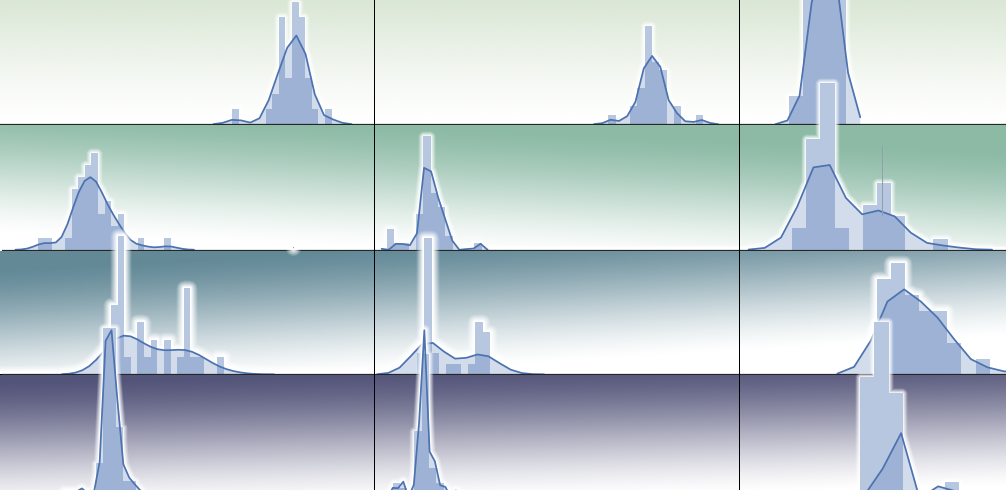

| Ryzen 9 7950X | Ryzen 9 7950X3D | |

| Basis-Takt | 4,50 GHz | 4,20 GHz |

| Turbo (1 Core) | 5,70 GHz | 5,70 GHz |

| Turbo (All Cores) | 5,20 GHz | 5,00 GHz |

| L3 Cache | 64 MB | 128 MB |

.gif)

Da bei einem Spiel die CPU ja auf einen einzelnen Frame jeweils hinarbeitet, hört sich das auch logisch an.

Da bei einem Spiel die CPU ja auf einen einzelnen Frame jeweils hinarbeitet, hört sich das auch logisch an.

Das Team um Unity weiß auch um die Problematik und sie haben auch ne Initiative gestartet um diese Zeit runterzudrücken. Vllt ist es mit den neueren Unity Versionen auch schon besser geworden, bin aktuell noch auf 2021.3.

Das Team um Unity weiß auch um die Problematik und sie haben auch ne Initiative gestartet um diese Zeit runterzudrücken. Vllt ist es mit den neueren Unity Versionen auch schon besser geworden, bin aktuell noch auf 2021.3.