Wie kommst du auf so einige unsinnge Aussage "nichts geholfen"? Schon mal gesehen welch' brachiale Leistung die 4090 abliefert? Schon mal bemerkt wie viele Shader hier parallel werkeln? Glaubst du allen Ernstes diese Leistung bzw. konkret den Durchsatz auf den Shadern könnte nur der OC-GDDR6 *) gewährleisten? Selbstredend nicht und der deutlich vergrößerte Cache wird genau das leisten wofür er implementiert wurde, nämlich nicht gezwungen zu sein das SI weiter verbreitern zu müssen für die deutlich erhöhte Anzahl an Shadern, sondern bei 384 Bit bleiben zu können, weil es zunehmend unwirtschaftlicher wird ein nochmals breiteres SI mit GDDR zu implementieren. Technisch wäre natürlich noch so manches möglich, aber am Ende geht es hier selbstredend auch primär um die Marge und nicht etwa darum ein paar Gamern ein Lächeln ins Gesicht zu zaubern, denn schlussendlich will man hier Geld verdienen.[...]

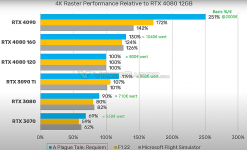

Wir wissen Nvidia hat den L2 Cache massiv von 6MB auf 72GB erhöht, aber das scheint nichts geholfen zu haben.

Wir nehmen zur Kenntnis, dass der GDDDRX6 Speicher im Wesentlichen der gleiche ist, vielleicht sehen wir hier das Limit. Wir würden ja auch kein GDDRX4 auf eine 3080 schnallen und erwarten, dass die 100% ihrer Leistung liefert. Vielleicht sehen wir hier das Limit von GDDRX6.

[...]

Entsprechend wurde der Cache derart dimensioniert, dass der das gesetzte Ziel bestmöglich unterstützt und sich möglichst gut bzgl. Kosten und Nutzen in die Gesamtbilanz einreiht und das ganze wird noch flankiert mit ein wenig schnellerem Micron-Speicher, weil der grundsätzlich zur Verfügung steht, da Micron seine Fertigung optimiert hat. Der Cache liefert genau das was er soll und hilft zweifellos.

*) Randbemerkung: Genaugenommen ist die Bezeichnung "GDDR6X" falsch, da es keinen JEDEC-Standard dieser Art gibt und es sich bei dem OC-Speicher von Micron mit PAM4-Signalisierung um eine proprietäre Entwicklung handelt.

Zu nVidia's "Rückzieher". Letzten Endes ging es nur darum offensichtlich einen deutlichen Preisnachlass vermeiden zu können. Der Chip in möglicherweise der gleichen Ausbaustufe wird so oder so kommen und schlussendlich spielt der Name auch überhaupt keine Rolle, da dieses Leistungssegment selbstredend auch belegt werden will. Einzig der Preis wollte dem allgemeinen Empfinden nach nicht so ganz zur dargeboteten Leistung passen, sodass man hier nun anpasst.

Letzten Endes weiß man aber auch noch nicht mal so genau was der tatsächlich Grund ist, denn das Gejammer und Gemecker im Netz dürfte nicht unerwartet kommen und es erscheint unwahrscheinlich, dass nVidia hier nicht drauf vorbereitet gewesen wäre. Vielleicht hat sich ja zwischenzeitlich auch die Informationslage zum Portfolioaufbau des Konkurrenten verdichtet und man sah nun keine Möglichkeit mehr ein derartig dimensioniertes Produkt für einen solchen Preis im Markt zu platzieren? (Letzten Endes ist das immer ein Wechselspiel der diversen Marktteilnehmer. Als Marktführer kann nVidia natürlich einen Bonus aufschlagen, unbeschränkt überhöhte Preise würde ihnen der Markt aber dennoch nicht abnehmen.)

Anmerkung am Rande, weil ich vorhin irgendwo die Verwunderung/Frage gelesen hatte: Die rel. große Lücke zwischen der großen 4080 und der 4090 wird früher oder später von einer 4080 Ti geschlossen werden, das ist offensichtlich.

Entweder, weil man schon eher früher was zur konkreten Anpassung an AMDs oberes, dann vollständig bekanntes RNDA3-Portfolio benötigt oder später, wenn es Zeit für einen Refresh wird im 2HJ23 um die Verkäufe für das zweite Jahr dieser Generation noch mal anzukurbeln. Business as usual.

Zuletzt bearbeitet: