seahawk

Lötkolbengott/-göttin

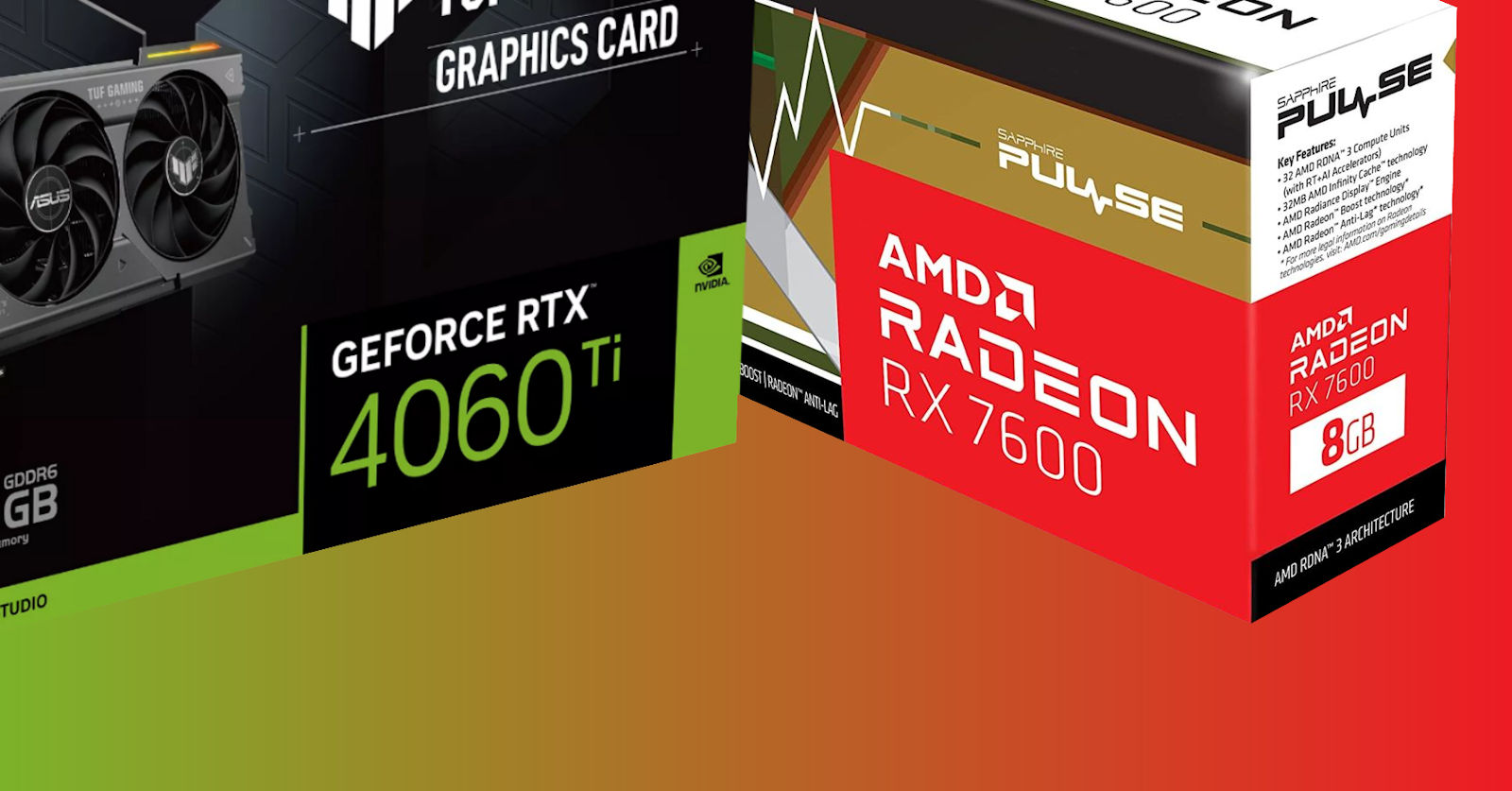

Die ASUS ist im Quiet BIOS sehr leise.Ich meinte von der MSI Gaming X. Dass es generell dual fan gibt weiß ich. Aber gut muss ich mal schauen, was sonst noch gut ist.

Die KFA ist nice aber mit 336mm auch zu gerade so passgenau. Ich werde mir lieber was kleineres gönnen. Ohnehin warte ich jetzt ersmal noch etwas ab. Aber Danke dir