Jetzt ist Ihre Meinung gefragt zu Intel Xe DG1 SDV: Teardown gibt Auskunft über die Hardware

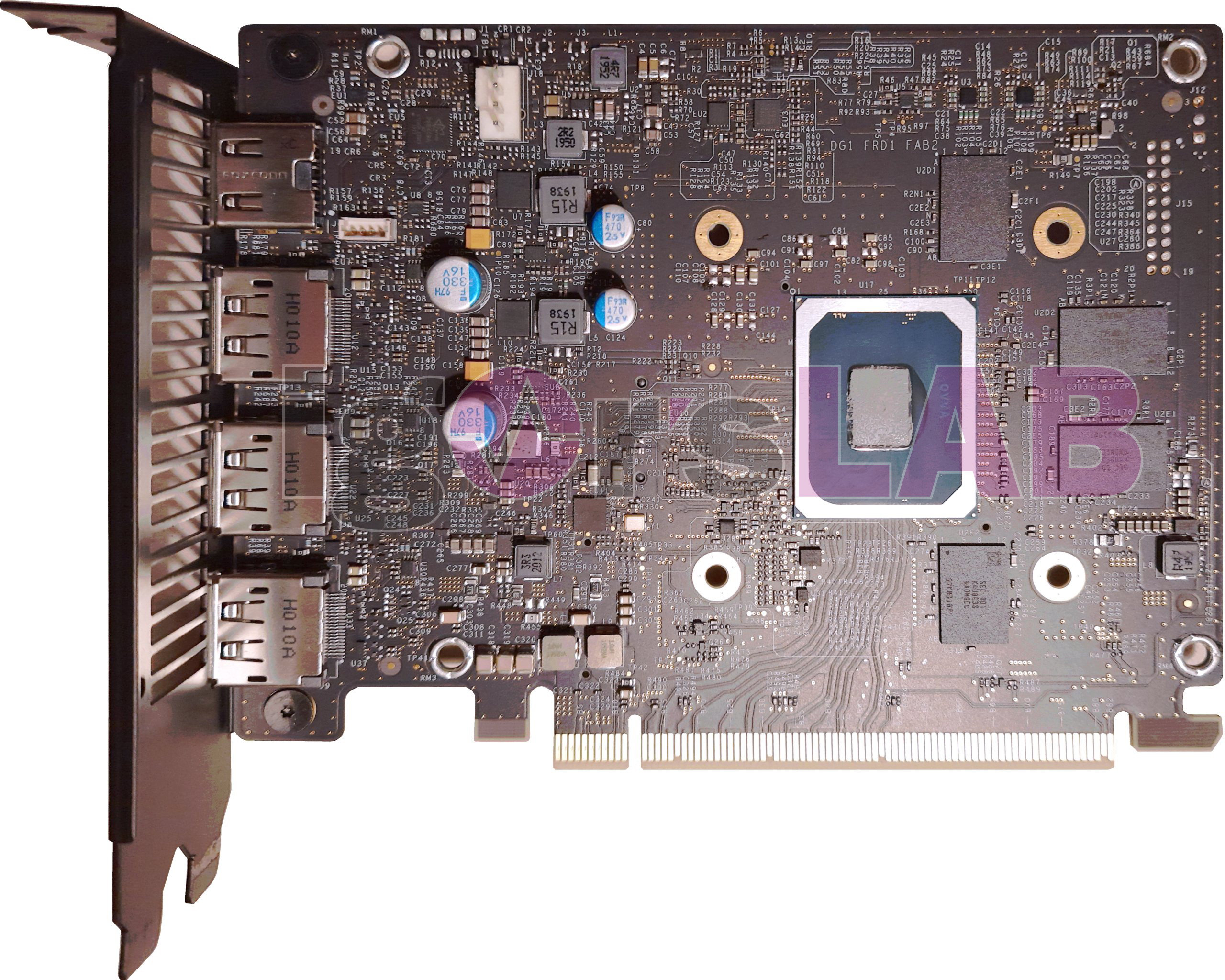

Igor Wallossek von Igor's Lab hat die Intel Xe DG1 SDV einem Teardown unterzogen und dabei interessante Hardware-Details herausgefunden. Der Versuch, die Grafikkarte einem synthetischen Benchmark zu unterziehen, ist jedoch gescheitert. Das SDV-Modell richtet sich in erster Linie an Entwickler, die ihre Software auf Xe-GPUs ausrichten möchten.

Bitte beachten Sie: Der Kommentarbereich wird gemäß der Forenregeln moderiert. Allgemeine Fragen und Kritik zu Online-Artikeln von PC Games Hardware sind im Feedback-Unterforum zu veröffentlichen und nicht im Kommentarthread zu einer News. Dort werden sie ohne Nachfragen entfernt.

Zurück zum Artikel: Intel Xe DG1 SDV: Teardown gibt Auskunft über die Hardware

Zurück zum Artikel: Intel Xe DG1 SDV: Teardown gibt Auskunft über die Hardware

Igor Wallossek von Igor's Lab hat die Intel Xe DG1 SDV einem Teardown unterzogen und dabei interessante Hardware-Details herausgefunden. Der Versuch, die Grafikkarte einem synthetischen Benchmark zu unterziehen, ist jedoch gescheitert. Das SDV-Modell richtet sich in erster Linie an Entwickler, die ihre Software auf Xe-GPUs ausrichten möchten.

Bitte beachten Sie: Der Kommentarbereich wird gemäß der Forenregeln moderiert. Allgemeine Fragen und Kritik zu Online-Artikeln von PC Games Hardware sind im Feedback-Unterforum zu veröffentlichen und nicht im Kommentarthread zu einer News. Dort werden sie ohne Nachfragen entfernt.

Rampage war noch nicht in diesem Zustand, war aber zum Zeitpunkt der Pleite auch noch mindestens ein Jahr von dem Punkt entfernt, an dem man ihn außer Haus gegeben hätte – DG1 ist dagegen ein kommerziell vertriebenes Produkt. Das muss voll funktionsfähig und stabil sein, in diesem konkreten Fall aber leider auch laut Hersteller nur unter bestimmten (nicht vollständig bekannten) Bedingungen.

Rampage war noch nicht in diesem Zustand, war aber zum Zeitpunkt der Pleite auch noch mindestens ein Jahr von dem Punkt entfernt, an dem man ihn außer Haus gegeben hätte – DG1 ist dagegen ein kommerziell vertriebenes Produkt. Das muss voll funktionsfähig und stabil sein, in diesem konkreten Fall aber leider auch laut Hersteller nur unter bestimmten (nicht vollständig bekannten) Bedingungen.