Jetzt ist Ihre Meinung gefragt zu Geforce RTX 4000: Warum DLSS 3 so wichtig für Nvidia ist - eine Analyse

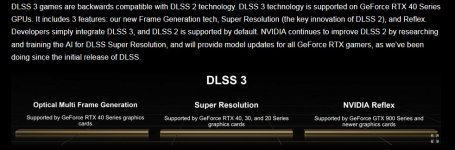

Nvidia setzt bei RTX 4090 und Co. vor allem auf Raytracing und DLSS 3. Dafür braucht es aber entsprechende Spiele, was für Nvidia eine Herausforderung ist.

Bitte beachten Sie: Der Kommentarbereich wird gemäß der Forenregeln moderiert. Allgemeine Fragen und Kritik zu Online-Artikeln von PC Games Hardware sind im Feedback-Unterforum zu veröffentlichen und nicht im Kommentarthread zu einer News. Dort werden sie ohne Nachfragen entfernt.

Zurück zum Artikel: Geforce RTX 4000: Warum DLSS 3 so wichtig für Nvidia ist - eine Analyse

Nvidia setzt bei RTX 4090 und Co. vor allem auf Raytracing und DLSS 3. Dafür braucht es aber entsprechende Spiele, was für Nvidia eine Herausforderung ist.

Bitte beachten Sie: Der Kommentarbereich wird gemäß der Forenregeln moderiert. Allgemeine Fragen und Kritik zu Online-Artikeln von PC Games Hardware sind im Feedback-Unterforum zu veröffentlichen und nicht im Kommentarthread zu einer News. Dort werden sie ohne Nachfragen entfernt.

Zurück zum Artikel: Geforce RTX 4000: Warum DLSS 3 so wichtig für Nvidia ist - eine Analyse

.gif)