I

IICARUS

Guest

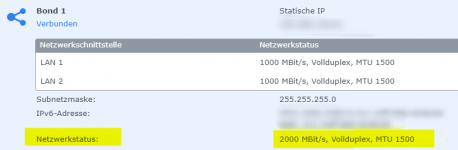

Warum soll diese nicht ansteigen? Mit 2000 MBit/s, was ich mit meiner NAS erreiche, sind theoretisch 250 MB/s möglich.Und, weil es hier ja so schon gesagt wurde, weil aber falsch: Mit Linkaggregation steigt die theoretische Bandbeite aber NICHT die Geschwindigkeit eines Datentransfers!

In meinem Fall kann zwar die Switch mit solch einer Geschwindigkeit Daten mit der NAS austauschen, aber da die Rechner mit der Switch weiterhin mit nur 1G angebunden sind, wird ja keine höhere Geschwindigkeit möglich sein.

Natürlich wird damit auch eine Ausfallsicherheit hergestellt, sollte eine der Datenverbindung mal ausfallen.

In meinem Fall habe ich aber trotzdem die Switch auf diese Weise verbunden, mit der Hoffnung dazu, zumindest die Datenverbindung von der Switch und der NAT, auch mit Zugriff mehrerer Rechner noch besser aufrecht zu halten. Denn die Switch ist bei uns der Zentralpunkt, wovon es dann erst überall weiter geht. Die Rechner gelangen daher auch über die Switch zum Router, sodass der Router auch direkt mit der Switch verbunden ist.

Falls ich da einen Denkfehler haben sollte, kannst du mich gerne dazu aufklären und nicht einfach unbegründet schreiben, dass es falsch wäre. Denn in solch einem Fall möchte ich auch gerne verstehen können, wieso es nicht geht!