Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

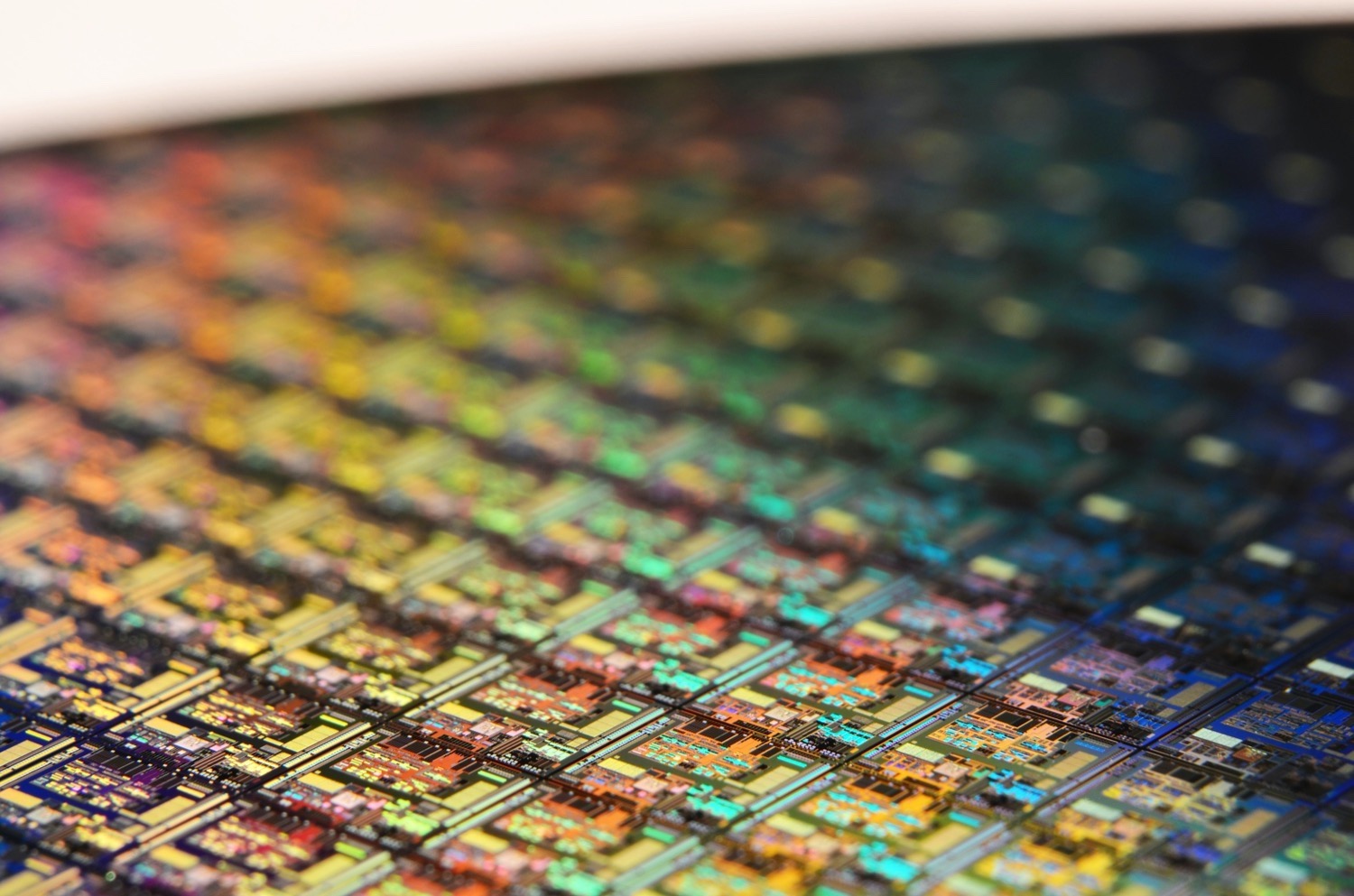

Nvidia forscht an Multi-Chip-Modulen für Grafikkarten

- Ersteller PCGH-Redaktion

- Erstellt am

G

Gast1655586602

Guest

AW: Nvidia forscht an Multi-Chip-Modulen für Grafikkarten

Das ist scheinbar der Plan!

MCM wird nur als Übergangslösung dienen bis neuartige Fertigungstechniken bewährt und verfügbar sind. Moore's Law kann bei bisherigen Bedingungen nicht mehr lange gelten. Die Fertigung stößt einfach an ihre physikalischen Grenzen.

Ich denke MCM wird gut 5-10 Jahre nach Erstrelease als Zwischenlösung zu gebrauchen sein. Danach ist die Technik eh schon Lichtjahre weiter.

Das dürfte am geringeren Takt und der steigenden benötigten Bandbreite liegen. Es gibt bei diesen ersten Prototypen / Konzeptmodellen sicher noch unendlich viele Flaschenhälse, weshalb die Leistung nicht linear ansteigen kann.

Es ist hierbei die Frage wie gut die Kommunikation innerhalb der Architektur arbeitet. Im Multiplexszenario steigen die Anforderungen mit jeder neu angeflanchten Teil-GPU massivst an.

Der Scheduler müsste wohl auch stark überarbeitet werden. Für das fertige Produkt müsse man die Verhältnisse sehr genau anpassen, was bei dieser Studie sicher nicht passiert ist. Sie is wohl nur ein absolutes Grobkonzept um das potential aufzuzeigen.

Ein monolitischer Chip würde auch nicht endlos skalieren. Das Ergebnis kommt sicher auf die individuelle Konfiguration an. Primär dürfte MCM eher eine Technik zur Kostenreduzierung und Umgehung von Fertigungslimits sein. Um die eigentliche Leistung müssen sich dann die Ingenieure in der Entwicklung kümmern.

Im Übrigen ist das Nvidia-Konzept, genau wie AMDs Infinity Fabric, ganz sicher keine Lösung für das Skalierungsproblem. Langfristig müssen sich die Hersteller einfach was anderes einfallen lassen und werden sie sicher auch tun. Das hier wäre nur ne Übergangslösung. Entweder geht man weg vom Silizium oder die Chips werden dreidimensional, oder... Möglichkeiten gibt es wohl einige, ist halt alles nur nicht marktreif.

Das ist scheinbar der Plan!

MCM wird nur als Übergangslösung dienen bis neuartige Fertigungstechniken bewährt und verfügbar sind. Moore's Law kann bei bisherigen Bedingungen nicht mehr lange gelten. Die Fertigung stößt einfach an ihre physikalischen Grenzen.

Ich denke MCM wird gut 5-10 Jahre nach Erstrelease als Zwischenlösung zu gebrauchen sein. Danach ist die Technik eh schon Lichtjahre weiter.

Wenn 4x64 = 256 SMs gerade mal 46% schneller sind, als 128 SMs sieht es mit der Skalierung aber auch noch sehr schlecht aus.

Das dürfte am geringeren Takt und der steigenden benötigten Bandbreite liegen. Es gibt bei diesen ersten Prototypen / Konzeptmodellen sicher noch unendlich viele Flaschenhälse, weshalb die Leistung nicht linear ansteigen kann.

Es ist hierbei die Frage wie gut die Kommunikation innerhalb der Architektur arbeitet. Im Multiplexszenario steigen die Anforderungen mit jeder neu angeflanchten Teil-GPU massivst an.

Der Scheduler müsste wohl auch stark überarbeitet werden. Für das fertige Produkt müsse man die Verhältnisse sehr genau anpassen, was bei dieser Studie sicher nicht passiert ist. Sie is wohl nur ein absolutes Grobkonzept um das potential aufzuzeigen.

Ein monolitischer Chip würde auch nicht endlos skalieren. Das Ergebnis kommt sicher auf die individuelle Konfiguration an. Primär dürfte MCM eher eine Technik zur Kostenreduzierung und Umgehung von Fertigungslimits sein. Um die eigentliche Leistung müssen sich dann die Ingenieure in der Entwicklung kümmern.

Poor_Volta

Gesperrt

AW: Nvidia forscht an Multi-Chip-Modulen für Grafikkarten

Mit einem SI-Interposer würde das schon besser skalieren, da kann man die einzelnen Dice nochmal um den Faktor 1.000 breitet miteinander verbinden.

Mit einem SI-Interposer würde das schon besser skalieren, da kann man die einzelnen Dice nochmal um den Faktor 1.000 breitet miteinander verbinden.

AW: Nvidia forscht an Multi-Chip-Modulen für Grafikkarten

und weiter? ist ja nicht so, als das nvidia keinen interconnect hätte. entwicklungsrückstand hat nvidia zumindest auf dem gebiet nicht .

.

Hust Hust

Infinity Fabric

Hust

und weiter? ist ja nicht so, als das nvidia keinen interconnect hätte. entwicklungsrückstand hat nvidia zumindest auf dem gebiet nicht

.

.JTRch

Software-Overclocker(in)

AW: Nvidia forscht an Multi-Chip-Modulen für Grafikkarten

Meines Wissens sind nicht mal Mikroruckler das Hauptproblem, sondern die Synchronisation der Frame-Times der beiden GPUs und damit oft zunichte machende Latenz. Oft bei meinem SLI erlebt, dass sich 60 FPS wie 30 FPS angefühlt haben.

Meines Wissens sind nicht mal Mikroruckler das Hauptproblem, sondern die Synchronisation der Frame-Times der beiden GPUs und damit oft zunichte machende Latenz. Oft bei meinem SLI erlebt, dass sich 60 FPS wie 30 FPS angefühlt haben.

Edelhamster

BIOS-Overclocker(in)

AW: Nvidia forscht an Multi-Chip-Modulen für Grafikkarten

Wollte meine eigenen Erfahrungen im Bereich Multi-GPU machen und habe mich dann vor zwei Jahren für den Versuch mit 2 x FuryX entschieden.

Die Leistung an sich macht Spaß, aber man muss bereit sein immer etwas Feintuning zu investieren. Nicht immer funktioniert alles auf Anhieb – deutliches Potential hat zuletzt Multi-GPU unter Win 10 mit DX12 gezeigt.

Die Implementierung von Crossfire/Multi-GPU in AotS, RotTR oder Prey ist da beispielsweise allererste Sahne.

Mal sehen was kommt, AMD hat nach Fiji bei Vega nun ja schon auf einer Seite des Chips Platz gemacht und die HBM-Stacks auf einer Längsseite untergebracht. Da könnte doch direkt über den Interposer ein zweiter Chip angebunden werden, oder?^^

Bin nach meinen eigenen Erfahrungen in jedem Fall kein Gegner von MultiGPU. Wenn es richtig implementiert ist geht damit ganz schön die Post ab. Ich hoffe sehr, dass die Entwicklung in dem Bereich weiter voran geht.

Wollte meine eigenen Erfahrungen im Bereich Multi-GPU machen und habe mich dann vor zwei Jahren für den Versuch mit 2 x FuryX entschieden.

Die Leistung an sich macht Spaß, aber man muss bereit sein immer etwas Feintuning zu investieren. Nicht immer funktioniert alles auf Anhieb – deutliches Potential hat zuletzt Multi-GPU unter Win 10 mit DX12 gezeigt.

Die Implementierung von Crossfire/Multi-GPU in AotS, RotTR oder Prey ist da beispielsweise allererste Sahne.

Mal sehen was kommt, AMD hat nach Fiji bei Vega nun ja schon auf einer Seite des Chips Platz gemacht und die HBM-Stacks auf einer Längsseite untergebracht. Da könnte doch direkt über den Interposer ein zweiter Chip angebunden werden, oder?^^

Bin nach meinen eigenen Erfahrungen in jedem Fall kein Gegner von MultiGPU. Wenn es richtig implementiert ist geht damit ganz schön die Post ab. Ich hoffe sehr, dass die Entwicklung in dem Bereich weiter voran geht.

AW: Nvidia forscht an Multi-Chip-Modulen für Grafikkarten

Synchronisation ist in der tat das nummer eins Problem bei jeder Parallelisierung.

Aber die ansätze für MCM ist ja nicht Zwei GPUs. Sondern eine GPU mit mehreren DIEs.

Oder eben das quasi zusammenfügen von mehreren GPUs zu einer "einzigen".

Meines Wissens sind nicht mal Mikroruckler das Hauptproblem, sondern die Synchronisation der Frame-Times der beiden GPUs und damit oft zunichte machende Latenz. Oft bei meinem SLI erlebt, dass sich 60 FPS wie 30 FPS angefühlt haben.

Synchronisation ist in der tat das nummer eins Problem bei jeder Parallelisierung.

Aber die ansätze für MCM ist ja nicht Zwei GPUs. Sondern eine GPU mit mehreren DIEs.

Oder eben das quasi zusammenfügen von mehreren GPUs zu einer "einzigen".

AW: Nvidia forscht an Multi-Chip-Modulen für Grafikkarten

Es gibt keine Prototypen. Im Paper wird genau erklärt wie diese Simulationen vorgenommen wurden. Es wurde Nvidias in-house Simulator genutzt um theoretische GPUs zu bauen und hat dann Benchmarks auf diesen theoretischen GPUs laufen lassen. Die Durchgeführten Benchmarks haben alle unterschiedliche Skalierungen. Einige lassen nur eine sehr geringe Parallelisierung zu, einige eine hohe und einige eine perfekte wodurch sich eine lineare Skalierung ergibt. Es wurden keine Prototypen gebaut weil man aktuell keinen bauen kann. Die einzelnen MCM Dies sind zu groß. Man geht davon aus das bald Substrat Packages von 77mm Kantenlänge möglich sind was groß genug ist für einen ersten Prototypen. Die Zahlen die angegeben werden sind aktuell denkbare Best-Case-Szenarien. Die 45,5% sind ein gemittelter Wert aus 48 Benchmarks in denen ein theoretischer MCM in 31 Tests schneller (bis zu 3,5x schneller) war, in 9 Tests langsamer (-4,7%) und in den restlichen 10 Tests kein Unterschied.

Das es keine lineare oder bessere Skalierung gibt wird im Paper so erklärt das die Transistoren nicht besser skalieren können und es dadurch Flaschenhälse gibt. Diese lassen sich nicht vermeiden wodurch man bei MCM auf viele kleine Pakete mit weniger SM setzt. Interessanter ist die nächste Simulation wo ein SLI System modelliert wurde aus 2x128SM und auch dort ist die MCM GPU schneller. 51,9% mit aktueller SLI Skalierung und 25,1% mit optimierter SLI Skalierung.

Das Paper klingt nicht danach das man versucht über MCM Kosten zu sparen sondern um die Leistung weiter steigern zu können. Im Paper geht man davon aus das ein einzelner Die mit 128 SM das Limit ist weil danach die Verluste im Vergleich zum Leistungsgewinn zu groß sind. Was für Möglichkeiten bestehen wenn man nicht mehr Leistung aus einer einzelnen GPU holen kann? Man nutzt mehrere GPUs, jedoch gibt es auch dort Flaschenhälse die man durch MCM umgehen will. Durch die vielen, kleinen Dies werden vielleicht die Kosten geringer ausfallen als bei riesen Dies mit 800mm² aber ich denke nicht dass es das Primärziel ist.

...

Das dürfte am geringeren Takt und der steigenden benötigten Bandbreite liegen. Es gibt bei diesen ersten Prototypen / Konzeptmodellen sicher noch unendlich viele Flaschenhälse, weshalb die Leistung nicht linear ansteigen kann.

Es ist hierbei die Frage wie gut die Kommunikation innerhalb der Architektur arbeitet. Im Multiplexszenario steigen die Anforderungen mit jeder neu angeflanchten Teil-GPU massivst an.

Der Scheduler müsste wohl auch stark überarbeitet werden. Für das fertige Produkt müsse man die Verhältnisse sehr genau anpassen, was bei dieser Studie sicher nicht passiert ist. Sie is wohl nur ein absolutes Grobkonzept um das potential aufzuzeigen.

Ein monolitischer Chip würde auch nicht endlos skalieren. Das Ergebnis kommt sicher auf die individuelle Konfiguration an. Primär dürfte MCM eher eine Technik zur Kostenreduzierung und Umgehung von Fertigungslimits sein. Um die eigentliche Leistung müssen sich dann die Ingenieure in der Entwicklung kümmern.

Es gibt keine Prototypen. Im Paper wird genau erklärt wie diese Simulationen vorgenommen wurden. Es wurde Nvidias in-house Simulator genutzt um theoretische GPUs zu bauen und hat dann Benchmarks auf diesen theoretischen GPUs laufen lassen. Die Durchgeführten Benchmarks haben alle unterschiedliche Skalierungen. Einige lassen nur eine sehr geringe Parallelisierung zu, einige eine hohe und einige eine perfekte wodurch sich eine lineare Skalierung ergibt. Es wurden keine Prototypen gebaut weil man aktuell keinen bauen kann. Die einzelnen MCM Dies sind zu groß. Man geht davon aus das bald Substrat Packages von 77mm Kantenlänge möglich sind was groß genug ist für einen ersten Prototypen. Die Zahlen die angegeben werden sind aktuell denkbare Best-Case-Szenarien. Die 45,5% sind ein gemittelter Wert aus 48 Benchmarks in denen ein theoretischer MCM in 31 Tests schneller (bis zu 3,5x schneller) war, in 9 Tests langsamer (-4,7%) und in den restlichen 10 Tests kein Unterschied.

Das es keine lineare oder bessere Skalierung gibt wird im Paper so erklärt das die Transistoren nicht besser skalieren können und es dadurch Flaschenhälse gibt. Diese lassen sich nicht vermeiden wodurch man bei MCM auf viele kleine Pakete mit weniger SM setzt. Interessanter ist die nächste Simulation wo ein SLI System modelliert wurde aus 2x128SM und auch dort ist die MCM GPU schneller. 51,9% mit aktueller SLI Skalierung und 25,1% mit optimierter SLI Skalierung.

Das Paper klingt nicht danach das man versucht über MCM Kosten zu sparen sondern um die Leistung weiter steigern zu können. Im Paper geht man davon aus das ein einzelner Die mit 128 SM das Limit ist weil danach die Verluste im Vergleich zum Leistungsgewinn zu groß sind. Was für Möglichkeiten bestehen wenn man nicht mehr Leistung aus einer einzelnen GPU holen kann? Man nutzt mehrere GPUs, jedoch gibt es auch dort Flaschenhälse die man durch MCM umgehen will. Durch die vielen, kleinen Dies werden vielleicht die Kosten geringer ausfallen als bei riesen Dies mit 800mm² aber ich denke nicht dass es das Primärziel ist.

N

Nebulus07

Guest

n, weil der Fertigungsprozess nicht mehr verkleinert werden kann.

Effizientere Chips im Anmarsch: TSMCs 3 nm-Fertigung soll noch in diesem Jahr starten

Im Gegensatz zu Samsung liegt TSMC offenbar im Zeitplan: Die Serienfertigung von Chips mit Strukturbreiten von 3 Nanometern soll noch in der zweiten Hälfte dieses Jahres starten, und zwar direkt mit einer beträchtlichen Kapazität, ein großer Teil davon wurde bereits von Apple gebucht.

www.notebookcheck.com

www.notebookcheck.com

TSMC, Apple, Working on 2nm R&D, With 3nm Orders Reportedly Going Strong

With 3nm orders reportedly going strong for TSMC, the manufacturer is apparently working with Apple to push 2nm development

UUUUND hier mal eine NEWS von 2017 !!!!

GTC17: NVIDIA sieht sich mit Moores Law am Ende zweier Wege angekommen - Hardwareluxx

NVIDIA sieht Moores Law am Ende zweier Wege angekommen

VON 2017:

Laut NVIDIA hat Morres Law nur noch durch die Parallelisierung in den vergangenen Jahren bestand. Die Instruktion Pipelines wurden immer größer, um die Single-Threaded-Anwendungen zu beschleunigen. Weitere Optimierungen wie Caches-Hirarchien und Instruktionen wurden ebenfalls immer komplexer, um diese Bedürfnisse zu erfüllen.

Experten sind sich einig, durch die Thinfet Technologie sind auch 1nm Transistoren möglich. Auch noch kleiner unter 1nm! Dann ist aber auch mit dem 3D Transistor schluß. 1nm soll 2025-2028 kommen... Was danach kommt, weiß niemand...

Zuletzt bearbeitet von einem Moderator:

1 nm physisch gilt als machbar in Silizium, aber das hat nichts mit einem "1nm"-Node bei TSMC zu tun. Nach dem, was man so hört, dürfte deren "3nm" keine feineren Strukturen als 5 nm enthalten und somit noch Luft für vier-fünf weitere Nodes. Zusätzlich zu den zweien, die bei x86-CPUs noch bis 3 nm anstehen und im Schnitt 2-3 Jahren je Node ist die Entwicklung also bis 2035, mit etwas langsameren Zyklen bis 2040 absehbar. Zum Vergleich: VOR 7 Nodes war 2002 und Intel veröffentlichte gerade den Northwood-Pentium-4 in 130 nm.

DKK007

PCGH-Community-Veteran(in)

Angeblich will Intel auch seine Fertigung umbenennen um nicht mehr ganz so hinterher zu hinken.

Oder war das wie bei VW ein April-Scherz?

In Zeiten wo Verschwörungstheroretiker und Covidioten jeden Quatsch für wahr halten gar nicht so einfach FakeNews von Aprilscherzen und Satire zu unterscheiden.

Oder war das wie bei VW ein April-Scherz?

In Zeiten wo Verschwörungstheroretiker und Covidioten jeden Quatsch für wahr halten gar nicht so einfach FakeNews von Aprilscherzen und Satire zu unterscheiden.

Ähnliche Themen

- Antworten

- 23

- Aufrufe

- 969

- Antworten

- 85

- Aufrufe

- 4K

- Antworten

- 20

- Aufrufe

- 1K

- Antworten

- 19

- Aufrufe

- 2K

- Antworten

- 12

- Aufrufe

- 872