Jo, kannste haben für 3000Euronen,schlag schnell zu bevor es die Chinesen tun😂😂😂 Bevor ich es vergesse, selbstverständlich umgebaut auf einen 3090 chip😇Leute verkauft schnell eure 4090er, vorzugsweise an mich zum Panic-Preis.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

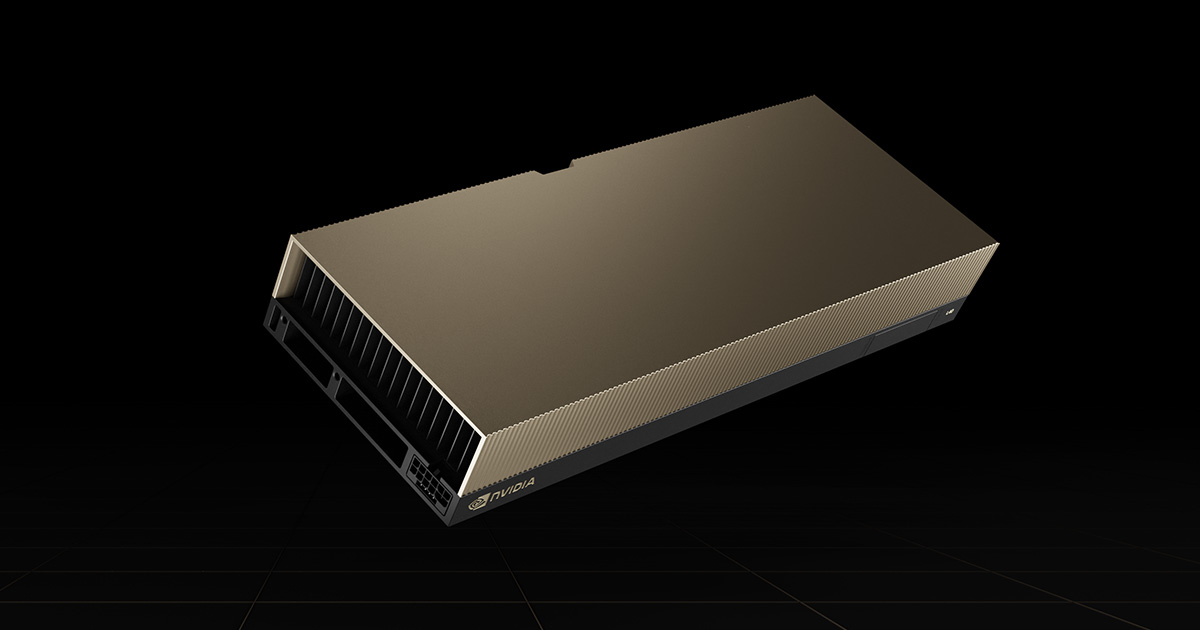

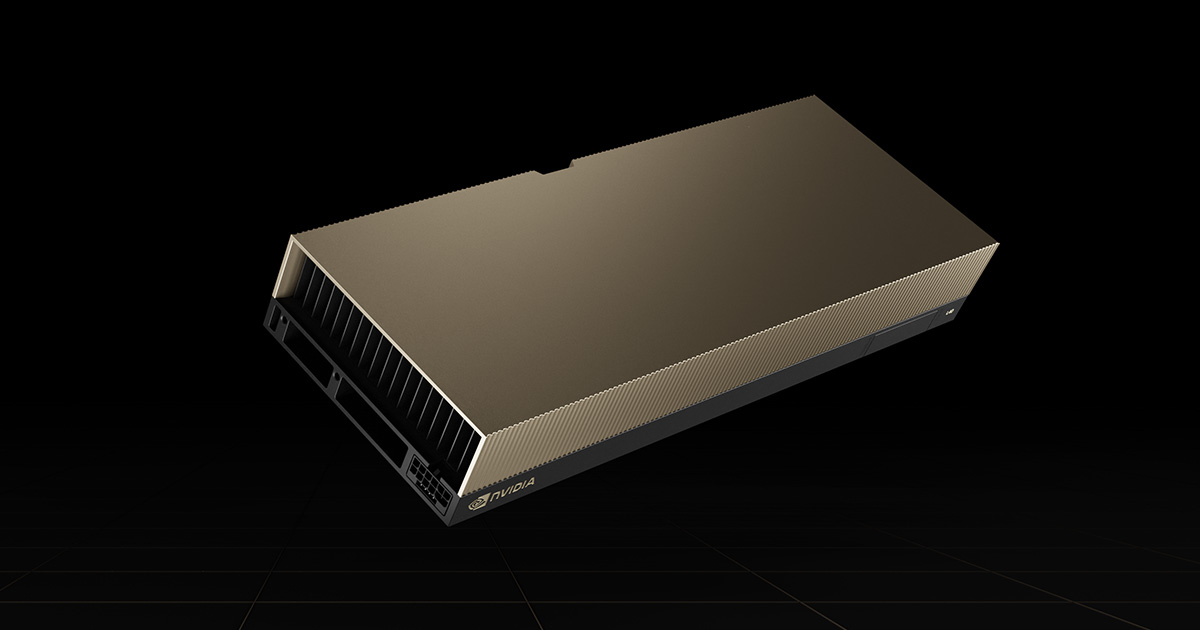

News Nvidia: Next-Gen-GPU Blackwell soll nächste Woche vorgestellt werden

- Ersteller PCGH-Redaktion

- Erstellt am

BachKippe82

Kabelverknoter(in)

Hauptsache im GPU Z wird dann noch 4090 Hyper Plus Edition angezeigt.Jo, kannste haben für 3000Euronen,schlag schnell zu bevor es die Chinesen tun😂😂😂 Bevor ich es vergesse, selbstverständlich umgebaut auf einen 3090 chip😇

ToZo1

Software-Overclocker(in)

Ich bin ja mal auf die technischen Daten gespannt... nur rein platonisch versteht sich.

Meine 4090 reicht mir erstmal in vielerlei Hinsicht im positiven (Rechenleistung, Speichermenge, Lautstärke) wie negativen (Preis, Stromverbrauch, Stecker und die schiere Baugröße, die die anderen PCIe-Slots sinnlos verdeckt und ohne Stützen am eigenen Gewicht zerbrechen würde). Letztlich sah ich in ihr aber die einzige stimmige GPU der 4000er Reihe. Alles andere sind imo zu offensichtlich künstlich auf dem Niveau der 3000er Reihe gehaltene Kastrate.

Aber trotzdem werde ich mir so ein riesiges Monster im technologischen Grenzbereich nicht nochmal kaufen... Hobby hin Hobby her. Ist mir zu extrem geworden das ganze, wo die eigentlich mal so geile Gaming-Nerd-Zeit sowieso dank EA&Co.-Fließbandproduktion schon lange tot ist ...

Meine 4090 reicht mir erstmal in vielerlei Hinsicht im positiven (Rechenleistung, Speichermenge, Lautstärke) wie negativen (Preis, Stromverbrauch, Stecker und die schiere Baugröße, die die anderen PCIe-Slots sinnlos verdeckt und ohne Stützen am eigenen Gewicht zerbrechen würde). Letztlich sah ich in ihr aber die einzige stimmige GPU der 4000er Reihe. Alles andere sind imo zu offensichtlich künstlich auf dem Niveau der 3000er Reihe gehaltene Kastrate.

Aber trotzdem werde ich mir so ein riesiges Monster im technologischen Grenzbereich nicht nochmal kaufen... Hobby hin Hobby her. Ist mir zu extrem geworden das ganze, wo die eigentlich mal so geile Gaming-Nerd-Zeit sowieso dank EA&Co.-Fließbandproduktion schon lange tot ist ...

Showstopper2403

Komplett-PC-Aufrüster(in)

Wozu die next gen kommt nicht vor 2025Leute verkauft schnell eure 4090er, vorzugsweise an mich zum Panic-Preis.

Und wenn es stimmt das die 5080 nur auf 4090 Niveau is dann kriegst du die 4090 immer noch für 1300 bis 1500 verkauft

Je nach Modell

Also nix Panik verkauf... 😉

Zuletzt bearbeitet:

BachKippe82

Kabelverknoter(in)

Da wirste schon Recht haben, aber ich wollte mal bissel Öl ins Feuer kippen. Nvidia generiert ja gerne mal Panikverkaüfe mit geschönten Folien der neuen Generation.

Darauf falle ich erstmal nicht mehr rein, hoffe ich zumindest. Man ist ja gerne mal geneigt neue Hardware zu kaufen. Wenn ich aber sehe wie geschmeidig meine 4080 in uwqhd funktioniert, dann muss ich eigentlich die Ruhe bewahren.

Darauf falle ich erstmal nicht mehr rein, hoffe ich zumindest. Man ist ja gerne mal geneigt neue Hardware zu kaufen. Wenn ich aber sehe wie geschmeidig meine 4080 in uwqhd funktioniert, dann muss ich eigentlich die Ruhe bewahren.

aluis

Komplett-PC-Aufrüster(in)

4090 immer noch für 1300 bis 1500 verkauft

Kein Mensch wird dir in 9 Monaten 1500 Euro für ne 4090 geben. Eine 4080 Super bekommt man jetzt schon unter 1000 Euro in Neu. Und wer 1500 Euro ausgeben will, legt noch ein paar Euro für ne 5090 drauf.

lucky1levin

BIOS-Overclocker(in)

Das sind Träumer.Kein Mensch wird dir in 9 Monaten 1500 Euro für ne 4090 geben.

Shutterfly

Software-Overclocker(in)

Kein Mensch wird dir in 9 Monaten 1500 Euro für ne 4090 geben. Eine 4080 Super bekommt man jetzt schon unter 1000 Euro in Neu. Und wer 1500 Euro ausgeben will, legt noch ein paar Euro für ne 5090 drauf.

Du hoffst natürlich, dass eine 5090 für 1500-2000 Euro zu haben sein wird. Ich wette darauf, dass eine 5090 bei Release über 2200 Euro liegen wird. Spitzenmodelle bei 2500 Euro.

Wieso? Weil Gier unendlich ist und es immer Leute gibt, die es kaufen.

Showstopper2403

Komplett-PC-Aufrüster(in)

Da kannst du gespannt sein wie du willstIch bin ja mal auf die technischen Daten gespannt... nur rein platonisch versteht sich.

Meine 4090 reicht mir erstmal in vielerlei Hinsicht im positiven (Rechenleistung, Speichermenge, Lautstärke) wie negativen (Preis, Stromverbrauch, Stecker und die schiere Baugröße, die die anderen PCIe-Slots sinnlos verdeckt und ohne Stützen am eigenen Gewicht zerbrechen würde). Letztlich sah ich in ihr aber die einzige stimmige GPU der 4000er Reihe. Alles andere sind imo zu offensichtlich künstlich auf dem Niveau der 3000er Reihe gehaltene Kastrate.

Aber trotzdem werde ich mir so ein riesiges Monster im technologischen Grenzbereich nicht nochmal kaufen... Hobby hin Hobby her. Ist mir zu extrem geworden das ganze, wo die eigentlich mal so geile Gaming-Nerd-Zeit sowieso dank EA&Co.-Fließbandproduktion schon lange tot ist ...

Da wird es nur um die Server und ki Karten gehen

Wer lesen kann is klar im VorteilKein Mensch wird dir in 9 Monaten 1500 Euro für ne 4090 geben. Eine 4080 Super bekommt man jetzt schon unter 1000 Euro in Neu. Und wer 1500 Euro ausgeben will, legt noch ein paar Euro für ne 5090 drauf.

Und bin ich froh das du in die Zukunft sehen kannst

Die 3090 bekam ich los für 1100....

Also bitte...

Es kommt drauf an welches Modell man hat etc

Und hab auf Basis der Gerüchte um die 5080 argumentiert denn die wird aufjedenfall weniger vram haben

Nicht jeder zockt mit seiner Karte...

Abgesehen davon wo habe ich gesagt das ich se für diesen Preis verkaufe

Also mal tief durchatmen und die Kirche im Dorf lassen...

Nope man sollte aber erstmal lesen können...Das sind Träumer.

Zuletzt bearbeitet:

ArktosFFM

Freizeitschrauber(in)

Bei einer deutlichen Effizienz-Steigerung hat man immer mit dem Wertverlust des Vorgängers zu kämpfen. Bei einer GPU ist die Effizienz oder der Verbrauch oft entscheidend. Die 3090 bewegt sich gebraucht bei um die 400-600 €. DIe UVP der 3090 lag bei 1.200 €.

Das Wertverlustrisiko sehe ich bei der 4090 im ähnlichen Rahmen wie bei der 3090. Bei der 4090 kann man ebenfalls mind. mit einer Halbierung ihrer Anschaffungskosten rechnen. Hier ist es evtl. ratsam antizyklisch zu kaufen, wenn dieser Trend anhält. Je nachdem wie das FEaturepaket und die Effizienz bei 5xxx aussieht, kann man von einer erheblichen Restwert-Minderung der 4090 Karten ausgehen.

Das ist aber nur meine spekulative Glaskugelsicht, ich kann das nicht preislich fixieren.

Das Wertverlustrisiko sehe ich bei der 4090 im ähnlichen Rahmen wie bei der 3090. Bei der 4090 kann man ebenfalls mind. mit einer Halbierung ihrer Anschaffungskosten rechnen. Hier ist es evtl. ratsam antizyklisch zu kaufen, wenn dieser Trend anhält. Je nachdem wie das FEaturepaket und die Effizienz bei 5xxx aussieht, kann man von einer erheblichen Restwert-Minderung der 4090 Karten ausgehen.

Das ist aber nur meine spekulative Glaskugelsicht, ich kann das nicht preislich fixieren.

Terence-Hill

PC-Selbstbauer(in)

Du hoffst natürlich, dass eine 5090 für 1500-2000 Euro zu haben sein wird. Ich wette darauf, dass eine 5090 bei Release über 2200 Euro liegen wird. Spitzenmodelle bei 2500 Euro.

Wieso? Weil Gier unendlich ist und es immer Leute gibt, die es kaufen.

Ich denke auch, eine 5090 wird bei 2500-3000 Euro/Dollar liegen.

Aus der Sicht von Nvidia, wieso auch nicht.

Die 4090 ging in guten Stückzahlen für 2000€/$ weg.

Die 5090 hat keine Konkurenz.

Die nächste Karte die der 5090 am nächsten kommt wird eine 4090/5080 sein.

2500-3000

theGucky

BIOS-Overclocker(in)

Mit meinem UV, der auch nicht, trotz 4090.Soviel verbraucht mein gesamter Rechner nicht einmal, wenn er an der Kotzgrenze läuft.

Sowohl mit 3000Mhz und 1.1V bei 600W PL, als auch bei 875mv bei 2550Mhz, was je nach Spiel in <250W bis 350W in manchen Fällen ausartet. Aber zwischen 300W und 600W sind nur rund 10% Leistung... da wähle ich lieber die 300W...Wenn sie stabil läuft mit diesen Einstellungen, dann servus!

Und so wünsche ich mir auch die 5090.

Noch weniger Strom ist aber noch besser...

Mein 5800X3D läuft stabil bei 4.45Ghz auf allen Kernen mit CO-30. In Spielen liegt der bei 55-85W.

Beantworte gerne die Noob Frage: Nein. Weil das NVidia seit Jahren schon so macht. Das sollte man eigentlich wissen. Jedesmal macht Nvidia das schon so, erst Server Sparte und Cloud, wo 0,0 Informationen zu Gaming vorgestellt werden. Null. Auch nicht zu GFN.

Ich glaube du hast mich falsch verstanden?

GeForce Now IST doch Rechenzentrum bzw Cloud, deswegen mein Beispiel mit der L40 (AD102).

Auf dem Ding wird die RTX4080 24GB von GFNow "simuliert" (bzw. bis zu zwei 4080 auf einer L40). Und da man GFNow fürs Gaming nutzt = Rechenzentrum-Hardware = Gaming-Hardware.

Zumindest für GeForce Now Kunden. So herum meinte ich das.

Ich war mir nur nicht sicher, ob NV jetzt vielleicht erstmal nur über "reine A.I. Hardware" babbeln will, die nichts außer A.I. Zeugs berechnen kann.

R

raPid-81

Guest

Ich glaube du hast mich falsch verstanden?

GeForce Now IST doch Rechenzentrum bzw Cloud, deswegen mein Beispiel mit der L40 (AD102).

Auf dem Ding wird die RTX4080 24GB von GFNow "simuliert" (bzw. bis zu zwei 4080 auf einer L40). Und da man GFNow fürs Gaming nutzt = Rechenzentrum-Hardware = Gaming-Hardware.

Zumindest für GeForce Now Kunden. So herum meinte ich das.

Ich war mir nur nicht sicher, ob NV jetzt vielleicht erstmal nur über "reine A.I. Hardware" babbeln will, die nichts außer A.I. Zeugs berechnen kann.

Die L40 hat einen AD102.

https://www.techpowerup.com/gpu-specs/l40.c3959

Das ist der Chip der 4090. Die Datacenter GPUs sind aber aktuell "Hopper" Chips, die haben z.B. keine RT Cores, dafür mehr Tensor Cores.

https://www.techpowerup.com/gpu-specs/nvidia-gh100.g1011

Auf der GTC wurden bisher seit längerem nur die richtigen Datacenter Architekturen vorgestellt. Mal schauen was heute so kommt.

Ah, ok, also RTX4090 = abgespeckter AD102. Ich bin bei den Codenamen nicht so drin, und dachte, dass der AD102 auf der L40 was Größeres wäre. Thx für die Info.Das ist der Chip der 4090.

Ich hoffe das es nicht mehr wird als die 450W, bzw das die Effizienz nicht sinkt.

Die 3090 z.b. konnte ich undervolten, aber am Ende blieb sie bei 350W festgenagelt...

Ich nutze meine 4090 halt auf 300W und will eigentlich auch nicht mehr darüber gehen.

Wird sicherlich eine Mischung aus mehr Stromverbrauch, deutlich mehr Leistung und etwas besserer Effizienz. Gerne darf eine 5090 auch 600 Watt sich genehmigen, wenn die Effizienz trotzdem um 10-25% steigt. Am Ende sind die Aufgaben dann einfach schneller erledigt, aber man verbraucht ja insgesamt nicht mehr Strom. Rein für Gaming dauerhaft 600 Watt wäre natürlich dämlich.

Alderson-RApID

Komplett-PC-Aufrüster(in)

Darf er auch. Hat AI fast im Alleingang Salonfähig gemacht.Das wird ne AI only Veranstaltung. Hoffe es gibt wieder Leute die mitzählen wie oft Jensen das Wort AI sagen wird. Ich tippe da mal auf 200+

Mit Sicherheit. Das Dingens ist locker fast das Doppelte wert.Bin dann auch mal auf den Preis dann gespannt, wird bestimmt so an die 2800€ kosten und das wäre dann wohl noch untertrieben.

Alderson-RApID

Komplett-PC-Aufrüster(in)

600 Watt bei besserer Effizienz wären doch in Ordnung.Wird sicherlich eine Mischung aus mehr Stromverbrauch, deutlich mehr Leistung und etwas besserer Effizienz. Gerne darf eine 5090 auch 600 Watt sich genehmigen, wenn die Effizienz trotzdem um 10-25% steigt. Am Ende sind die Aufgaben dann einfach schneller erledigt, aber man verbraucht ja insgesamt nicht mehr Strom. Rein für Gaming dauerhaft 600 Watt wäre natürlich dämlich.

Dann wäre die 5090 um Faktor 3 besser als die 7900XTX, da die 4090 bei 400 Watt schon doppelt so effizient ist.

Anhänge

Ähnliche Themen

- Antworten

- 16

- Aufrufe

- 1K

- Antworten

- 124

- Aufrufe

- 5K

- Antworten

- 42

- Aufrufe

- 2K

- Antworten

- 0

- Aufrufe

- 364

- Antworten

- 38

- Aufrufe

- 2K