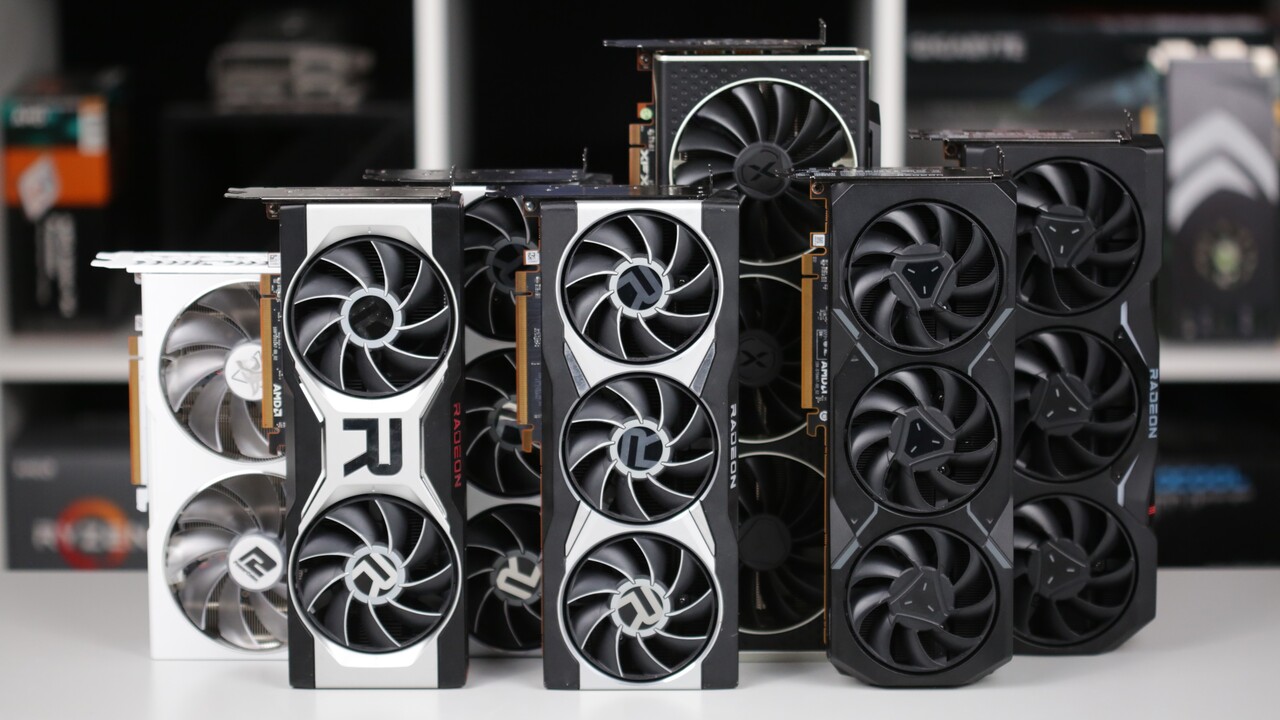

Genau meine Rede.. Ich sehe auch das gute Preisleistungsverhältnis zur Zeit bei dem Zustand nichtDas sehe ich nicht so. Eine RX 6700 XT ist 20% schneller und kostet weniger. Außerdem gibt es Starfield dazu.

Was bringen mir die 16GB, wenn der Chip zu langsam ist ?

Anhang anzeigen 1434773

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

News Im Preisrutsch: Asrock Arc A770 so günstig wie nie

- Ersteller PCGH-Redaktion

- Erstellt am

eXquisite

Lötkolbengott/-göttin

Ja, zwischendurch lag sie mal bei 40 Watt.Du sagtest die 7900XT braucht 100 Watt beim Nichtstun, ich sehe das in Test auf CB ned mal bei 144 HZ, geschweige denn wie ich angegeben habe bei 75 HZ, bitte Quellen, danke

Jetzt hat AMD es wieder verbockt...

Von Monat zu Monat verändert sich je nach Treiber der Powerdraw.

Die letzten Treiber haben eher mehr Verbrauch verursacht.

Aktuell bin ich bei 97 Watt Idle mit der XTX.

Und ja, wenn ich beide Monitore mit 60 Hz betreibe ists besser, aber das ist nicht Sinn der Sache.

Meine Vega 64 verbraucht mit dem gleichen Setup und beiden Monitoren bei 144Hz und 180Hz keine 8 Watt!

Ist halt echt immer noch ne absolute Frechheit.

Quelle bin ich, Screenshot im Anhang.

Anhänge

Hast du free sync an?Ja, zwischendurch lag sie mal bei 40 Watt.

Jetzt hat AMD es wieder verbockt...

Von Monat zu Monat verändert sich je nach Treiber der Powerdraw.

Die letzten Treiber haben eher mehr Verbrauch verursacht.

Aktuell bin ich bei 97 Watt Idle mit der XTX.

Und ja, wenn ich beide Monitore mit 60 Hz betreibe ists besser, aber das ist nicht Sinn der Sache.

Meine Vega 64 verbraucht mit dem gleichen Setup und beiden Monitoren bei 144Hz und 180Hz keine 8 Watt!

Ist halt echt immer noch ne absolute Frechheit.

Quelle bin ich, Screenshot im Anhang.

Nach cb senkt das den Verbrauch im Desktop extrem

Erzwingen im Treiber

eXquisite

Lötkolbengott/-göttin

Wo erzwingen?Hast du free sync an?

Nach cb senkt das den Verbrauch im Desktop extrem

Erzwingen im Treiber

Aber natürlich, alles Free Sync Premium Monitore (der eine mit 180Hz sogar Premium Pro).

Ich hab die Karte ja schon über 6 Monate...

Anfangs lagen wir bei 110 Watt.

Dann bei 100W.

40 Watt -> Karte super instabil.

60 Watt -> Probleme mit Videos auf Zweitmonitor beim Spielen.

80 Watt -> relativ Stabil außer beim OC.

und jetzt wieder bei 97 Watt -> alles läuft.

Keine Ahnung was AMD da veranstaltet.

Und zwischendurch waren es immer mal wieder 80 - 120 Watt.

Jeder Treiber ist (verbrauchstechnisch) ne Wundertüte.

Aber ansonsten bin ich echt zufrieden mit dem Ding, Performance stimmt, bis auf Cyberpunk laufen alle meine Games mit 180 FPS im CPU Limit bzw. mit 144 auf dem UltraWide und ne Heizung brauch ich auch nicht mehr.

Raytracing in z. B. F1 läuft auch super, hätt ich selber nicht mit gerechnet.

Aber ja, wenn man die 100 Watt Idle Verbrauch beim PCGH Forumsbeitrag tippen sieht,

dann nehme ich mir zum YT Video gucken oder PCGH Browsen doch gern mein ThinkPad oder iPad und das ist einfach schade.

War mit der Vega nicht nötig.

Anhänge

Zuletzt bearbeitet:

Wo erzwingen?

Aber natürlich, alles Free Sync Premium Monitore (der eine mit 180Hz sogar Premium Pro).

Ich hab die Karte ja schon über 6 Monate...

Anfangs lagen wir bei 110 Watt.

Dann bei 100W.

40 Watt -> Karte super instabil.

60 Watt -> Probleme mit Videos auf Zweitmonitor beim Spielen.

80 Watt -> relativ Stabil außer beim OC.

und jetzt wieder bei 97 Watt -> alles läuft.

Keine Ahnung was AMD da veranstaltet.

Und zwischendurch waren es immer mal wieder 80 - 120 Watt.

Jeder Treiber ist (verbrauchstechnisch) ne Wundertüte.

Aber ansonsten bin ich echt zufrieden mit dem Ding, Performance stimmt, bis auf Cyberpunk laufen alle meine Games mit 180 FPS im CPU Limit bzw. mit 144 auf dem UltraWide und ne Heizung brauch ich auch nicht mehr.

Raytracing in z. B. F1 läuft auch super, hätt ich selber nicht mit gerechnet.

Aber ja, wenn man die 100 Watt Idle Verbrauch beim PCGH Forumsbeitrag tippen sieht,

dann nehme ich mir zum YT Video gucken oder PCGH Browsen doch gern mein ThinkPad oder iPad und das ist einfach schade.

War mit der Vega nicht nötig.

Grafikkarten-Leistungsaufnahme auf dem Windows-Desktop

Radeon-RX-Grafikkarten verbrauchen bei hohen Bildwiederholfrequenzen viel Strom auf dem Windows-Desktop. Stimmt, aber doch nicht immer.

IguanaGaming

PC-Selbstbauer(in)

die auch kaum schneller als ne A750 ist, mal die 16GB außen vor gelassen, für FullHD eher unnötig zum zocken und vielleicht eher im semi professionellen Bereich von Vorteil

Verruckt-Birdman

Software-Overclocker(in)

Die A770 geht bei 280€ los, dann aber mit 8GB. Auf die 1,3 FPS Unterschied zur RX 6700 kommt es mir nicht an, aber wenn Starfield dabei ist, ist sie durchaus eine Überlegung wert. Brauche auf jeden Fall eine Neue.Das sehe ich nicht so. Eine RX 6700 XT ist 20% schneller und kostet weniger. Außerdem gibt es Starfield dazu.

Was bringen mir die 16GB, wenn der Chip zu langsam ist ?

Anhang anzeigen 1434773

Mazrim_Taim

Volt-Modder(in)

Ich bin ja für jeden Preistip dankbar aber....

irgendwie passt die Überschrift bzw. die daraus erzeugten Erwartungen nicht zu dem gezeigt Schaubild...

irgendwie passt die Überschrift bzw. die daraus erzeugten Erwartungen nicht zu dem gezeigt Schaubild...

Und selbst wenn Intel über die Beta Phase hinaus ist und man da testen darf. Ich würde so eine karte kaufen vor allen weil sie preislich atraktiv ist wäre für die richtung um 300 euro 330 ne echter schnapper dazu 16Gigabyte v-ram und nicht zum zocken vielleicht minecraft alle mal gut genug. Für ne anderes Projekt auf jeden fall besser als die "gurken" von amd oder nvidia die in ihren lanes beschnitten sind und fast das gleiche kosten und nur 8gigabyte videospeicher haben.

So fern sollen sie fallen muss ich schauen das ich die mir ins haus hole das könnte auch in Q1/24 noch passieren wenn die Ki mist nicht bis dahin den markt seinen stempel auf gedrückt hat.

So fern sollen sie fallen muss ich schauen das ich die mir ins haus hole das könnte auch in Q1/24 noch passieren wenn die Ki mist nicht bis dahin den markt seinen stempel auf gedrückt hat.

Zik7

Freizeitschrauber(in)

Stimmt! 278€ für die A770 8GB ist ok, aber die 16GB Variante ist für 360€ einfach zu teuer.Die A770 geht bei 280€ los, dann aber mit 8GB. Auf die 1,3 FPS Unterschied zur RX 6700 kommt es mir nicht an, aber wenn Starfield dabei ist, ist sie durchaus eine Überlegung wert. Brauche auf jeden Fall eine Neue.

Allerdings hat die 6700 2GB mehr, was auch nicht zu verachten ist. Das Gesamtpaket ist bei AMD einfach besser!

Auch die RX 7600 bekommt man mittlerweile ab 249€ inkl. Starfield.

Für die Preise der beiden Arcs bekommt man bei AMD die deutlich bessere Alternative!

Natürlich gibt es die A770 als 8GB Version. PCGH hat sie in den Tests:Es gibt doch die A770 nicht als 8 GB, das ist dann A750 nur Asrock schreibt dazu A770?

Zuletzt bearbeitet:

WardenOfSouls

Kabelverknoter(in)

Die A770 16GB läuft inzwischen wirklich flott und ohne Probleme bei mir. Ich habe echt viel rumgetestet mit der 6700XT und der A770 und inzwischen ist die Intel Karte einen Tick schneller und vor allem die 1% low's sind konstanter. Kann ich natürlich nur auf mein System beziehen. Wenn die 16GB Variante um die 300€ kosten würde wäre es mit Abstand die beste Preis / Leistungs Option über 12GB Vram, wenn sie das nicht jetzt sogar schon ist.

Das lustigste ist, das bedenken was viele noch haben bezüglich der Treiber: Ich hatte einen einzigen Fall wo ich den GPU Treiber mal clean neu machen musste weil damit etwas falsch war.

Bei der 6700XT ist mir das in der selben Zeit mehrfach passiert. Ich würde fast vorsichtig behaupten dass der Intel Treiber deutlich stabiler läuft, wobei ich auch das wieder nur auf mein System beziehen kann als Referenz. Ich habe auch das Gefühl, dass AMD etwas auf Hardware Performance gepusht hat und dabei die Treiber jetzt erst nachzieht. So oder so ist es aber schon sehr schön zu sehen wie sich das entwickelt bei beiden, sowohl Intel als auch AMD.. nur NVIDIA macht mir sorgen im Moment.

Ich bin sehr gespannt wie die nächste Generation aussieht.

Das lustigste ist, das bedenken was viele noch haben bezüglich der Treiber: Ich hatte einen einzigen Fall wo ich den GPU Treiber mal clean neu machen musste weil damit etwas falsch war.

Bei der 6700XT ist mir das in der selben Zeit mehrfach passiert. Ich würde fast vorsichtig behaupten dass der Intel Treiber deutlich stabiler läuft, wobei ich auch das wieder nur auf mein System beziehen kann als Referenz. Ich habe auch das Gefühl, dass AMD etwas auf Hardware Performance gepusht hat und dabei die Treiber jetzt erst nachzieht. So oder so ist es aber schon sehr schön zu sehen wie sich das entwickelt bei beiden, sowohl Intel als auch AMD.. nur NVIDIA macht mir sorgen im Moment.

Ich bin sehr gespannt wie die nächste Generation aussieht.

Verruckt-Birdman

Software-Overclocker(in)

Was ist da denn los?nur NVIDIA macht mir sorgen im Moment.

Ich bin sehr gespannt wie die nächste Generation aussieht.

WardenOfSouls

Kabelverknoter(in)

Bei Nvidia? Man hört ja hier und da Gerüchte, dass dort der Fokus von Gaming Grafikkarten weggeht und komplett auf KI gelegt wird. Außerdem sind viele Entscheidungen beim Design der derzeitigen Generation recht fragwürdig, VRAM Bestückung, Preise etc. Ich habe keine Ahnung ob da irgendwas dran ist. Aber Wettbewerb ist gut für uns Konsumenten also egal ob man AMD, Intel oder Nvidia bevorzugt, jede Konkurrenz ist erstmal gut.Was ist da denn los?

Verruckt-Birdman

Software-Overclocker(in)

Nvidia war immer schon teurer als die Konkurrenz. Man bekommt auch in der Regel leistungsfähigere und sparsamere Produkte dafür und die Treiber und Software sind auch gut. Bei AMD ist mir schon zuviel Gedöns im trägen Programm.Bei Nvidia? Man hört ja hier und da Gerüchte, dass dort der Fokus von Gaming Grafikkarten weggeht und komplett auf KI gelegt wird. Außerdem sind viele Entscheidungen beim Design der derzeitigen Generation recht fragwürdig, VRAM Bestückung, Preise etc. Ich habe keine Ahnung ob da irgendwas dran ist. Aber Wettbewerb ist gut für uns Konsumenten also egal ob man AMD, Intel oder Nvidia bevorzugt, jede Konkurrenz ist erstmal gut.

Ich denke auch nicht, daß sich NV aus dem Gaming Geschäft verabschieden wird. Nur wenn es so weitergeht wie jetzt und die Leute einfach nichts für PC kaufen sondern auf dem Handy irgendwelche ausbeuterischen Kackspiele für Zurückgebliebene zocken, dann wird das Angebot bei allen Herstellern schlechter werden. Die Hardware wird teurer und die Auswahl geringer weil die Zielgruppe dahinschmilzt.

Ja und nein, Kern problem ist Microsoft und AMD selber. Wegen den Treibern. Wenn Microsoft nicht random treiber updates machen würde dann würde das mit aktuellen treibern kein problem dar stellen daduch das es zum teil ältere sind und dazu noch random und man beim neu start fest stellt das alles zu kleine auflösung ist und man alles neu machen muss bevorzuge ich die inoffizielle lösung weil es weniger nervt.Bei AMD ist mir schon zuviel Gedöns im trägen Programm.

Aber das ne programm träge ist ist mir noch nicht aufgefallen nicht der Treiber.

Verruckt-Birdman

Software-Overclocker(in)

Bei mir macht MS keine Treiberupdates.Ja und nein, Kern problem ist Microsoft und AMD selber. Wegen den Treibern. Wenn Microsoft nicht random treiber updates machen würde dann würde das mit aktuellen treibern kein problem dar stellen daduch das es zum teil ältere sind und dazu noch random und man beim neu start fest stellt das alles zu kleine auflösung ist und man alles neu machen muss bevorzuge ich die inoffizielle lösung weil es weniger nervt.

Aber das ne programm träge ist ist mir noch nicht aufgefallen nicht der Treiber.

Ähnliche Themen

- Antworten

- 24

- Aufrufe

- 2K

- Antworten

- 4

- Aufrufe

- 829

- Antworten

- 12

- Aufrufe

- 913

- Antworten

- 13

- Aufrufe

- 1K

- Antworten

- 61

- Aufrufe

- 5K