Außerdem: Selbst ausprobieren und das auch nicht nur in einem Spiel und im Anschluss urteilen. Mir sind in meinen Spielerfahrungen keine eklatanten Mängel aufgefallen. Darüber hinaus werden die Technologien ja immer weiter verbessert.

Dazu braucht man dann erstmal eine Karte die FG kann was ja nun nicht jeder hat. Und gerade um es nicht selbst austesten zu müssen/können dafür sind ja die Test und Reviews gedacht.

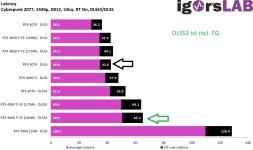

Alle Spiele sind mit RT on

Zur Meiner Erfahrung mit Nvidia FG:

Cyberpunk 2077 (DLSS Quali; 4k ; Pathtracing).

Die Relativ geringe Nativen FPS sorgen dafür das FG sichtbar Artefakte bildet und durch die ca 10ms Extra wird das Spiel nicht gut Spielbar was Latenz angeht. In diesem fall bringt mir DLSS FG also nichts.

Redfall:

FG (native FPS ca 80 ; 4k ; DLSS Quali)

FG funktioniert hier Super die mehr Latenz ist nicht wahrnehmbar (außer in den kurzen CPU limitieren Szenen)

Artefakte sind kaum bis wenig vorhanden.

Warhammer Darktide (4k, DLSS Quali)

Die mehr Latenz ist hier sehr deutlich wahrnehmbar was es für mich Sinnlos macht. Klar das bild sieht flüssige aus, fühlt sich aber nicht so an.

Witcher 3 (DLSS Quali 4k +rt)

Nachdem es in den ersten Patches damit immer zu abstürzen führte war es für mich erstmal uninteressant.

Nun läuft es, leider ist der Mehrwert hier gering da ich mit der 4090 auch ohne FG in allen GPU lastigen Szenarien ein Flüssiges Bild habe.

In den CPU lastigen Szenarien wird die Mehrlatenz mal wieder zum Verhängnis.

Zusammenfassung meinerseits:

Ist Spanned hat aber für mich selten einen Mehrwert. DLSS(ohne FG) hingegen ist nach meiner Meinung eines der besten Features seid Jahren von dem Wunderbaren DLAA brauchen wir garnicht Reden.

Geht mal in Cyberpunk 2077 und Aktiviert bei einer Nativen Auflösung von 4k mal DLAA, meine Güte sieht das Spiel gut aus. (man hat zwar nur noch Cinematische 20 FPS aber irgendwas ist halt immer.

.gif)