astralhorizon

Schraubenverwechsler(in)

Hallo zusammen,

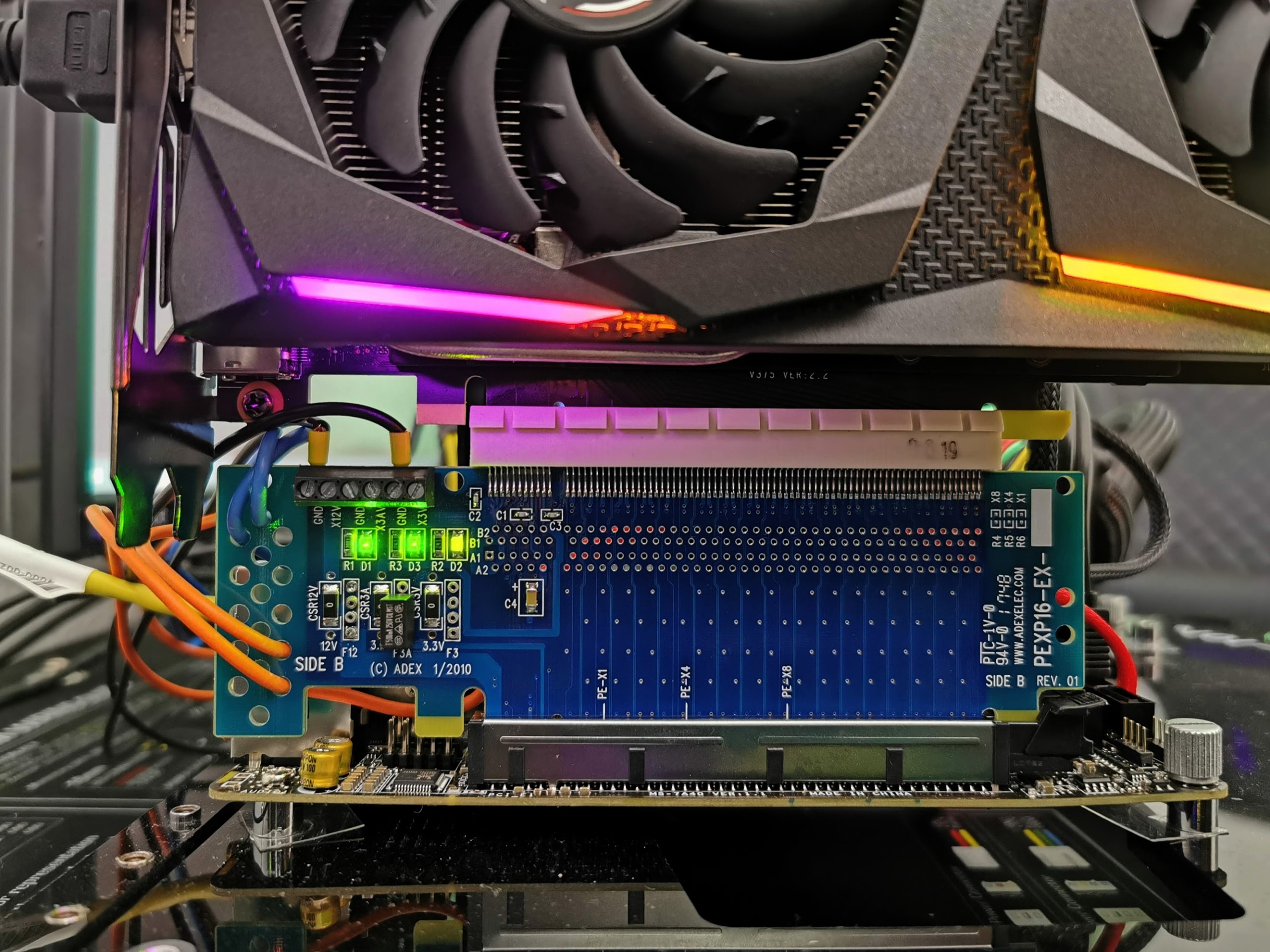

ich habe vor kurzem von einem 400W Netzteil + GTX 1070 auf ein 650W Netzteil + RTX 3070 geupgradet. Die Netzteile sind beide von BeQuiet und in ihrer Effizienz vergleichbar. Dazu laufen ein Ryzen 5600, eine m2-SSD und nur eine HDD.

Die TDP der RTX 3070 liegt höher als die der GTX 1070. Ich spiele allerdings weiterhin Full HD und auf ähnlichen Einstellungen. Jetzt ist die erste Frage, über die ich nachdenke, die ich mir allerdings nicht definitiv selbst beantworten kann:

Habe ich vorher mehr Strom verbraucht, weil die GTX 1070 voll ausgelastet wurde, oder verbrauche ich jetzt weniger, weil die RTX 3070 aufgrund der für sie niedrigen FHD-Auflösung weniger ausgelastet wird?

Versteht ihr, was ich meine? Ich habe die 1070 ja zuvor an ihr Limit getrieben, die RTX 3070 nun aber kaum. Also könnte es doch sein, dass für dieselbe produzierte Leistung die RTX 3070 weniger Strom verbraucht, weil sie über mehr "Leistung pro Energieverbrauch" verfügt.

In Benchmarks und Reviews sieht man vor allem den Idle-Verbrauch und den unter Volllast. Beides trifft ja in meinem Fall auf meine RTX 3070 nicht zu, weshalb mir schwer fällt, die Angelegenheit richtig einzuschätzen.

Zweite Frage:

Vorher kam ich mit einem 400W Netzteil aus, jetzt musste ich sicherheitshalber aufgrund des Upgrades und der Empfehlungen auf 650W upgraden. Aufgrund der oben beschriebenen Umstände werde ich diese 650W aber nur sehr selten auslasten. Ist das Netzteil im von mir genutzten niedrigeren Wattbereich ineffizienter als bspw. ein 500W Netzteil? Ich meine so etwas mal gelesen zu haben. Oder ist das nicht mehr so? Es ist ein Platinum-Netzteil (Straight Power).

Inb4 ich erwarte natürlich keine definitiven Ferndiagnosen; mir geht es eher darum, ob meine Gedanken prinzipiell, d.h. theoretisch, richtig sind.

Vielen Dank an wen auch immer mich aufklärt.

ich habe vor kurzem von einem 400W Netzteil + GTX 1070 auf ein 650W Netzteil + RTX 3070 geupgradet. Die Netzteile sind beide von BeQuiet und in ihrer Effizienz vergleichbar. Dazu laufen ein Ryzen 5600, eine m2-SSD und nur eine HDD.

Die TDP der RTX 3070 liegt höher als die der GTX 1070. Ich spiele allerdings weiterhin Full HD und auf ähnlichen Einstellungen. Jetzt ist die erste Frage, über die ich nachdenke, die ich mir allerdings nicht definitiv selbst beantworten kann:

Habe ich vorher mehr Strom verbraucht, weil die GTX 1070 voll ausgelastet wurde, oder verbrauche ich jetzt weniger, weil die RTX 3070 aufgrund der für sie niedrigen FHD-Auflösung weniger ausgelastet wird?

Versteht ihr, was ich meine? Ich habe die 1070 ja zuvor an ihr Limit getrieben, die RTX 3070 nun aber kaum. Also könnte es doch sein, dass für dieselbe produzierte Leistung die RTX 3070 weniger Strom verbraucht, weil sie über mehr "Leistung pro Energieverbrauch" verfügt.

In Benchmarks und Reviews sieht man vor allem den Idle-Verbrauch und den unter Volllast. Beides trifft ja in meinem Fall auf meine RTX 3070 nicht zu, weshalb mir schwer fällt, die Angelegenheit richtig einzuschätzen.

Zweite Frage:

Vorher kam ich mit einem 400W Netzteil aus, jetzt musste ich sicherheitshalber aufgrund des Upgrades und der Empfehlungen auf 650W upgraden. Aufgrund der oben beschriebenen Umstände werde ich diese 650W aber nur sehr selten auslasten. Ist das Netzteil im von mir genutzten niedrigeren Wattbereich ineffizienter als bspw. ein 500W Netzteil? Ich meine so etwas mal gelesen zu haben. Oder ist das nicht mehr so? Es ist ein Platinum-Netzteil (Straight Power).

Inb4 ich erwarte natürlich keine definitiven Ferndiagnosen; mir geht es eher darum, ob meine Gedanken prinzipiell, d.h. theoretisch, richtig sind.

Vielen Dank an wen auch immer mich aufklärt.

Zuletzt bearbeitet: