Dürfte eine deutliche Fehleinschätzung sein. Hopper wird bereits in 2Q22 vorgestellt und dürfte in Abhängigkeit des Workloads die MI200-Serie absehbar mäßig bis deutlich übertreffen.

Das stimmt, aber diese Fehleinschätzungen sind wir von dir ja auch mittlerweile gewohnt. Ich sehe nicht, dass Nvidia die Mi-Serie deutlich übertreffen wird, da man an den Leistungswerten ja sehen kann, dass die Schwerpunkte auch anders gesetzt werden. Sprich in Bereich A ist der eine besser und in Bereich B wiederum der andere. Und so wird es auch mit Hopper sein.

Zudem, was bei der gesamten Betrachtung bereits unter den Tisch fällt, ist dass AMDs Design 560 W zieht und damit die Perf/Watt längst nicht so hoch ausfallen in Relation zur Konkurrenz, wie die absoluten Zahlen suggerieren. Beispielsweise bei den kolportierten Zahlen zur FP16/BF16-Matrix-Performance ist die A100 trotz weiterhin nur dem N7 immer noch effizienter *), d. h. nVidia würde bereits mit einer simplen Skalierung AMDs Design leicht übertreffen können und man darf annehmen, dass die auch architektonisch noch was drauflegen werden.

Aber auch nur in deinen Cherry Picking Träumen, wieso nimmst du nicht die Werte, wo AMD die rund 5-fache Leistung bietet? Weil dann dein Effizienzmärchen nicht mehr aufgeht? Da ist Nvidia mitnichten effizienter. Zumal N7/N6 doch recht vergleichbar sind und die meiste Effizienz eh über das Design kommt.

Und FP32/64 wo AMD deutlich überlegen ist, interessiert dich auch mal wieder nicht...

Wie oben schon angemerkt, die Eierlegendewollmilchsau gibt es in dem Bereich aktuell nicht und die Hersteller legen den Fokus offensichtlich anders.

Der Konkurrent dürfte hier aus nVidia's Sicht jedoch weniger AMD als vielmehr Intel sein, denn deren Ponte Vecchio (Xe-HPC) lässt AMDs Design deutlich hinter sich und scheint in den anderen Metriken voraussichtlich mindestens vergleichbar leistungsstark zu sein, so gemäß konservativen Schätzungen und das bei nur geringfügig mehr Verbrauch.

Der Konkurrent der noch gar nichts geliefert hat, die vielen tollen Powerpoints mal außen vor. Und auch wenn Nvidia und intel mit ihren Lösungen AMD übertreffen, was man mit neuen Lösungen ja immer sollte! Wo ist das Problem für AMD? Die Mi Karten werden aktuell schon verbaut in Frontier und bis Konkurrenz kommt dauert es noch locker ein halbes Jahr, also ein halbes Jahr in dem man erstmal konkurrenzlos in vielen Bereichen ist. Die Schwarzmalerrei sehe ich hier nicht.

Zudem hat AMD auch den Vorteil der Infinity Fabric, den du mal wieder völlig unterschlägst.

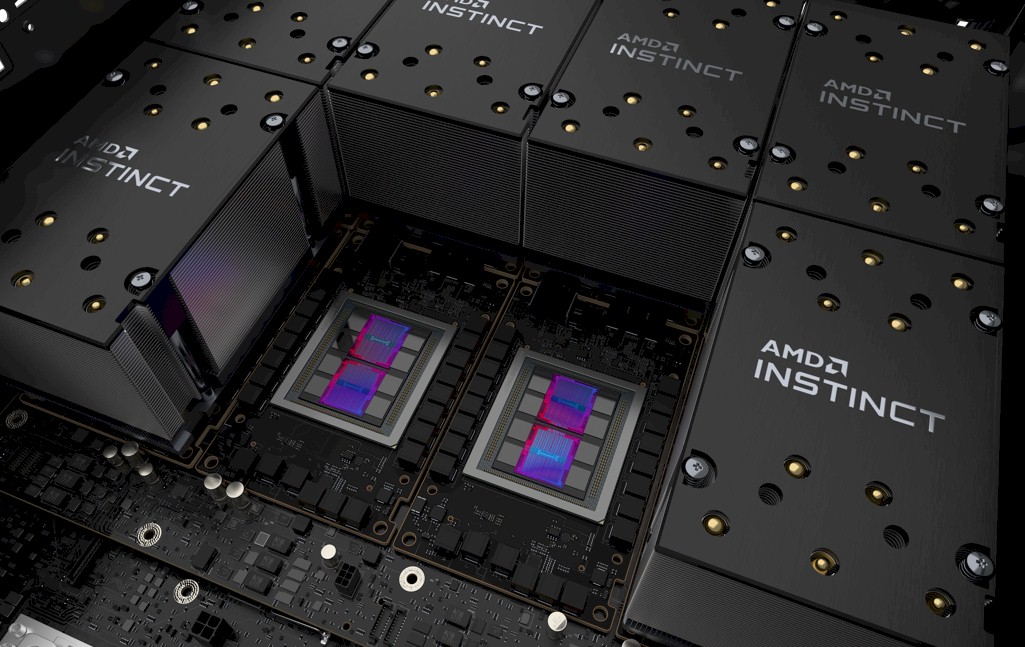

3rd Gen Infinity Fabric: Kohärenter Interconnect zwischen Instinct und EPYC

www.hardwareluxx.de

Vor allem gegenüber Nvidia ist dies ein enormer Vorteil, da sie als einziger von den dreien nicht CPU+GPU anbieten und die Vorteile sind nicht von der Hand zu weisen.

AMD wird hier am Ball bleiben und vergleichsweise zeitnah CDNA3 nachreichen müssen, wenn sie in 2022 nicht abgehängt werden wollen, denn bei Intel darf man vermuten, dass deren Ponte Vecchio-Nachfolger bei deren Ressourcen (sowohl intern wie extern) schon in recht enger Taktung eingeplant sein wird. Beispielsweise wird Intel offensichtlich TSMCs 3nm deutlich vor AMD nutzen; die konkreten Produkte sind jedoch noch nicht bekannt, könnten also CPUs wie auch Beschleuniger sein.

Erstmal hat intel zu liefern und dann sehen wir mal, inwiefern AMD und nvidia so dringend reagieren müssen... Aber immer wieder amüssant, wie du ausschließlich nur bei AMD diese Probleme siehst.

Bezüglich der Fertigung, auch wenn AMD die 3nm erst später nutzt wo ist das Problem? Offensichtlich können sie mit 6nm schon eine sehr gute Lösung bieten und es sind ja auch immer die Stückzahlen entscheidend. Wenn man mit einem älteren Prozess deutlich mehr Wafer bekommt, ist es durchaus eine Überlegung wert diesen zu nutzen. Hat Nvidia mit Samsung 8nm doch auch gemacht und das war alles andere wie ein Fehler.

Wie nVidia dagegen für zukünftige Designs die Gewichtung zwischen FP64 und ML/Matrixoperationen ausbalancieren wird, wird man abwarten müssen. Oder vielleicht wird es auch für Hopper zwei unterschiedlich ausgelegte Dies geben, eher ein universelleres Die, das wie bisher FP64 und ML verteilt und vielleicht ein ein eher FP64/HPC-lastiges Die?

Du beschreibst es doch richtig, WENN.

Niemand weiß wie nvidia ihren Fokus legt, alle Kochen nur mit Wasser und über ungelegte Eier, über die es keine Infos gibt so wild zu spekulieren...

Beispielsweise Intel hat (nach bisherigem Kenntnisstand) MCM-Xe-HPG auf die NextGen gelegt (möglicherweise bereits mit Battlemage in 2023) und nVidia sieht anscheinend gar keine Notwendigkeit hier AMDs Bemühungen mit einem MCM-Design kontern zu müssen und das könnten die zweifellos ebenso, denn die haben den gleichen Zugriff auf TSMC-Ressourcen und -Technologien wie AMD und verfügen zudem über weitaus mehr Ressourcen, da GPUs und Beschleuniger ihr Kerngeschäft sind (zumal Hopper bereits ein MCM-Design ist).

Das ist einfach nur Unsinn. Wieso sollte nvidia keine Notwendigkeit darin sehen, selbst ein MCM-Design zum Konter verwenden? Vielleicht schon mal daran gedacht, dass sie damit einfach später dran sind und es erst für die Lösung danach geplant ist? AMD war bei den CPUs damit ja auch vor intel an der Reihe... Und so Pläne macht man ja auch langfristig und ändert dann nicht mal so aus dem Handgelenk, nur weil der Konkurrenz schon eine Generation früher damit dran ist. Ist schon eine ganz schöne Überheblichkeit die du da an den Tag legst.

Zumal AMD aufgrund der CPU Geschichte in dem Bereich ja auch deutlich mehr Erfahrungen vorzuweisen hat.

Und bezüglich der Fertigung, auch wenn beide bei TSMC fertigen, kann es trotzdem gut sein, dass nvidia dies erstmal nicht nutzen kann/darf. Denn wenn dies z.B. in einer Entwicklungskoopertation entstanden ist, kann man das nämlich schon vertraglich ausschließen, dass die anderen dies erstmal nicht nutzen dürfen. Aber hierzu wissen wir nichts.

Wenn die der Meinung sind, dass die für Lovelace kein MCM-Design benötigen um mit RDNA3 konkurrieren zu können, sollte man erst mal davon ausgehen, dass die sich sehr wohl was dabei gedacht haben werden.

Das hat damit rein gar nichts zu tun, sondern wie oben schon erwähnt mit der Designplanung. In erster Linie geht es ja darum, auch kosteneffizienz zu produzieren und das ist irgendwann mit so Monsterchips für den Consumerbereich einfach nicht drin. Deswegen weicht man ja auf die MCM Designs aus, um die Leistung besser und vor allem kostengünstiger skalieren zu können.

Und wenn Nvidia das für sich erst für die übernächste Generation so entschlossen hat, ist das halt so. Kann auch genauso gut sein, dass sie sich damit vollkommen verkalkuliert haben. Vor allem wenn man sich anschaut, dass man aktuell von der Leistung her gleichauf ist, kann das durchaus sein, dass man im High End Bereich dann nichts entgegenzusetzen hat.