Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Du solltest ein Upgrade durchführen oder einen alternativen Browser verwenden.

Radeon RX 6600 (XT): Powercolor listet bereits erste Modelle

- Ersteller PCGH-Redaktion

- Erstellt am

Prozessorarchitektur

Lötkolbengott/-göttin

Nur blöd das dies nicht möglich ist

Es sind nativ 2434 fp32 alu/shader

Und 2434 fp16 alu/shader

Die fp16 können fp32 50% Operationen oder fp16 100% Operationen ausführen lediglich die zeit also Latenz entscheidet wie gut diese ausgelastet werden derzeitige test gehen von max 40% aus

allerdings nur mit einer high end cpu idem fall den r9 5900x bzw massiv oc ci9 11900k (ab 5,2ghz) 1080p

ideal sind machbar 50% somit ist die Rechnung so

4868shader *2 Operationen*1,9ghz/2/1000*1,4fach (40%)=12,94tf

Was etwa einer gtx1080ti FE entspricht 3584*2*1,8=12,9tf oder rtx2080s

3072*2*2=12,2tf

Zu release also dez waren es max 20-30%

genauer ermittele ich bei meinen test mit hoffentlich bald kommende bezahlbaren rtx 3060 unter 400€

Hab heute wieder den Zeitpunkt bei media markt verpasst. (asus 379€)

Die bisherigen werte sind grobe vergleiche aus techpowerup

vs meiner gpu das sind max. 88% zur FE edition der gtx1060 meine ist gut 11% schneller

somit dürfte um die 77% bis 83% schneller sein da bei den test die grundtaktrate von nur 1,77ghz zählt da aber alle bis zu 1,85ghz laufen

ist da mehr drin.

Sinnvoller wäre die rtx3060ti fe wenn diese den auch kaufbar wäre.

Einzig eins treibt mich zur rx3060 die 12GB vram

Das könnte sich durchaus in 2 Jahren als vorteilhaft erweisen.

Die große unbekannte ist direct storage und fsr

beides könnte den vram verkleinern und Leistung steigern.

offen ist nur eins wird dlss dxr auf rtx3060 retten. Bisher sieht das schlecht aus.

Amd Gegenpart ist da nicht besser

Generell ist die fp32 Leistung relativ zu sehen den die ipc ist seit 2006 am sinken

Allerdings sind es mehr shader die höher Takten

Wren anfänglich die unified shader deutlich in der ipc gestigen vs der alten getrennten shader technik von vertex und pixel

Somit wurden die beiden rechenwege kombiniert so das diese eine hohe ipc hatten.

Infolgedessen wurde das sehr warm. merke die fermi architektur gtx480 mit deren 32 alu pro sm 15sm

und dessen shader takt bei 1,4ghz und 700mhz coreclock

ipc etwa 0,41fps pro shader

kepler also gtx780ti liegt die shader ipc bei 0,034fps

somit sind es

0,41/0,034=1/12 dessen an ipc pro shader aber eben mehr

struktur 192alu pro sm vs 32 alu pro sm

Sin dahinter wärme ruktion da auch der takt von 1,4ghz auf 900mhz gesenkt wurde.

Dadurch wurden die gpu sparsamer und kühler.

diese techni ist bis heute so geblieben einzig die fp16 einheiten können zusärzlioch fp32 ausführen. un die shader struktur ist bei 96 fp32 einheiten effektiv

Nvidia rechnet aber 64 fp32 und 64shader fp16 Einheiten mit zu 32shader fp32 operationen möglich sind

ipc derzeit

100/7872=0,012fps pro shader sofern auch 50% fp16 funktionieren eher sind es weniger.

siehe 0,034/0,012=1/3 der ipc seit 2013

also insgesamt seit fermi 0,41/0,012=1/34

aber eben mehr shader mit mehr takt.

das ist ein parade bsp für Parallelisierung.

natürlich nehme ich 100% als fps an den ein so altes spiel mit festen fps würde sofort in ein cpu limit rennen und die alte gpu könnte es nicht mal starten. daher die Annahme von 100fps als bsp relativ zu gpu Leistung.

Einzig metro 2033 könnte nicht in eine cpu limit rennen in 4k

meine gtx1060 erreicht da nur 17,4fps

relativ wäre dann 17,4/1280*7872=107fps mit eine kleines Risiko von einen cpu limit.

zur rtx3060 wären es 35fps

Es sind nativ 2434 fp32 alu/shader

Und 2434 fp16 alu/shader

Die fp16 können fp32 50% Operationen oder fp16 100% Operationen ausführen lediglich die zeit also Latenz entscheidet wie gut diese ausgelastet werden derzeitige test gehen von max 40% aus

allerdings nur mit einer high end cpu idem fall den r9 5900x bzw massiv oc ci9 11900k (ab 5,2ghz) 1080p

ideal sind machbar 50% somit ist die Rechnung so

4868shader *2 Operationen*1,9ghz/2/1000*1,4fach (40%)=12,94tf

Was etwa einer gtx1080ti FE entspricht 3584*2*1,8=12,9tf oder rtx2080s

3072*2*2=12,2tf

Zu release also dez waren es max 20-30%

genauer ermittele ich bei meinen test mit hoffentlich bald kommende bezahlbaren rtx 3060 unter 400€

Hab heute wieder den Zeitpunkt bei media markt verpasst. (asus 379€)

Die bisherigen werte sind grobe vergleiche aus techpowerup

vs meiner gpu das sind max. 88% zur FE edition der gtx1060 meine ist gut 11% schneller

somit dürfte um die 77% bis 83% schneller sein da bei den test die grundtaktrate von nur 1,77ghz zählt da aber alle bis zu 1,85ghz laufen

ist da mehr drin.

Sinnvoller wäre die rtx3060ti fe wenn diese den auch kaufbar wäre.

Einzig eins treibt mich zur rx3060 die 12GB vram

Das könnte sich durchaus in 2 Jahren als vorteilhaft erweisen.

Die große unbekannte ist direct storage und fsr

beides könnte den vram verkleinern und Leistung steigern.

offen ist nur eins wird dlss dxr auf rtx3060 retten. Bisher sieht das schlecht aus.

Amd Gegenpart ist da nicht besser

Generell ist die fp32 Leistung relativ zu sehen den die ipc ist seit 2006 am sinken

Allerdings sind es mehr shader die höher Takten

Wren anfänglich die unified shader deutlich in der ipc gestigen vs der alten getrennten shader technik von vertex und pixel

Somit wurden die beiden rechenwege kombiniert so das diese eine hohe ipc hatten.

Infolgedessen wurde das sehr warm. merke die fermi architektur gtx480 mit deren 32 alu pro sm 15sm

und dessen shader takt bei 1,4ghz und 700mhz coreclock

ipc etwa 0,41fps pro shader

kepler also gtx780ti liegt die shader ipc bei 0,034fps

somit sind es

0,41/0,034=1/12 dessen an ipc pro shader aber eben mehr

struktur 192alu pro sm vs 32 alu pro sm

Sin dahinter wärme ruktion da auch der takt von 1,4ghz auf 900mhz gesenkt wurde.

Dadurch wurden die gpu sparsamer und kühler.

diese techni ist bis heute so geblieben einzig die fp16 einheiten können zusärzlioch fp32 ausführen. un die shader struktur ist bei 96 fp32 einheiten effektiv

Nvidia rechnet aber 64 fp32 und 64shader fp16 Einheiten mit zu 32shader fp32 operationen möglich sind

ipc derzeit

100/7872=0,012fps pro shader sofern auch 50% fp16 funktionieren eher sind es weniger.

siehe 0,034/0,012=1/3 der ipc seit 2013

also insgesamt seit fermi 0,41/0,012=1/34

aber eben mehr shader mit mehr takt.

das ist ein parade bsp für Parallelisierung.

natürlich nehme ich 100% als fps an den ein so altes spiel mit festen fps würde sofort in ein cpu limit rennen und die alte gpu könnte es nicht mal starten. daher die Annahme von 100fps als bsp relativ zu gpu Leistung.

Einzig metro 2033 könnte nicht in eine cpu limit rennen in 4k

meine gtx1060 erreicht da nur 17,4fps

relativ wäre dann 17,4/1280*7872=107fps mit eine kleines Risiko von einen cpu limit.

zur rtx3060 wären es 35fps

1. Preis auf AMD.com ist 650.86€, also $ UVP entsprechend umgerechnet.1: Die UVP liegt bei 679€ (wenn ich mich nicht irre)

2: Das Doppelte wären 1358€

3: Die 1044€ sind "nur" 54% drüber.

250€ und man kommt in Regionen, die ein gutes Herstellermodell langsam rechtfertigen. Bis zur UVP der normalen Version sind es natürlich noch etwas über 350€.

Immer noch Welten von den abgedrehten Zeiten entfernt.

2. Das Doppelte war auf deine "Reduktion" von 200-250€ bezogen

3. Eben, 54% Überzahlung für 7 Monate alte Hardware ist fernab von normal.

150€ Aufpreis muss schon ein verdammt gutes Boarddesign im Vergleich zum Ausgangsmodell sein. Die meisten sind keine 50€ wert

Meine Pulse Vega 56 hat neu 239€ gekostet, vor 2 Jahren. Also ja. Fortschritt schaut anders aus.Vega56/64 Leistungen für 350 Euro.

Also 350 unter normalen Verhältnissen.

Nicht unbedingt ein Fortschritt.

Zuletzt bearbeitet:

0ldN3rd

BIOS-Overclocker(in)

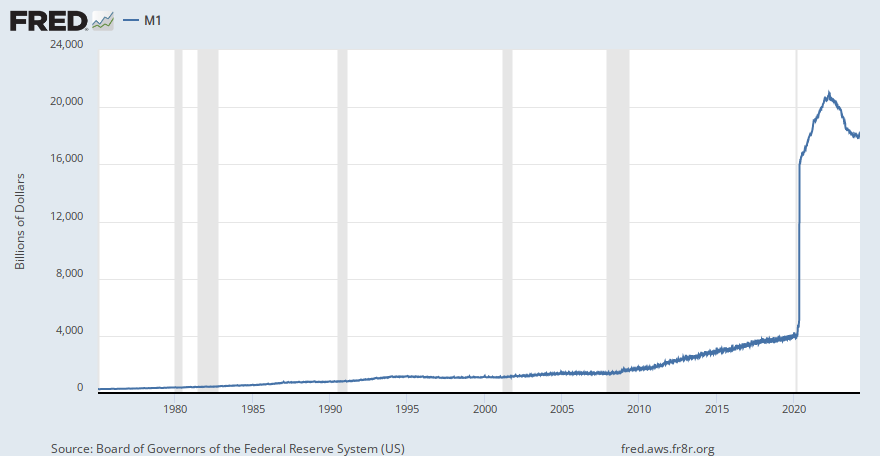

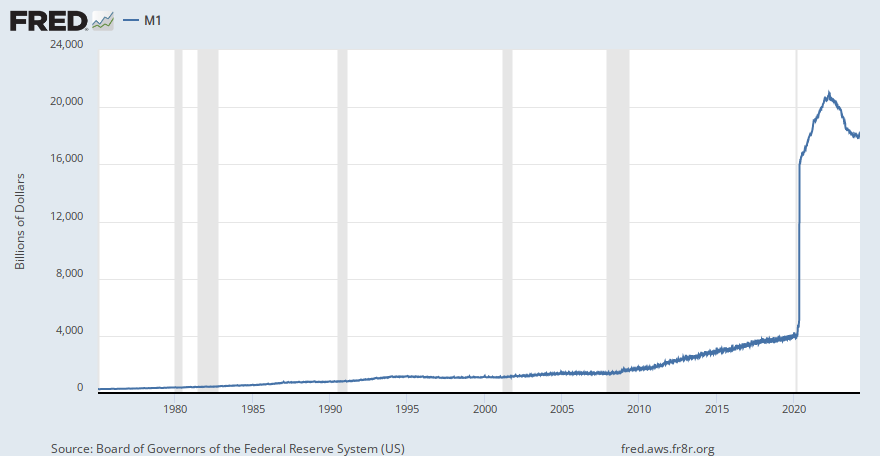

Was passiert wohl mit den Preisen, wenn man Geld druckt wie blöde?

Hier mal die Geldmenge im Umlauf in US-Dollar...

Die Info zum Euro liegt soweit ich es sehen konnte hinter einer Paywall... hat aber wohl einen ähnlichen Verlauf.

Also auf genau welcher wirtschaftlichen Mechanik sollen jetzt doch gleich die Preise für irgendwas fallen?

Zumal der ganze Klumbatsch in $ gehandelt wird... Rohmaterialien... usw...

Nur mal so als Frage für die, die erst wieder ne Mittelklasse GPU kaufen wenn es die für 200...300€ gibt... wie früher(TM)

Hier mal die Geldmenge im Umlauf in US-Dollar...

Die Info zum Euro liegt soweit ich es sehen konnte hinter einer Paywall... hat aber wohl einen ähnlichen Verlauf.

M1

View a measure of the most-liquid assets in the U.S. money supply: cash, checking accounts, traveler's checks, demand deposits, and other checkable deposits.

fred.stlouisfed.org

Also auf genau welcher wirtschaftlichen Mechanik sollen jetzt doch gleich die Preise für irgendwas fallen?

Zumal der ganze Klumbatsch in $ gehandelt wird... Rohmaterialien... usw...

Nur mal so als Frage für die, die erst wieder ne Mittelklasse GPU kaufen wenn es die für 200...300€ gibt... wie früher(TM)

Sidewinder

Freizeitschrauber(in)

So ist es! Wir neigen dazu alte Preise im Kopf zu haben und dabei die Inflation außer acht zu lassen. Wenn man im Jahre 2001 für eine Mittelklasse Grafikkarte 200€ ausgegeben hat, müsste man heute etwa 265€ ausgeben um auf die gleiche Kaufkraft zu kommen.Nur mal so als Frage für die, die erst wieder ne Mittelklasse GPU kaufen wenn es die für 200...300€ gibt... wie früher(TM)

0ldN3rd

BIOS-Overclocker(in)

@Sidewinder ja so in etwa, aber dies lässt die Geldschwemme von 2020 noch völlig außer acht......

Aktuell bin ich tatsächlich verwundert, dass der Laib Brot nicht schon 40,-€ kostet....

Aktuell bin ich tatsächlich verwundert, dass der Laib Brot nicht schon 40,-€ kostet....

Sidewinder

Freizeitschrauber(in)

Theoretisch macht es seitens AMD keinen Sinn Ressourcen für eine neue Grafikkarte unterhalb der 6700er zu verschwenden, die im 300+ € Bereich angesiedelt ist.

Normalerweise würde die 5700er diese Lücke füllen, leistungstechnisch sowie preislich - wenn man die unglückliche Situation am Grafikkarten Markt ausklammert wäre die lineare Preisabnahme in diesem Bereich.

Normalerweise würde die 5700er diese Lücke füllen, leistungstechnisch sowie preislich - wenn man die unglückliche Situation am Grafikkarten Markt ausklammert wäre die lineare Preisabnahme in diesem Bereich.

Registrierzwang

Software-Overclocker(in)

? Die Inflationsrate ist zwar auf ca. 2% inzwischen gestiegen, aber hauptsächlich wegen den gestiegenen Energiepreisen.So ist es! Wir neigen dazu alte Preise im Kopf zu haben und dabei die Inflation außer acht zu lassen. Wenn man im Jahre 2001 für eine Mittelklasse Grafikkarte 200€ ausgegeben hat, müsste man heute etwa 265€ ausgeben um auf die gleiche Kaufkraft zu kommen.

Ich glaube bei Dir nennt sich das Realitätsverlust wenn Du der Meinung bist, die Grafikkartenpreise müssten um 25% steigen und das wäre noch "normal "...

belle

PCGH-Community-Veteran(in)

Natürlich ist es zum Teil Abzocke, aber es gibt scheinbar genügend Nutzer, die mitmachen. Ich habe 25% Aufpreis als Schmerzgrenze in Kauf genommen.Ich glaube bei Dir nennt sich das Realitätsverlust wenn Du der Meinung bist, die Grafikkartenpreise müssten um 25% steigen und das wäre noch "normal "...

Interessant wäre Navi 23 in Form der RX 6600 XT für mich mit der Möglichkeit auf PCIe 3.0 16x und mit 64 MiB Infinity Cache wegen zukünftig WQHD gewesen, aber das wird nun wohl beides nicht geboten.

Zuletzt bearbeitet:

JackA

Lötkolbengott/-göttin

Kann man so nicht vergleichen. Es kommt immer drauf an, wie viel Leistung man in der aktuellen High-Class mehr bekommt.So ist es! Wir neigen dazu alte Preise im Kopf zu haben und dabei die Inflation außer acht zu lassen. Wenn man im Jahre 2001 für eine Mittelklasse Grafikkarte 200€ ausgegeben hat, müsste man heute etwa 265€ ausgeben um auf die gleiche Kaufkraft zu kommen.

Damalige untere Mittelklasse z.B: 8800 GTS kostete 330€ und die höhere Mittelklasse 8800 GTX 430€ und die High-Class 8800 ULTRA kostete 650€. Also in der Mittelklasse hat sich nicht viel getan bei den Preisen. Die High-Class ist nur teurer geworden, wo man aber eben abwägen muss, wie viel mehr Leistung ich heute von der High-Class bekomme im Vergleich zur damaligen High-Class.

XXTREME

Lötkolbengott/-göttin

2070 non S bzw. 2060S vermutlich.Wo reicht sich denn die Leistung ca. ein im Vergleich zu den Nvidia Karten?

Die 8800 G80 Karten waren durchweg High End und nicht Mittelklasse KartenKann man so nicht vergleichen. Es kommt immer drauf an, wie viel Leistung man in der aktuellen High-Class mehr bekommt.

Damalige untere Mittelklasse z.B: 8800 GTS kostete 330€ und die höhere Mittelklasse 8800 GTX 430€ und die High-Class 8800 ULTRA kostete 650€. Also in der Mittelklasse hat sich nicht viel getan bei den Preisen. Die High-Class ist nur teurer geworden, wo man aber eben abwägen muss, wie viel mehr Leistung ich heute von der High-Class bekomme im Vergleich zur damaligen High-Class.

. Mittelklasse waren seinerzeit die 8600GTS und GT. Selbst der später erschienene G92 Chip war niemals "Mittelklasse" sondern gehörte der Performance bzw. Oberklasse an.

. Mittelklasse waren seinerzeit die 8600GTS und GT. Selbst der später erschienene G92 Chip war niemals "Mittelklasse" sondern gehörte der Performance bzw. Oberklasse an.

Zuletzt bearbeitet:

Vega56/64 Leistungen für 350 Euro.

Also 350 unter normalen Verhältnissen.

Nicht unbedingt ein Fortschritt.

200€ waren damals aber nicht Mittelklasse, sondern schon High End.So ist es! Wir neigen dazu alte Preise im Kopf zu haben und dabei die Inflation außer acht zu lassen. Wenn man im Jahre 2001 für eine Mittelklasse Grafikkarte 200€ ausgegeben hat, müsste man heute etwa 265€ ausgeben um auf die gleiche Kaufkraft zu kommen.

Die HD Radeon 4850 hat mich 2008 um die 150€ gekostet (Release MSRP 200$), die 4870 (Release MSRP 300$) gab es ab 230€, darüber kamen nur mehr Dualkarten.

Das Pendant war damals das immer etwas teurere Nvidia mit den 8800er Karten (Release MSRP 350$). Ausgenommen die GTX, die ist aber das Pendant zur 3090 heute und wurde um 599$ released und ist meiner Erinnerung nach schnell im Preis gefallen.

Der Dollar war damals auch recht schwach im Vergleich. 300$ waren an die 200€, plus Steuer also 240-250€

Und das Argument vom Kaufkraftverlust zieht sowieso nicht über einen Zeitraum von 2 Jahren 45% mehr für ungefähr die selbe Leistung zu zahlen. So stark war die Inflation nicht.

Blackout27

Lötkolbengott/-göttin

2070 non S bzw. 2060S vermutlich.

Die 8800 G80 Karten waren durchweg High End und nicht Mittelklasse Karten. Mittelklasse waren seinerzeit die 8600GTS und GT. Selbst der später erschienene G92 Chip war niemals "Mittelklasse" sondern gehörte der Performance bzw. Oberklasse an.

"Blackout streichelt liebevoll seine 8800 Ultra als er dieses Kommentar liest" ^^

Die Preise sind schon arg hochgeschlossen in den letzten Jahren. Gerade in der Mittelklasse stört es doch sehr. Unter 250€ bekommt man nicht mehr so viel geboten wie vor ein paar Jahren noch.

Mich würde mal interessieren wie hoch die Margen bei Nvidia und AMD heute sind (UVP).

belle

PCGH-Community-Veteran(in)

Die Karte sind noch immer viel zu teuer, das steht außer Frage und da muss man dir auch zustimmen.2070 non S bzw. 2060S vermutlich.

Mittelklasse waren seinerzeit die 8600GTS und GT. Selbst der später erschienene G92 Chip war niemals "Mittelklasse" sondern gehörte der Performance bzw. Oberklasse an.

Ich hoffe nur, dass die Preise von Mittelklassekarten nicht bei 300 bis 450€ verharren und man irgendwann wieder brauchbare Karten um 250 - 300€ sieht. Die Oberklasse wird wohl teuer bleiben, was Verbreitung von 4K-Monitoren nicht gerade antreiben dürfte.

Eine Grafikkarte kaufen viele aller paar Jahre und wenn schon nach einem Jahr gewechselt wird, wird die alte Karte meist verkauft. Das mag ein Grund sein, warum viele ~25% noch hinnehmen.Aktuell bin ich tatsächlich verwundert, dass der Laib Brot nicht schon 40,-€ kostet....

Die billigen Preise vor allem von Vega56 teils unter 250€ sehe ich allerdings eher als einzigartigen Abverkauf einer insgesamt unbeliebten Generation - auch wenn das zu dem Preis ein Geheimtipp war.

War bei den Nvidia 900ern ja nicht anders, und die waren durchaus beliebt.Die billigen Preise vor allem von Vega56 teils unter 250€ sehe ich allerdings eher als einzigartigen Abverkauf einer insgesamt unbeliebten Generation - auch wenn das zu dem Preis ein Geheimtipp war.

Den Preisverfall gibt es derzeit einfach nicht.

RyzA

PCGH-Community-Veteran(in)

Ja. Den haben wir aber leider nicht. Und mehr als 300 Euro dafür ist nen Wucher.So gesehen ist die rx6600xt die perfekte Einsteiger klasse bis 200€ wenn wir einen normalen markt hätten.

deady1000

Volt-Modder(in)

Wie schnell soll denn die Karte werden? Finde dazu nix.

Ist die schneller als eine GTX1080?

Falls nein, dann wäre mir die Karte keine 300€ wert.

Vom Design her ganz süß, aber die Specs und der Single-Fan deuten schon an, dass es sich um das Low-Budget handelt.

Kennt ihr diese Leute, die noch alles in DM umrechnen? Man könnte jetzt sagen, dass man vor ca 6-7J noch für 329€ eine GTX 970 bekommen konnte. Heute bekommt man für die Kohle nur noch das Billigste vom Billigen.

EDIT:

Dann wäre die ja tatsächlich ziemlich exakt auf dem Niveau einer GTX1080.

Für mehr Informationen besuche die Datenschutz-Seite.

Ist die schneller als eine GTX1080?

Falls nein, dann wäre mir die Karte keine 300€ wert.

Vom Design her ganz süß, aber die Specs und der Single-Fan deuten schon an, dass es sich um das Low-Budget handelt.

Kennt ihr diese Leute, die noch alles in DM umrechnen? Man könnte jetzt sagen, dass man vor ca 6-7J noch für 329€ eine GTX 970 bekommen konnte. Heute bekommt man für die Kohle nur noch das Billigste vom Billigen.

EDIT:

Wo reicht sich denn die Leistung ca. ein im Vergleich zu den Nvidia Karten?

Ups, jetzt erst gesehen.

Dann wäre die ja tatsächlich ziemlich exakt auf dem Niveau einer GTX1080.

Eingebundener Inhalt

Youtube

An dieser Stelle findest du externe Inhalte von Youtube. Zum Schutz deiner persönlichen Daten werden externe Einbindungen erst angezeigt, wenn du dies durch Klick auf "Alle externen Inhalte laden" bestätigst:

Ich bin damit einverstanden, dass mir externe Inhalte angezeigt werden. Damit werden personenbezogene Daten an Drittplattformen übermittelt.Für mehr Informationen besuche die Datenschutz-Seite.

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 38

- Aufrufe

- 1K

- Antworten

- 21

- Aufrufe

- 1K

- Antworten

- 44

- Aufrufe

- 2K

- Antworten

- 9

- Aufrufe

- 1K

- Antworten

- 8

- Aufrufe

- 1K