Moin zusammen.

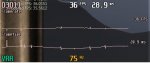

Seit G-Sync auch auf Freesync-Monitoren funktioniert, teste ich auch das bei den Monitoren. Wie bei solchen, die nativ G-Sync unterstützen, klappt das auf der ganzen Range, also bspw. 1 bis 100 Hz, was ich mit Frame Limits per RTSS auch abklopfe, wie erst kürzlich etwa beim Samsung C34H890, der an sich Freesync ohne LFC zwischen 48-100 Hz. Auch Freesync selbst habe ich getestet und im Gegensatz zu G-Sync funktioniert das auch nur ab ca. 48 Hz.

Dass nun G-Sync mit einem Freesync-Monitor besser funktioniert als Freesync selbst, ist zwar seltsam, aber immerhin technisch logisch, da der Nvidia-Treiber die Hz wohl unterhalb 48 verdoppeln –vielfachen kann,

Kurios wird das Ganze aber bei Monitoren mit noch kleinerer Freesync-Spanne. Habe etwa den LG 38WK95 hier, der mit 56-75 Hz angegeben ist – natürlich ohne LFC. Hier dasselbe Verhalten: Freesync natürlich ohne LFC, funktioniert nur in dieser kurzen Spanne. G-Sync aber funktioniert wieder zwischen 1-75 Hz, was aber technisch nicht logisch erscheint, da zwischen 35 und 56 Fps die Frequenz ja nicht verdoppelt werden kann. Nun bin ich ratlos und ich vermute daher irgendeinen Puffer oder sonstigen Cheat - ich kann aktuell nur raten.

Mein Problem ist aktuell, dass G-Sync so gut funktioniert bzw. vielmehr, dass ich mir das technisch nicht erklären kann. Daher wollte ich die eventuell hier vorhandene Weißheit anzapfen fürs qualifizierte Spekulieren.

bzw. vielmehr, dass ich mir das technisch nicht erklären kann. Daher wollte ich die eventuell hier vorhandene Weißheit anzapfen fürs qualifizierte Spekulieren.

Hat vielleicht sogar jemand einen Freesync-Monitor mit knapper Spanne, die eigentlich nicht LFC-fähig ist und könnte die untere Grenze per Frame Limit prüfen?

Danke

Manuel

Seit G-Sync auch auf Freesync-Monitoren funktioniert, teste ich auch das bei den Monitoren. Wie bei solchen, die nativ G-Sync unterstützen, klappt das auf der ganzen Range, also bspw. 1 bis 100 Hz, was ich mit Frame Limits per RTSS auch abklopfe, wie erst kürzlich etwa beim Samsung C34H890, der an sich Freesync ohne LFC zwischen 48-100 Hz. Auch Freesync selbst habe ich getestet und im Gegensatz zu G-Sync funktioniert das auch nur ab ca. 48 Hz.

Dass nun G-Sync mit einem Freesync-Monitor besser funktioniert als Freesync selbst, ist zwar seltsam, aber immerhin technisch logisch, da der Nvidia-Treiber die Hz wohl unterhalb 48 verdoppeln –vielfachen kann,

Kurios wird das Ganze aber bei Monitoren mit noch kleinerer Freesync-Spanne. Habe etwa den LG 38WK95 hier, der mit 56-75 Hz angegeben ist – natürlich ohne LFC. Hier dasselbe Verhalten: Freesync natürlich ohne LFC, funktioniert nur in dieser kurzen Spanne. G-Sync aber funktioniert wieder zwischen 1-75 Hz, was aber technisch nicht logisch erscheint, da zwischen 35 und 56 Fps die Frequenz ja nicht verdoppelt werden kann. Nun bin ich ratlos und ich vermute daher irgendeinen Puffer oder sonstigen Cheat - ich kann aktuell nur raten.

Mein Problem ist aktuell, dass G-Sync so gut funktioniert

bzw. vielmehr, dass ich mir das technisch nicht erklären kann. Daher wollte ich die eventuell hier vorhandene Weißheit anzapfen fürs qualifizierte Spekulieren.

bzw. vielmehr, dass ich mir das technisch nicht erklären kann. Daher wollte ich die eventuell hier vorhandene Weißheit anzapfen fürs qualifizierte Spekulieren.Hat vielleicht sogar jemand einen Freesync-Monitor mit knapper Spanne, die eigentlich nicht LFC-fähig ist und könnte die untere Grenze per Frame Limit prüfen?

Danke

Manuel